Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questa pagina descrive come sviluppare codice nei notebook di Databricks, tra cui formattazione del codice, completamento automatico, combinazione di linguaggi e comandi magic.

Per altre informazioni sulle funzionalità avanzate disponibili con l'editor, come il completamento automatico, la selezione di variabili, il supporto di più cursori e i confronti affiancati, consultare Esplorare il notebook e l'editor di file di Databricks.

Quando si usa il notebook o l'editor di file, Databricks Assistant è disponibile per facilitare la generazione, la spiegazione e il debug del codice. Per altre informazioni, vedere Utilizzo di Databricks Assistant.

I notebook di Databricks includono anche un debugger interattivo predefinito per i notebook Python. Consulta Notebook di debug.

Importante

Il notebook deve essere collegato a una sessione di calcolo attiva per le funzionalità di assistenza del codice, tra cui completamento automatico, formattazione del codice Python e debugger.

Modularizzare il codice

Con Databricks Runtime 11.3 LTS e versioni successive, è possibile creare e gestire file di codice sorgente nell'area di lavoro di Azure Databricks e quindi importarli nei notebook in base alle esigenze.

Per altre informazioni sull'uso dei file di codice sorgente, vedere Condividere codice tra notebook di Databricks e Lavorare con i moduli Python e R.

Formattare le celle di codice

Azure Databricks offre degli strumenti che consentono di formattare codice Python e SQL nelle celle del notebook in modo rapido e semplice. Questi strumenti riducono lo sforzo necessario per mantenere formattato il codice e consentono di applicare gli stessi standard di codifica nei notebook.

Libreria Black del formattatore di Python

Importante

Questa funzionalità è disponibile in anteprima pubblica.

Azure Databricks supporta la formattazione del codice Python usando black all'interno del notebook. Il notebook deve essere collegato a un cluster con i pacchetti Python black e tokenize-rt installati.

In Databricks Runtime 11.3 LTS e versioni successive, Azure Databricks preinstalla black e tokenize-rt. È possibile usare il formattatore direttamente senza dover installare queste librerie.

In Databricks Runtime 10.4 LTS e versioni precedenti, è necessario installare black==22.3.0 e tokenize-rt==4.2.1 da PyPI nel notebook o nel cluster per usare il formattatore Python. Eseguire il comando seguente nel notebook:

%pip install black==22.3.0 tokenize-rt==4.2.1

oppure installare la libreria nel cluster.

Per altre informazioni sull'installazione delle librerie, vedere Gestione degli ambienti Python.

Per i file e i notebook nelle cartelle Git di Databricks, è possibile configurare il formattatore Python in base al file pyproject.toml. Per usare questa funzionalità, creare un file pyproject.toml nella directory radice della cartella Git e configurarlo in base al formato di configurazione Black. Modificare la sezione [tool.black] nel file. La configurazione viene applicata quando si formatta qualsiasi file e taccuino in quella cartella Git.

Come formattare le celle Python e SQL

È necessario disporre dell'autorizzazione CAN EDIT nel notebook per formattare il codice.

Azure Databricks usa un formattatore SQL personalizzato per formattare SQL e il formattatore di codice nero per Python.

È possibile avviare un formattatore nei seguenti modi:

Formattare una singola cella

- Tasto di scelta rapida: premere CMD+MAIUSC+F.

- Menu contestuale dei comandi:

- Formato cella SQL: Seleziona Formato SQL nel menu a tendina del contesto dei comandi di una cella SQL. Questa voce di menu è visibile solo nelle celle del notebook SQL o in quelle con una

%sqlmagia del linguaggio. - Formatta cella Python: selezionare Formato Python nel menu a discesa del comando di una cella Python. Questa voce di menu è visibile solo nelle celle del notebook Python o in quelle con una

%pythonfunzionalità magica del linguaggio.

- Formato cella SQL: Seleziona Formato SQL nel menu a tendina del contesto dei comandi di una cella SQL. Questa voce di menu è visibile solo nelle celle del notebook SQL o in quelle con una

- Notebook Modifica menu: selezionare una cella Python o SQL e quindi selezionare Modifica formato cella(e) >.

Formattare più celle

Selezionare più celle e quindi selezionare Modifica > Formato Celle. Se si selezionano celle di più linguaggio, vengono formattate solo le celle SQL e Python. Sono inclusi quelli che usano

%sqle%python.Formattare tutte le celle Python e SQL nel notebook

selezionare modifica > formato Notebook. Se il notebook contiene più di un linguaggio, vengono formattate solo le celle SQL e Python. Sono inclusi quelli che usano

%sqle%python.

Per personalizzare la formattazione delle query SQL, vedere Istruzioni SQL in formato personalizzato.

Limitazioni della formattazione del codice

- Black impone gli standard PEP 8 per il rientro di 4 spazi. Il rientro non è configurabile.

- La formattazione di stringhe Python incorporate all'interno di una UDF SQL non è supportata. Analogamente, la formattazione di stringhe SQL all'interno di una UDF Python non è supportata.

Linguaggi di codice nei notebook

Impostare la lingua predefinita

La lingua predefinita per il notebook viene visualizzata sotto il nome del notebook.

Per modificare la lingua predefinita, fare clic sul pulsante lingua e selezionare la nuova lingua dal menu a discesa. Per assicurarsi che i comandi esistenti continuino a funzionare, i comandi della lingua predefinita precedente vengono automaticamente preceduti da un comando magico della lingua.

Combinazioni di lingue

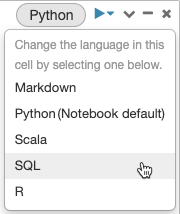

Per impostazione predefinita, le celle usano la lingua predefinita del notebook. È possibile eseguire la sostituzione della lingua predefinita in una cella cliccando sul pulsante lingua e selezionando una lingua dal menu a discesa.

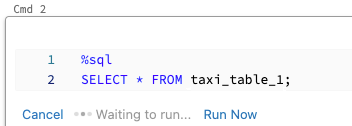

In alternativa, è possibile usare il comando magic del linguaggio %<language> all'inizio di una cella. I comandi magic supportati sono: %python, %r, %scala e %sql.

Nota

Quando si richiama un comando magico del linguaggio, il comando viene inviato al REPL nell'ambito del contesto di esecuzione del notebook. Le variabili definite in un linguaggio (e quindi nel REPL di tale lingua) non sono disponibili nel REPL di un altro linguaggio. I REPL possono condividere lo stato solo tramite risorse esterne, come file in DBFS od oggetti nell'archiviazione oggetti.

I notebook supportano anche alcuni comandi magic ausiliari:

-

%sh: consente di eseguire il codice della shell nel notebook. Per interrompere la cella se il comando shell ha uno stato di uscita diverso da zero, aggiungere l'opzione-e. Il comando viene eseguito solo sul driver Apache Spark e non sui lavoratori. Per eseguire un comando shell in tutti i nodi, usare uno script init. -

%fs: consente di usare i comandi del file systemdbutils. Ad esempio, per eseguire il comandodbutils.fs.lsper elencare i file, è possibile specificare%fs ls. Per altre informazioni, vedere Usare i file in Azure Databricks. -

%md: consente di includere vari tipi di documentazione, tra cui testo, immagini, formule matematiche ed equazioni. Vedi la sezione successiva.

Evidenziazione della sintassi SQL e completamento automatico nei comandi Python

L'evidenziazione della sintassi e il completamento automatico di SQL sono disponibili quando si usa SQL all'interno di un comando Python, ad esempio in un comando spark.sql.

Esplorare i risultati delle celle SQL

In un notebook di Databricks i risultati di una cella del linguaggio SQL vengono resi automaticamente disponibili come dataframe impliciti assegnati alla variabile _sqldf. È quindi possibile usare questa variabile in qualsiasi cella Python e SQL eseguita in un secondo momento, indipendentemente dalla posizione nel notebook.

Nota

Questa funzionalità presenta le limitazioni seguenti:

- La

_sqldfvariabile non è disponibile nei notebook che usano un'istanza SQL Warehouse per il calcolo. - L'uso

_sqldfnelle celle Python successive è supportato in Databricks Runtime 13.3 e versioni successive. - L'uso

_sqldfnelle celle SQL successive è supportato solo in Databricks Runtime 14.3 e versioni successive. - Se la query usa le parole chiave

CACHE TABLEoUNCACHE TABLE, la_sqldfvariabile non è disponibile.

Lo screenshot seguente mostra come _sqldf può essere usato nelle celle successive di Python e SQL.

Importante

La variabile _sqldf viene riassegnata ogni volta che viene eseguita una cella SQL. Per evitare di perdere il riferimento a un risultato specifico del dataframe, assegnarlo a un nuovo nome di variabile prima di eseguire la cella SQL successiva:

Pitone

new_dataframe_name = _sqldf

SQL

ALTER VIEW _sqldf RENAME TO new_dataframe_name

Eseguire celle di codice SQL in parallelo

Mentre un comando è in esecuzione e il notebook è collegato a un cluster interattivo, è possibile eseguire una cella SQL contemporaneamente con il comando corrente. La cella SQL viene eseguita in una nuova sessione parallela.

Per eseguire una cella in parallelo:

Cliccare Run now (Esegui adesso). La cella viene eseguita immediatamente.

Poiché la cella viene eseguita in una nuova sessione, le viste temporanee, le funzioni definite dall'utente (UDF) e il DataFrame Python implicito (_sqldf) non sono supportati per le celle eseguite in parallelo. Inoltre, i nomi predefiniti del catalogo e del database vengono usati durante l'esecuzione parallela. Se il codice fa riferimento a una tabella in un catalogo o un database diverso, è necessario specificare il nome della tabella usando lo spazio dei nomi a tre livelli (catalog.schema.table).

Esegui celle SQL su un magazzino SQL

È possibile eseguire comandi SQL in un notebook di Databricks in un SQL Warehouse, un tipo di calcolo ottimizzato per l'analisi SQL. Consultare Usare un notebook con un magazzino SQL.

Usare i comandi magici

I notebook di Databricks supportano vari comandi magic che estendono la funzionalità oltre la sintassi standard per semplificare le attività comuni. I comandi magici sono preceduti da % per i comandi magici di riga e di cella.

| Comando magico | Esempio | Descrizione |

|---|---|---|

%python |

%pythonprint("Hello") |

Cambia il linguaggio delle celle in Python. Esegue il codice Python nella cella. |

%r |

%rprint("Hello") |

Passare dal linguaggio delle celle a R. Esegue il codice R nella cella. |

%scala |

%scalaprintln("Hello") |

Cambia il linguaggio della cella a Scala. Esegue il codice Scala nella cella. |

%sql |

%sqlSELECT * FROM table |

Modificare il linguaggio della cella in SQL. I risultati sono disponibili come _sqldf nelle celle Python/SQL. |

%md |

%md# TitleContent here |

Cambiare la lingua della cella in Markdown. Esegue il rendering del contenuto Markdown nella cella. Supporta testo, immagini, formule e LaTeX. |

%pip |

%pip install pandas |

Installare pacchetti Python (con ambito notebook). Vedere Librerie Python specifiche per notebook. |

%run |

%run /path/to/notebook |

Eseguire un altro notebook, importando le funzioni e le variabili. Vedere Flussi di lavoro dei notebook. |

%fs |

%fs ls /path |

Eseguire i comandi del file system dbutils. Sintassi abbreviata dei comandi dbutils.fs. Consultare Usare i file. |

%sh |

%sh ls -la |

Eseguire i comandi della shell. Viene eseguito solo nel nodo driver. Usare -e per non riuscire in caso di errore. |

%tensorboard |

%tensorboard --logdir /logs |

Visualizza l'interfaccia utente di TensorBoard in linea. Disponibile solo in Databricks Runtime ML. Vedere TensorBoard. |

%set_cell_max_output_size_in_mb |

%set_cell_max_output_size_in_mb 10 |

Imposta la dimensione massima dell'output delle celle. Intervallo: 1-20 MB. Si applica a tutte le celle successive nel notebook. |

%skip |

%skipprint("This won't run") |

Salta l'esecuzione della cella. Impedisce l'esecuzione della cella quando viene eseguito il notebook. |

Nota

IPython Automagic: i notebook di Databricks hanno IPython automagic abilitato per impostazione predefinita, consentendo il funzionamento di alcuni comandi come pip senza il % prefisso. Ad esempio, pip install pandas funziona come %pip install pandas.

Importante

- Le variabili e lo stato sono isolati tra diversi REPLs del linguaggio. Ad esempio, le variabili Python non sono accessibili nelle celle Scala.

- Deve essere la prima riga della cella, e una cella del notebook può contenere un solo comando magic.

-

%rundeve trovarsi in una cella singola, perché esegue l'intero notebook in linea. - Quando si usa

%pipin Databricks Runtime 12.2 LTS e versioni precedenti, inserire tutti i comandi di installazione dei pacchetti all'inizio del notebook poiché lo stato di Python viene reimpostato dopo l'installazione.