Notitie

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen u aan te melden of de directory te wijzigen.

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen de mappen te wijzigen.

In deze quickstart gebruikt u een Azure Resource Manager-sjabloon (ARM-sjabloon) om een Apache Hadoop-cluster te maken in Azure HDInsight. Hadoop was het originele open-source framework voor gedistribueerde verwerking en analyse van sets met big data in clusters. Het Hadoop-ecosysteem omvat verwante software en hulpprogramma's, waaronder Apache Hive, Apache HBase, Spark en Kafka.

Een Azure Resource Manager-sjabloon is een JSON-bestand (JavaScript Object Notation) dat de infrastructuur en configuratie voor uw project definieert. Voor de sjabloon is declaratieve syntaxis vereist. U beschrijft de beoogde implementatie zonder de reeks programmeeropdrachten te schrijven om de implementatie te maken.

Op dit moment wordt HDInsight geleverd met zeven verschillende clustertypen. Elk clustertype ondersteunt een andere set onderdelen. Alle clustertypen ondersteunen Hive. Zie voor een lijst van ondersteunde onderdelen in HDInsight Wat is er nieuw in de Hadoop-clusterversies geleverd door HDInsight?

Als uw omgeving voldoet aan de vereisten en u benkend bent met het gebruik van ARM-sjablonen, selecteert u de knop Implementeren naar Azure. De sjabloon wordt in Azure Portal geopend.

Vereisten

Als u geen Azure-abonnement hebt, maakt u een gratis account voordat u begint.

De sjabloon controleren

De sjabloon die in deze quickstart wordt gebruikt, komt uit Azure-snelstartsjablonen.

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"metadata": {

"_generator": {

"name": "bicep",

"version": "0.26.54.24096",

"templateHash": "1839820966662864707"

}

},

"parameters": {

"clusterName": {

"type": "string",

"metadata": {

"description": "The name of the HDInsight cluster to create."

}

},

"clusterType": {

"type": "string",

"allowedValues": [

"hadoop",

"intractivehive",

"hbase",

"storm",

"spark"

],

"metadata": {

"description": "The type of the HDInsight cluster to create."

}

},

"clusterLoginUserName": {

"type": "string",

"metadata": {

"description": "These credentials can be used to submit jobs to the cluster and to log into cluster dashboards."

}

},

"clusterLoginPassword": {

"type": "securestring",

"minLength": 10,

"metadata": {

"description": "The password must be at least 10 characters in length and must contain at least one digit, one upper case letter, one lower case letter, and one non-alphanumeric character except (single-quote, double-quote, backslash, right-bracket, full-stop). Also, the password must not contain 3 consecutive characters from the cluster username or SSH username."

}

},

"sshUserName": {

"type": "string",

"metadata": {

"description": "These credentials can be used to remotely access the cluster. The username cannot be admin."

}

},

"sshPassword": {

"type": "securestring",

"minLength": 6,

"maxLength": 72,

"metadata": {

"description": "SSH password must be 6-72 characters long and must contain at least one digit, one upper case letter, and one lower case letter. It must not contain any 3 consecutive characters from the cluster login name"

}

},

"location": {

"type": "string",

"defaultValue": "[resourceGroup().location]",

"metadata": {

"description": "Location for all resources."

}

},

"HeadNodeVirtualMachineSize": {

"type": "string",

"defaultValue": "Standard_E4_v3",

"allowedValues": [

"Standard_A4_v2",

"Standard_A8_v2",

"Standard_E2_v3",

"Standard_E4_v3",

"Standard_E8_v3",

"Standard_E16_v3",

"Standard_E20_v3",

"Standard_E32_v3",

"Standard_E48_v3"

],

"metadata": {

"description": "This is the headnode Azure Virtual Machine size, and will affect the cost. If you don't know, just leave the default value."

}

},

"WorkerNodeVirtualMachineSize": {

"type": "string",

"defaultValue": "Standard_E4_v3",

"allowedValues": [

"Standard_A4_v2",

"Standard_A8_v2",

"Standard_E2_v3",

"Standard_E4_v3",

"Standard_E8_v3",

"Standard_E16_v3",

"Standard_E20_v3",

"Standard_E32_v3",

"Standard_E48_v3"

],

"metadata": {

"description": "This is the workdernode Azure Virtual Machine size, and will affect the cost. If you don't know, just leave the default value."

}

}

},

"variables": {

"defaultStorageAccount": {

"name": "[uniqueString(resourceGroup().id)]",

"type": "Standard_LRS"

}

},

"resources": [

{

"type": "Microsoft.Storage/storageAccounts",

"apiVersion": "2021-08-01",

"name": "[variables('defaultStorageAccount').name]",

"location": "[parameters('location')]",

"sku": {

"name": "[variables('defaultStorageAccount').type]"

},

"kind": "StorageV2",

"properties": {}

},

{

"type": "Microsoft.HDInsight/clusters",

"apiVersion": "2021-06-01",

"name": "[parameters('clusterName')]",

"location": "[parameters('location')]",

"properties": {

"clusterVersion": "4.0",

"osType": "Linux",

"clusterDefinition": {

"kind": "[parameters('clusterType')]",

"configurations": {

"gateway": {

"restAuthCredential.isEnabled": true,

"restAuthCredential.username": "[parameters('clusterLoginUserName')]",

"restAuthCredential.password": "[parameters('clusterLoginPassword')]"

}

}

},

"storageProfile": {

"storageaccounts": [

{

"name": "[replace(replace(concat(reference(resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name), '2021-08-01').primaryEndpoints.blob), 'https:', ''), '/', '')]",

"isDefault": true,

"container": "[parameters('clusterName')]",

"key": "[listKeys(resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name), '2021-08-01').keys[0].value]"

}

]

},

"computeProfile": {

"roles": [

{

"name": "headnode",

"targetInstanceCount": 2,

"hardwareProfile": {

"vmSize": "[parameters('HeadNodeVirtualMachineSize')]"

},

"osProfile": {

"linuxOperatingSystemProfile": {

"username": "[parameters('sshUserName')]",

"password": "[parameters('sshPassword')]"

}

}

},

{

"name": "workernode",

"targetInstanceCount": 2,

"hardwareProfile": {

"vmSize": "[parameters('WorkerNodeVirtualMachineSize')]"

},

"osProfile": {

"linuxOperatingSystemProfile": {

"username": "[parameters('sshUserName')]",

"password": "[parameters('sshPassword')]"

}

}

}

]

}

},

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name)]"

]

}

],

"outputs": {

"storage": {

"type": "object",

"value": "[reference(resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name), '2021-08-01')]"

},

"cluster": {

"type": "object",

"value": "[reference(resourceId('Microsoft.HDInsight/clusters', parameters('clusterName')), '2021-06-01')]"

}

}

}

Er worden twee Azure-resources gedefinieerd in de sjabloon:

- Microsoft.Storage/storageAccounts: een Azure Storage-account maken.

- Microsoft.HDInsight/cluster: een HDInsight-cluster maken.

De sjabloon implementeren

Selecteer de knop Implementeren in Azure onderaan om u aan te melden bij Azure en de ARM-sjabloon te openen.

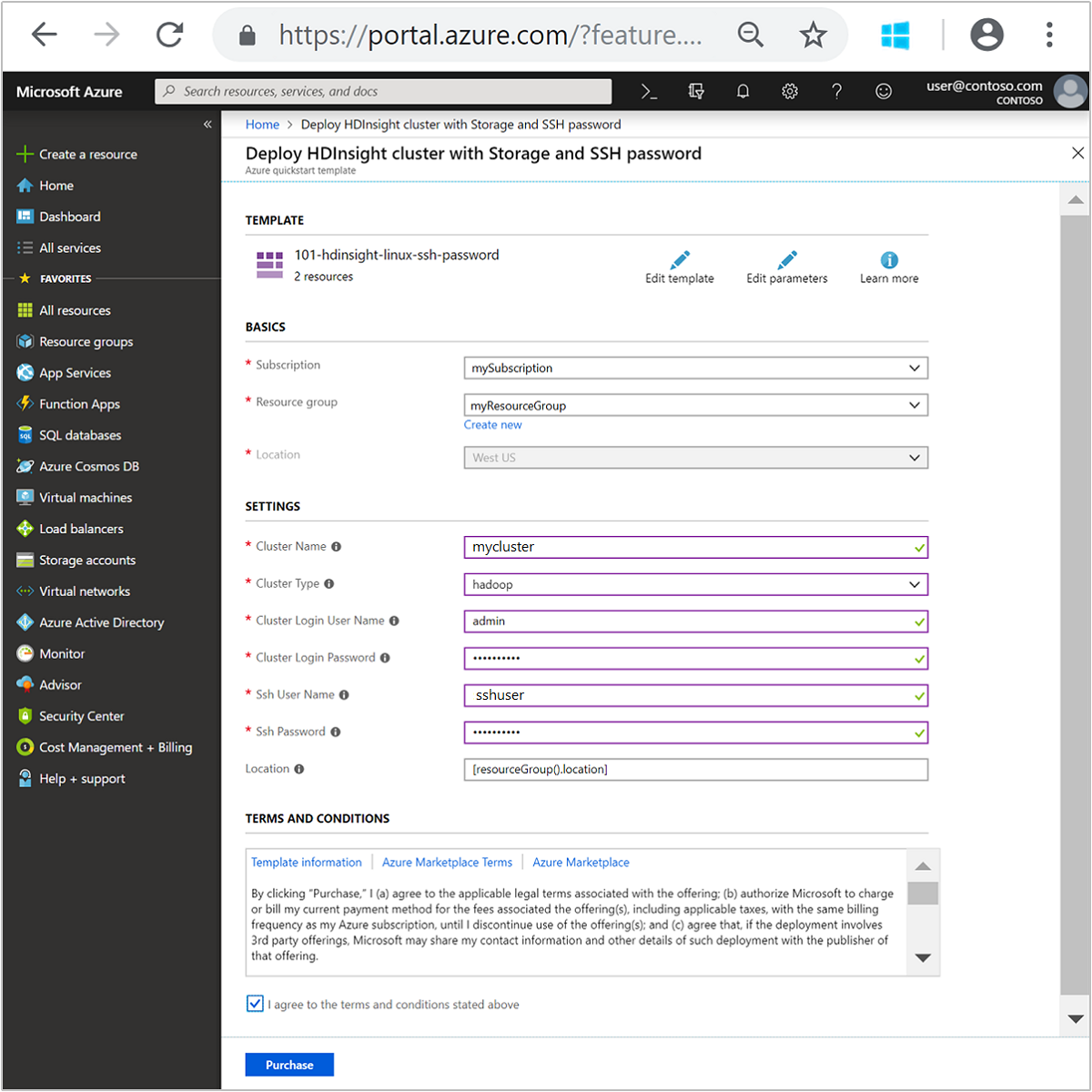

Typ of selecteer de volgende waarden:

Eigenschap Beschrijving Abonnement Selecteer in de vervolgkeuzelijst het Azure-abonnement dat wordt gebruikt voor het cluster. Resourcegroep Selecteer in de vervolgkeuzelijst de bestaande resourcegroep of selecteer Nieuwe maken. Locatie De waarde wordt automatisch ingevuld met de locatie die wordt gebruikt voor de resourcegroep. Clusternaam Voer een wereldwijd unieke naam in. Gebruik voor deze sjabloon alleen kleine letters en cijfers. Clustertype Selecteer hadoop. Gebruikersnaam voor clusteraanmelding Geef de gebruikersnaam op, de standaardwaarde is admin.Wachtwoord voor clusteraanmelding Geef een wachtwoord op. Het wachtwoord moet minstens 10 tekens lang zijn en moet ten minste één cijfer, één hoofdletter en één kleine letter, één niet-alfanumerieke teken (behalve tekens ' ` ") bevatten.Ssh-gebruikersnaam Geef de gebruikersnaam op, de standaardwaarde is sshuser.Ssh-wachtwoord Geef het wachtwoord op. Sommige eigenschappen zijn vastgelegd in de sjabloon. U kunt deze waarden uit de sjabloon configureren. Raadpleeg voor meer uitleg over deze eigenschappen Apache Hadoop-clusters maken in HDInsight.

Notitie

De opgegeven waarden moeten uniek zijn en moeten voldoen aan deze richtlijnen voor naamgeving. De sjabloon voert geen validatiecontroles uit. Als de waarden die u opgeeft, al in gebruik zijn of niet aan de richtlijnen voldoen, krijgt u een foutmelding nadat u de sjabloon hebt verzonden.

Bekijk de VOORWAARDEN. Selecteer vervolgens Ik ga akkoord met de bovenstaande voorwaarden en daarna Kopen. U ontvangt een melding dat uw implementatie wordt uitgevoerd. Het duurt ongeveer 20 minuten om een cluster te maken.

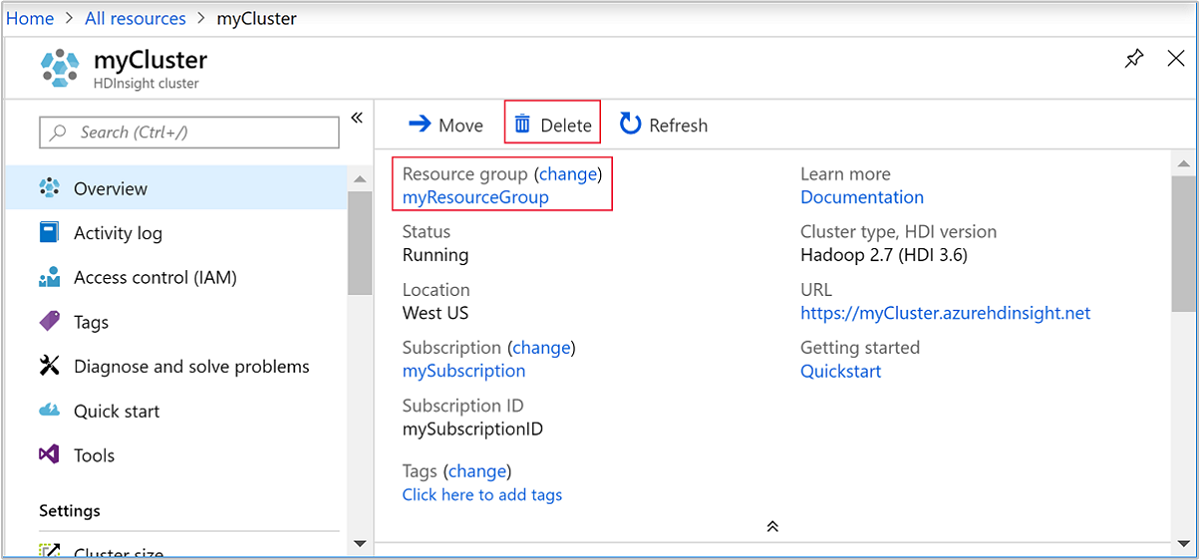

Ingezette middelen bekijken

Zodra het cluster is gemaakt, ontvangt u de melding Implementatie voltooid met de koppeling Naar de resource. Op de pagina Resourcegroep worden uw nieuwe HDInsight cluster en de standaardopslag verbonden met het cluster weergegeven. Elk cluster heeft een Azure Blob Storage-account of een Azure Data Lake Storage Gen2 afhankelijkheid. Dit wordt het standaardopslagaccount genoemd. Het HDInsight-cluster en het standaardopslagaccount moeten samen in dezelfde Azure-regio worden geplaatst. Het verwijderen van clusters leidt niet tot het verwijderen van het opslagaccount.

Notitie

Zie HDInsight-clusters maken voor andere methoden om clusters te maken en inzicht te krijgen in de eigenschappen die worden gebruikt in deze quickstart.

Middelen opschonen

Nadat u de quickstart hebt voltooid, kunt u overwegen het cluster te verwijderen. Met HDInsight worden uw gegevens opgeslagen in Azure Storage zodat u een cluster veilig kunt verwijderen wanneer deze niet wordt gebruikt. Voor een HDInsight-cluster worden ook kosten in rekening gebracht, zelfs wanneer het niet wordt gebruikt. Aangezien de kosten voor het cluster vaak zoveel hoger zijn dan de kosten voor opslag, is het financieel gezien logischer clusters te verwijderen wanneer ze niet worden gebruikt.

Notitie

Als u meteen verder wilt gaan met de volgende zelfstudie om te leren ETL-bewerkingen uit te voeren met behulp van Hadoop in HDInsight, is het goed om het cluster aan te laten staan. Dit komt doordat u in de zelfstudie opnieuw een Hadoop-cluster moet maken. Als u echter niet direct verdergaat met de volgende zelfstudie, moet u het cluster nu verwijderen.

Ga in de Azure-portal naar het cluster en selecteer Verwijderen.

U kunt ook de naam van de resourcegroep selecteren om de pagina van de resourcegroep te openen en vervolgens Resourcegroep verwijderen selecteren. Als u de resourcegroep verwijdert, verwijdert u zowel het HDInsight-cluster als het standaardopslagaccount.

Volgende stappen

In deze quickstart hebt u geleerd hoe u een Apache Hadoop-cluster in HDInsight maakt met behulp van een ARM-sjabloon. In het volgende artikel leert u hoe u een ETL-bewerking (Extraction, Transformation, Loading) uitvoert met behulp van Hadoop in HDInsight.