Uwaga

Dostęp do tej strony wymaga autoryzacji. Może spróbować zalogować się lub zmienić katalogi.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Modele rozwiązania Azure AI Foundry to kompleksowe rozwiązanie do odnajdywania, oceniania i wdrażania zaawansowanych modeli sztucznej inteligencji — niezależnie od tego, czy tworzysz niestandardowy element kopilot, kompilujesz agenta, ulepszasz istniejącą aplikację, czy eksplorujesz nowe możliwości sztucznej inteligencji.

Za pomocą modeli Foundry można wykonywać następujące czynności:

- Poznaj bogaty katalog nowoczesnych modeli firmy Microsoft, OpenAI, DeepSeek, Hugging Face, Meta i nie tylko.

- Porównaj i oceń modele obok siebie przy użyciu rzeczywistych zadań i własnych danych.

- Wdrażaj z ufnością dzięki wbudowanym narzędziom do dostrajania, wglądu i odpowiedzialnej sztucznej inteligencji.

- Wybierz ścieżkę — przynieś własny model, użyj hostowanego lub bezproblemowo zintegruj się z usługami platformy Azure.

- Niezależnie od tego, czy jesteś deweloperem, analitykiem danych, czy architektem przedsiębiorstwa, modele foundry zapewniają elastyczność i kontrolę nad tworzeniem rozwiązań sztucznej inteligencji, które są skalowane — bezpiecznie, odpowiedzialnie i szybko.

Usługa Azure AI Foundry oferuje kompleksowy wykaz modeli sztucznej inteligencji. Istnieje ponad 1900 modeli, począwszy od modeli podstawowych, modeli rozumowania, modeli małych języków, modeli wielomodalnych, modeli specyficznych dla domeny, modeli branżowych i innych.

Nasz katalog jest podzielony na dwie główne kategorie:

Zrozumienie rozróżnienia między tymi kategoriami pomaga wybrać odpowiednie modele na podstawie określonych wymagań i celów strategicznych.

Modele sprzedawane bezpośrednio przez platformę Azure

Są to modele, które są hostowane i sprzedawane przez firmę Microsoft zgodnie z warunkami produktu firmy Microsoft. Te modele zostały poddane rygorystycznej ocenie i są głęboko zintegrowane z ekosystemem sztucznej inteligencji platformy Azure. Modele pochodzą od różnych najlepszych dostawców i oferują rozszerzoną integrację, zoptymalizowaną wydajność i bezpośrednią pomoc techniczną firmy Microsoft, w tym umowy dotyczące poziomu usług klasy korporacyjnej (SLA).

Cechy modeli sprzedawanych bezpośrednio przez platformę Azure:

- Oficjalna pomoc techniczna firmy Microsoft

- Wysoki poziom integracji z usługami i infrastrukturą platformy Azure

- Obszerne testy porównawcze wydajności i walidacja

- Przestrzeganie standardów odpowiedzialnej sztucznej inteligencji firmy Microsoft

- Skalowalność, niezawodność i zabezpieczenia klasy korporacyjnej

Te modele mają również korzyść z aprowizowanej przepływności, co oznacza, że można elastycznie używać limitu przydziału i rezerwacji w ramach dowolnego z tych modeli.

Modele od partnerów i społeczności

Te modele stanowią zdecydowaną większość modeli platformy Azure AI Foundry i są dostarczane przez zaufane organizacje zewnętrzne, partnerów, laboratoria badawcze i uczestników społeczności. Te modele oferują wyspecjalizowane i zróżnicowane możliwości sztucznej inteligencji, obejmujące szeroką gamę scenariuszy, branż i innowacji.

Przykładami modeli od partnerów i społeczności są otwarte modele z centrum Hugging Face. Obejmują one setki modeli z centrum Hugging Face na potrzeby wnioskowania w czasie rzeczywistym za pomocą zarządzanych obliczeń. Hugging Face tworzy i utrzymuje modele wymienione w tej kolekcji. Aby uzyskać pomoc dotyczącą modeli Hugging Face, skorzystaj z forum Hugging Face lub Hugging Face support. Dowiedz się, jak wdrażać modele Hugging Face za pomocą rozwiązania Wdrażanie otwartych modeli za pomocą Azure AI Foundry.

Cechy modeli od partnerów i społeczności:

- Rozwijane i wspierane przez partnerów zewnętrznych oraz uczestników społeczności

- Szeroki zakres wyspecjalizowanych modeli dostosowanych do niszowych lub szerokich przypadków użycia

- Zazwyczaj weryfikowane przez samych dostawców z wytycznymi dotyczącymi integracji udostępnianymi przez platformę Azure

- Innowacje oparte na społeczności i szybka dostępność najnowszych modeli

- Standardowa integracja sztucznej inteligencji platformy Azure z obsługą i konserwacją zarządzaną przez odpowiednich dostawców

Modele od partnerów i społeczności można wdrażać jako opcje wdrażania zarządzanego środowiska obliczeniowego lub bezserwerowego interfejsu API. Dostawca modelu wybiera sposób wdrażania modeli.

Żądanie dołączenia modelu do wykazu modeli

Możesz poprosić o dodanie modelu do wykazu modeli bezpośrednio ze strony wykazu modeli w portalu usługi Azure AI Foundry. Na pasku wyszukiwania strony wykazu modeli wyszukiwanie modelu, który nie istnieje w wykazie, na przykład mymodel, zwraca przycisk Zażądaj modelu . Wybierz ten przycisk, aby otworzyć formularz, w którym możesz udostępnić szczegóły dotyczące żądanego modelu.

Wybieranie między modelami bezpośrednimi a modelami partnerskimi i modelami społeczności

Podczas wybierania modeli z modeli rozwiązania Azure AI Foundry należy wziąć pod uwagę następujące kwestie:

- Przypadki użycia i wymagania: Modele sprzedawane bezpośrednio przez platformę Azure są idealne w scenariuszach wymagających głębokiej integracji platformy Azure, gwarantowanej pomocy technicznej i umów SLA dla przedsiębiorstw. Modele od partnerów i społeczności wyróżniają się w wyspecjalizowanych przypadkach użycia i scenariuszach napędzanych innowacjami.

- Oczekiwania dotyczące pomocy technicznej: Modele sprzedawane bezpośrednio przez platformę Azure są wyposażone w niezawodną pomoc techniczną i konserwację zapewnianą przez firmę Microsoft. Te modele są obsługiwane przez ich dostawców, na różnych poziomach umów SLA i struktur pomocy technicznej.

- Innowacje i specjalizacja: Modele od partnerów i społeczności oferują szybki dostęp do wyspecjalizowanych innowacji i możliwości niszowych często opracowanych przez wiodące laboratoria badawcze i nowych dostawców sztucznej inteligencji.

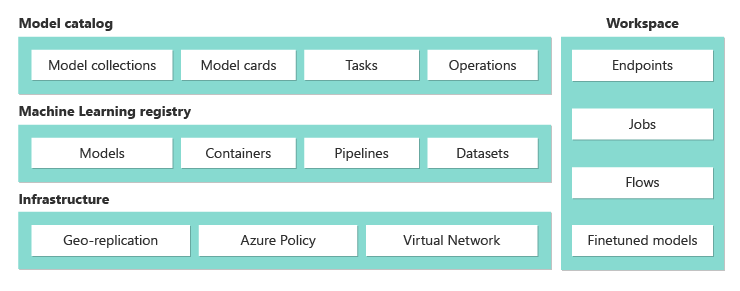

Omówienie możliwości wykazu modeli

Wykaz modeli w portalu usługi Azure AI Foundry to centrum do odnajdywania i używania szerokiej gamy modeli do tworzenia generowanych aplikacji sztucznej inteligencji. Wykaz modeli zawiera setki modeli wśród dostawców modeli, takich jak Azure OpenAI, Mistral, Meta, Cohere, NVIDIA i Hugging Face, w tym modele, które szkoli firma Microsoft. Modele od dostawców innych niż Microsoft są produktami innych niż Microsoft, zgodnie z definicją w warunkach produktów firmy Microsoft i podlegają warunkom dostarczonym z modelami.

Możesz wyszukiwać i odnajdywać modele spełniające twoje potrzeby za pomocą wyszukiwania słów kluczowych i filtrów. Katalog modeli oferuje również ranking wydajności modelu i metryki testu porównawczego dla wybranych modeli. Dostęp do nich można uzyskać, wybierając pozycję Przeglądaj ranking i Porównaj modele. Dane porównawcze są również dostępne na karcie Test porównawczy karty modelu.

W filtrach wykazu modeli znajdziesz następujące informacje:

- Kolekcja: modele można filtrować na podstawie kolekcji dostawcy modelu.

- Branża: można filtrować modele, które są trenowane na podstawie zestawu danych specyficznych dla branży.

- Możliwości: można filtrować unikatowe funkcje modelu, takie jak rozumowanie i wywoływanie narzędzi.

-

Opcje wdrażania: można filtrować modele, które obsługują określone opcje wdrażania.

- bezserwerowy interfejs API: ta opcja umożliwia płacenie za wywołanie interfejsu API.

- Przydzielono zasoby: najlepiej nadaje się do oceniania w czasie rzeczywistym w przypadku dużych, jednolitych woluminów.

- Batch: najlepiej nadaje się do zadań wsadowych zoptymalizowanych pod kątem kosztów, a nie opóźnień. W przypadku wdrożenia wsadowego nie jest zapewniana obsługa placu zabaw.

- Zarządzane obliczenia: ta opcja umożliwia wdrożenie modelu na maszynie wirtualnej platformy Azure. Będą Państwo obciążeni opłatami za hosting i przetwarzanie.

- Zadania wnioskowania: modele można filtrować na podstawie typu zadania wnioskowania.

- Dostrajanie zadań: modele można filtrować na podstawie precyzyjnego dostrajania typu zadania.

- Licencje: modele można filtrować na podstawie typu licencji.

Na karcie modelu znajdziesz:

- Szybkie fakty: na szybki rzut oka zobaczysz kluczowe informacje o modelu.

- Szczegóły: ta strona zawiera szczegółowe informacje o modelu, w tym opis, informacje o wersji, obsługiwany typ danych itp.

- Testy porównawcze: znajdziesz metryki testu porównawczego wydajności dla wybranych modeli.

- Istniejące wdrożenia: jeśli model został już wdrożony, możesz go znaleźć na karcie Istniejące wdrożenia.

- Licencja: znajdziesz informacje prawne dotyczące licencjonowania modelu.

- Artefakty: ta karta będzie wyświetlana tylko dla otwartych modeli. Zasoby modelu można wyświetlić i pobrać za pomocą interfejsu użytkownika.

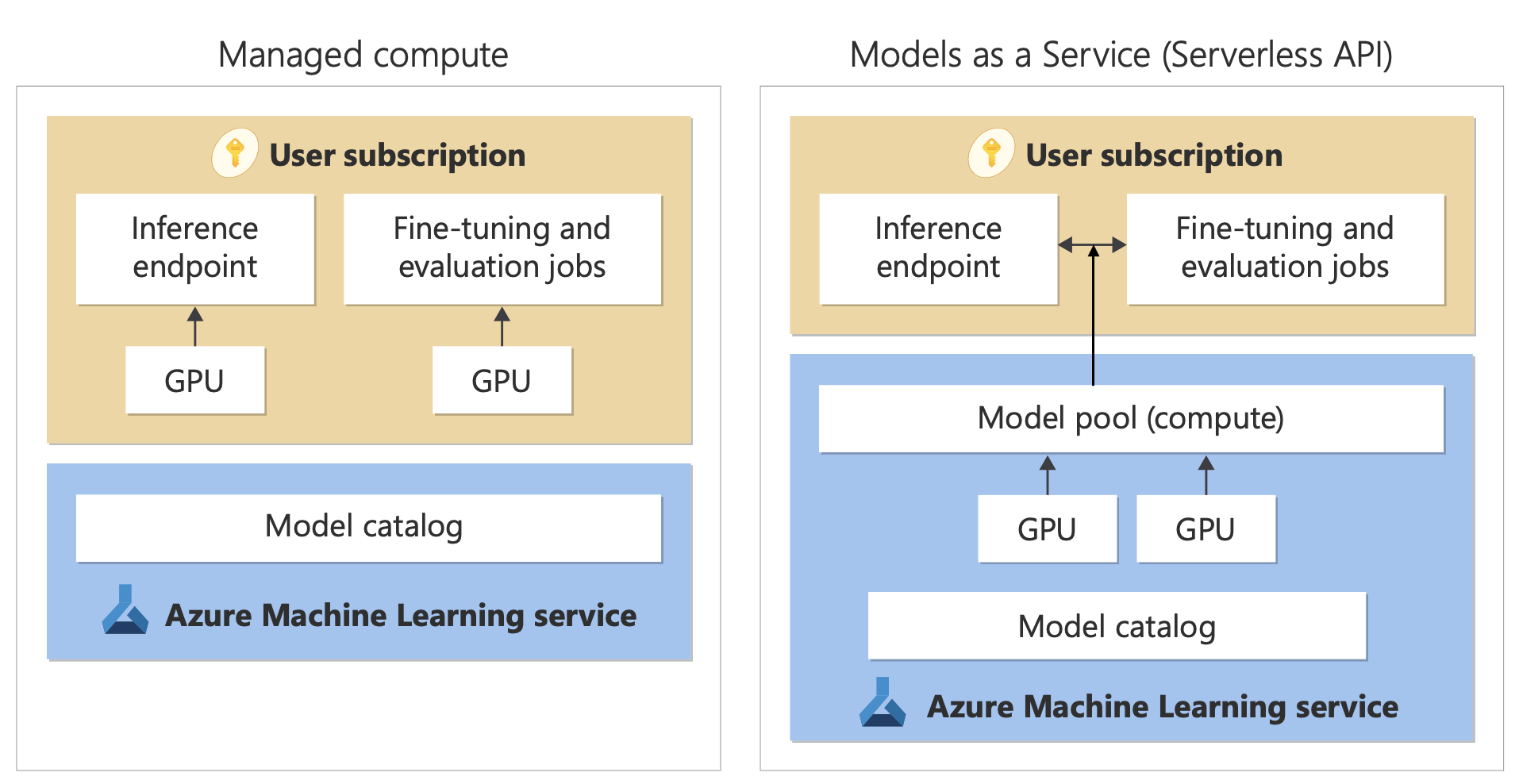

Wdrażanie modelu: zarządzane obliczenia i bezserwerowe wdrożenia API

Oprócz wdrażania w usłudze Azure OpenAI katalog modeli oferuje dwa różne sposoby wdrażania modeli do użycia: zarządzane wdrożenia obliczeniowe i bezserwerowe interfejsy API.

Opcje wdrażania i funkcje dostępne dla każdego modelu różnią się w zależności od opisu w poniższych tabelach. Dowiedz się więcej o przetwarzaniu danych przy użyciu opcji wdrażania.

Możliwości opcji wdrażania modelu

| Funkcje | Zarządzane obliczenia | wdrażanie bezserwerowego interfejsu API |

|---|---|---|

| Doświadczenie wdrażania i fakturowanie | Wagi modelu są wdrażane na dedykowanych maszynach wirtualnych z zarządzanymi obliczeniami. Zarządzane zasoby obliczeniowe, które mogą mieć co najmniej jedno wdrożenie, udostępnia interfejs API REST na potrzeby wnioskowania. Opłaty są naliczane za godziny użytkowania rdzeni maszyn wirtualnych, które są wykorzystywane przez wdrożenia. | Dostęp do modeli odbywa się za pośrednictwem wdrożenia, które udostępnia interfejs API do korzystania z modelu. Interfejs API zapewnia dostęp do modelu hostowanego i zarządzanego przez firmę Microsoft, w celu przeprowadzenia wnioskowania. Opłaty są naliczane za dane wejściowe i wyjściowe w interfejsach API, zazwyczaj w tokenach. Informacje o cenach są udostępniane przed wdrożeniem. |

| Uwierzytelnianie interfejsu API | Klucze i uwierzytelnianie Microsoft Entra. | Tylko klucze. |

| Bezpieczeństwo zawartości | Użyj interfejsów API usługi Azure AI Content Safety Service. | Filtry bezpieczeństwa treści Azure AI są dostępne i zintegrowane z interfejsami API do wnioskowania. Filtry bezpieczeństwa zawartości usługi Azure AI są rozliczane oddzielnie. |

| Izolacja sieci | Konfigurowanie sieci zarządzanych dla centrów usługi Azure AI Foundry. | Zarządzane zasoby obliczeniowe są zgodne z ustawieniem flagi dostępu do sieci publicznej (PNA) centrum. Aby uzyskać więcej informacji, zobacz sekcję Izolacja sieciowa dla modeli wdrożonych za pośrednictwem wdrożeń bezserwerowego interfejsu API w dalszej części tego artykułu. |

Dostępne modele dla obsługiwanych opcji wdrażania

W przypadku modeli usługi Azure OpenAI zobacz Azure OpenAI.

Aby wyświetlić listę obsługiwanych modeli dla wdrożenia bezserwerowego interfejsu API lub zarządzanego środowiska obliczeniowego, przejdź do strony głównej wykazu modeli w usłudze Azure AI Foundry. Użyj filtru Opcje wdrażania , aby wybrać wdrożenie bezserwerowego interfejsu API lub zarządzane obliczenia.

Cykl życia modelu: wycofanie i zakończenie użytkowania

Modele sztucznej inteligencji szybko ewoluują, a gdy nowa wersja lub nowy model ze zaktualizowanymi możliwościami w tej samej rodzinie modeli staną się dostępne, starsze modele mogą zostać wycofane w wykazie modeli rozwiązania AI Foundry. Aby umożliwić bezproblemowe przejście do nowszej wersji modelu, niektóre modele udostępniają użytkownikom opcję włączania aktualizacji automatycznych. Aby dowiedzieć się więcej na temat cyklu życia modelu różnych modeli, nadchodzących dat wycofania modelu i sugerowanych modeli zastępczych i wersji, zobacz:

- Przestarzałość i wycofanie modeli Azure OpenAI

- Deprecacje i wycofanie z użytkowania modelu wdrażania bezserwerowego interfejsu API

Zarządzane obliczenia

Możliwość wdrażania modeli jako zarządzanych obliczeń opiera się na możliwościach platformy usługi Azure Machine Learning, aby umożliwić bezproblemową integrację szerokiej kolekcji modeli w katalogu modeli w całym cyklu życia operacji dużego modelu językowego (LLM).

Dostępność modeli wdrażania jako zarządzanych zasobów obliczeniowych

Modele są udostępniane za pośrednictwem rejestrów usługi Azure Machine Learning. Te rejestry umożliwiają podejście oparte na uczeniu maszynowym do hostowania i rozpowszechniania zasobów usługi Azure Machine Learning. Te zasoby obejmują parametry modeli, runtime'y kontenerów do uruchamiania modeli, pipelines do oceny i dostrajania modeli oraz zbiory danych do testów porównawczych i próbek.

Rejestry bazują na wysoce skalowalnej i gotowej do użycia infrastrukturze, która:

Dostarcza artefakty modelu dostępu o małych opóźnieniach do wszystkich regionów świadczenia usługi Azure z wbudowaną replikacją geograficzną.

Obsługuje wymagania dotyczące zabezpieczeń przedsiębiorstwa, takie jak ograniczanie dostępu do modeli przy użyciu usługi Azure Policy i bezpieczne wdrażanie przy użyciu zarządzanych sieci wirtualnych.

Wdrażanie modeli na potrzeby wnioskowania za pomocą zarządzanych zasobów obliczeniowych

Modele dostępne do wdrożenia do zarządzanych zasobów obliczeniowych można wdrożyć w zarządzanych obliczeniach usługi Azure Machine Learning na potrzeby wnioskowania w czasie rzeczywistym. Wdrożenie na zarządzanej platformie obliczeniowej wymaga posiadania przydziału maszyn wirtualnych w ramach subskrypcji platformy Azure dla określonych produktów, których potrzebujesz, aby optymalnie uruchomić model. Niektóre modele umożliwiają wdrożenie do tymczasowego, wspólnego limitu przydziału do testowania modelu.

Dowiedz się więcej o wdrażaniu modeli:

Tworzenie aplikacji generacyjnych sztucznej inteligencji przy użyciu zarządzanych zasobów obliczeniowych

Funkcja przepływu monitów w usłudze Azure Machine Learning oferuje doskonałe środowisko do tworzenia prototypów. Można używać modeli wdrożonych z zarządzanymi obliczeniami w przepływie zapytań za pomocą narzędzia Open Model LLM. Możesz również użyć interfejsu API REST udostępnianego przez zarządzane zasoby obliczeniowe w popularnych narzędziach LLM, takich jak LangChain z rozszerzeniem Usługi Azure Machine Learning.

Bezpieczeństwo zawartości dla modeli wdrożonych jako zarządzane zasoby obliczeniowe

Usługa Bezpieczeństwa zawartości usługi Azure AI jest dostępna do użycia z zarządzanymi obliczeniami w celu sprawdzania pod kątem różnych kategorii szkodliwych treści, takich jak zawartość seksualna, przemoc, nienawiść i samookaleczenia. Za pomocą usługi można również wyświetlać zaawansowane zagrożenia, takie jak wykrywanie ryzyka zabezpieczeń systemu i wykrywanie tekstu chronionego materiału.

Zapoznaj się z tym notesem, aby zapoznać się z integracją referencyjną z usługą Azure AI Content Safety for Llama 2. Możesz też użyć narzędzia bezpieczeństwa treści (tekstowej) w toku poleceń, aby przekazać odpowiedzi z modelu do analizy przez usługę Azure AI Content Safety. Opłaty są naliczane oddzielnie za takie użycie, zgodnie z opisem w temacie Azure AI Content Safety pricing (Cennik bezpieczeństwa zawartości usługi Azure AI).

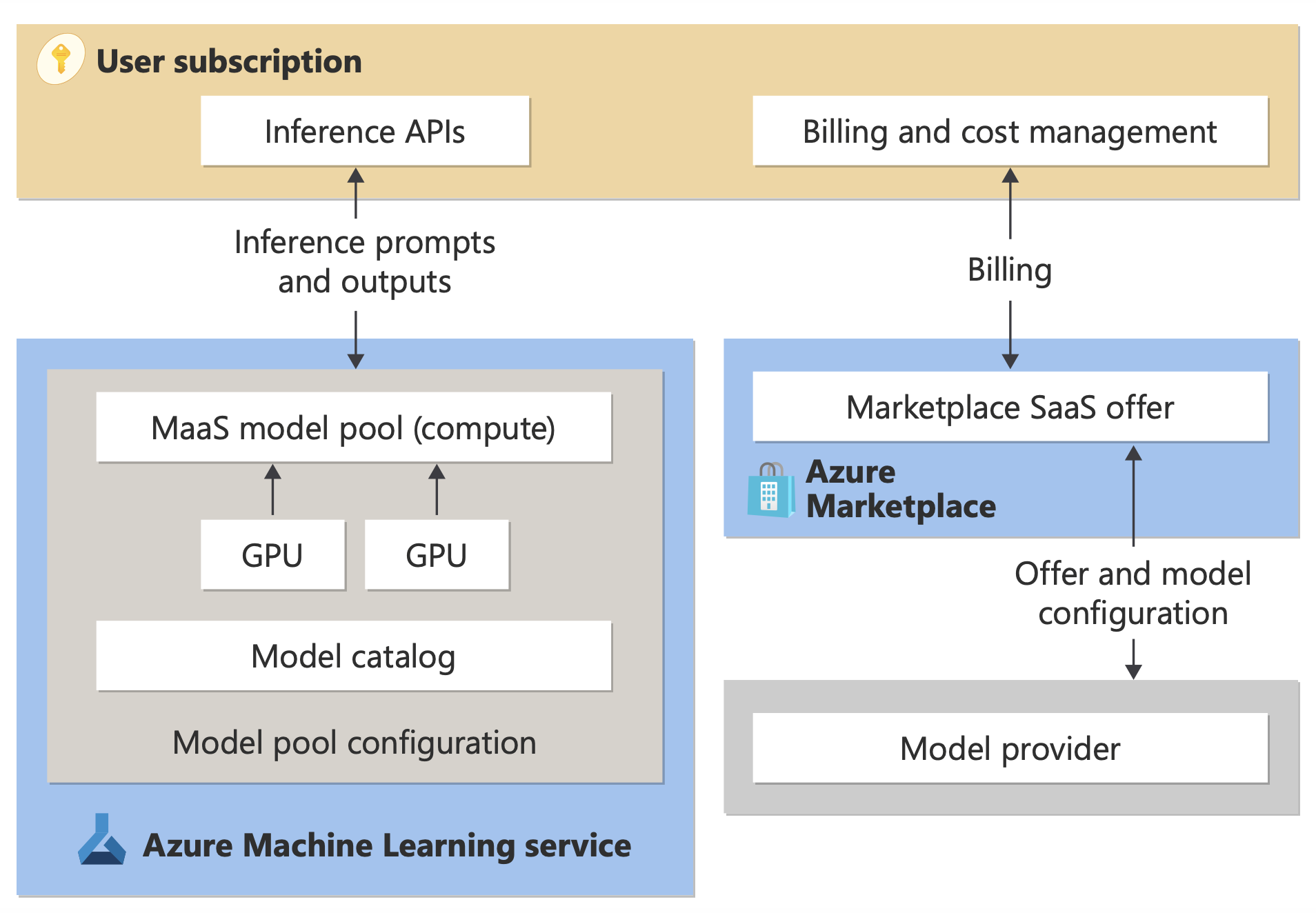

Rozliczenia wdrożenia bezserwerowego interfejsu API

Niektóre modele dostępne w katalogu modeli można wdrożyć z rozliczeniem bezserwerowym API. Ta metoda wdrażania, nazywana również wdrażaniem bezserwerowego interfejsu API, umożliwia korzystanie z modeli jako interfejsów API bez hostowania ich w ramach subskrypcji. Modele są hostowane w infrastrukturze zarządzanej przez firmę Microsoft, która umożliwia dostęp oparty na interfejsie API do modelu dostawcy modelu. Dostęp oparty na interfejsie API może znacznie obniżyć koszt uzyskiwania dostępu do modelu i uprościć środowisko aprowizacji.

Modele dostępne do wdrożenia jako wdrożenia bezserwerowego interfejsu API są oferowane przez dostawcę modelu, ale są hostowane w infrastrukturze platformy Azure zarządzanej przez firmę Microsoft i dostępne za pośrednictwem interfejsu API. Dostawcy modeli definiują postanowienia licencyjne i określają cenę użycia swoich modeli. Usługa Azure Machine Learning:

- Zarządza infrastrukturą hostingu.

- Udostępnia interfejsy API do wnioskowania.

- Działa jako procesor danych dla zapytań przesłanych i danych wyjściowych generowanych przez modele wdrożone za pośrednictwem usługi MaaS.

Dowiedz się więcej o przetwarzaniu danych dla usługi MaaS w artykule dotyczącym prywatności danych.

Uwaga / Notatka

Subskrypcje dostawcy rozwiązań w chmurze (CSP) nie mają możliwości zakupu modeli wdrażania bezserwerowego interfejsu API.

Fakturowanie

Środowisko odnajdywania, subskrypcji i użycia dla modeli wdrożonych za pośrednictwem usługi MaaS znajduje się w witrynie Azure AI Foundry Portal i usłudze Azure Machine Learning Studio. Użytkownicy akceptują postanowienia licencyjne dotyczące używania modeli. Informacje o cenach użycia są udostępniane podczas wdrażania.

Modele od dostawców innych niż Microsoft są rozliczane za pośrednictwem witryny Azure Marketplace zgodnie z warunkami użytkowania witryny Microsoft Commercial Marketplace.

Modele firmy Microsoft są rozliczane poprzez liczniki platformy Azure jako usługi konsumpcyjne First Party. Zgodnie z opisem w Warunki Produktu, kupujesz Pierwsze Usługi Konsumpcyjne przy użyciu mierników Azure, ale nie są objęte warunkami usług platformy Azure. Korzystanie z tych modeli podlega podanym postanowieniom licencyjnym.

Dostrajanie modeli

Niektóre modele obsługują również dostrajanie. W przypadku tych modeli można korzystać z zarządzanych wdrożeń obliczeniowych (wersja zapoznawcza) lub bezserwerowych interfejsów API, aby dostosować modele przy użyciu danych, które udostępniasz. Aby uzyskać więcej informacji, zobacz szczegółowe omówienie dostrajania.

RAG z modelami wdrożonymi jako bezserwerowe wdrożenia API

W portalu Azure AI Foundry można użyć indeksów wektorów i generowania wspartego wyszukiwaniem (RAG). Modele, które można wdrażać za pośrednictwem bezserwerowych wdrożeń interfejsu API, można użyć do generowania osadzania i wnioskowania na podstawie danych niestandardowych. Te osadzanie i wnioskowanie mogą następnie generować odpowiedzi specyficzne dla twojego przypadku użycia. Aby uzyskać więcej informacji, zobacz Tworzenie i używanie indeksów wektorów w portalu usługi Azure AI Foundry.

Regionalna dostępność ofert i modeli

Rozliczanie płatności za token jest dostępne tylko dla użytkowników, których subskrypcja platformy Azure należy do konta rozliczeniowego w kraju/regionie, w którym dostawca modelu udostępnił ofertę. Jeśli oferta jest dostępna w odpowiednim regionie, użytkownik musi mieć zasób projektu w regionie świadczenia usługi Azure, w którym model jest dostępny do wdrożenia lub dostrajania, zgodnie z obowiązującymi przepisami. Zobacz Dostępność regionów dla modeli we wdrożeniach bezserwerowego interfejsu API | Azure AI Foundry, aby uzyskać szczegółowe informacje.

Bezpieczeństwo zawartości dla modeli wdrożonych za pośrednictwem bezserwerowych wdrożeń interfejsu API

W przypadku modeli językowych wdrożonych za pośrednictwem bezserwerowego interfejsu API usługa Azure AI implementuje domyślną konfigurację filtrów moderowania tekstu bezpieczeństwa zawartości usługi Azure AI , które wykrywają szkodliwe treści, takie jak nienawiść, samookaleczenia, treści seksualne i brutalne. Aby dowiedzieć się więcej na temat filtrowania zawartości, zobacz Guardrails and controls for Models Sold Directly by Azure (Zabezpieczenia i kontrolki dla modeli sprzedawanych bezpośrednio przez platformę Azure).

Wskazówka

Filtrowanie zawartości nie jest dostępne dla niektórych typów modeli wdrożonych za pośrednictwem bezserwerowego interfejsu API. Te typy modeli obejmują osadzanie modeli i modeli szeregów czasowych.

Filtrowanie treści odbywa się synchronicznie, gdy usługa przetwarza polecenia w celu wygenerowania treści. Opłaty mogą być naliczane oddzielnie zgodnie z cennikiem bezpieczeństwa zawartości usługi Azure AI dla takiego użycia. Filtrowanie zawartości dla poszczególnych punktów końcowych bezserwerowych można wyłączyć:

- W momencie pierwszego wdrożenia modelu językowego

- Później, wybierając przełącznik filtrowania zawartości na stronie szczegółów wdrożenia

Załóżmy, że postanawiasz użyć interfejsu API innego niż interfejs API wnioskowania modelu do pracy z modelem wdrożonym za pośrednictwem bezserwerowego interfejsu API. W takiej sytuacji filtrowanie zawartości nie jest włączone, chyba że zostanie zaimplementowane oddzielnie przy użyciu bezpieczeństwa zawartości sztucznej inteligencji platformy Azure.

Aby rozpocząć pracę z bezpieczeństwem zawartości usługi Azure AI, zobacz Szybki start: analizowanie zawartości tekstowej. Jeśli nie używasz filtrowania zawartości podczas pracy z modelami wdrożonym za pośrednictwem bezserwerowego interfejsu API, wystąpi większe ryzyko ujawnienia użytkownikom szkodliwej zawartości.

Izolacja sieciowa dla modeli wdrożonych za pomocą interfejsów API w środowisku bezserwerowym

Punkty końcowe modeli wdrożonych jako bezserwerowe interfejsy API są zgodne z ustawieniami flagi dostępu do sieci publicznej huba Azure AI Foundry, który zawiera projekt danego wdrożenia. Aby ułatwić zabezpieczanie wdrożenia bezserwerowego interfejsu API, wyłącz flagę dostępu do sieci publicznej w centrum Azure AI Foundry. Możesz pomóc zabezpieczyć komunikację przychodzącą od klienta do punktu końcowego przy użyciu prywatnego punktu końcowego dla centrum.

Aby ustawić flagę dostępu do sieci publicznej dla centrum usługi Azure AI Foundry:

- Przejdź do portalu Azure.

- Wyszukaj grupę zasobów, do której należy centrum, i wybierz centrum azure AI Foundry z zasobów wymienionych dla tej grupy zasobów.

- Na stronie przeglądu centrum, w okienku po lewej stronie, przejdź do Ustawienia>Sieć.

- Na karcie Dostęp publiczny można skonfigurować ustawienia flagi dostępu do sieci publicznej.

- Zapisz zmiany. Propagacja zmian może potrwać do pięciu minut.

Ograniczenia

Jeśli masz centrum usługi Azure AI Foundry z prywatnym punktem końcowym utworzonym przed 11 lipca 2024 r., wdrożenia bezserwerowego interfejsu API dodane do projektów w tym centrum nie będą zgodne z konfiguracją sieciową centrum. Zamiast tego należy utworzyć nowy prywatny punkt końcowy dla centrum i utworzyć nowe wdrożenie bezserwerowego interfejsu API w projekcie, aby nowe wdrożenia mogły postępować zgodnie z konfiguracją sieci centrum.

Jeśli masz centrum usługi Azure AI Foundry z wdrożeniami usługi MaaS utworzonymi przed 11 lipca 2024 r. i włączysz prywatny punkt końcowy w tym centrum, istniejące wdrożenia bezserwerowego interfejsu API nie będą zgodne z konfiguracją sieciową centrum. Aby wdrożenia bezserwerowego interfejsu API w centrum były zgodne z konfiguracją sieci koncentratora, należy utworzyć je ponownie.

Obecnie obsługa usługi Azure OpenAI w danych nie jest dostępna w przypadku wdrożeń bezserwerowego interfejsu API w prywatnych centrach, ponieważ prywatne centra mają wyłączoną flagę dostępu do sieci publicznej.

Propagowanie dowolnej zmiany konfiguracji sieci (na przykład włączenie lub wyłączenie flagi dostępu do sieci publicznej) może potrwać do pięciu minut.