Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Penting

Lakebase Autoscaling berada di Beta di wilayah berikut: eastus2, , westeuropewestus.

Lakebase Autoscaling adalah versi terbaru Lakebase dengan komputasi penskalaan otomatis, skala-ke-nol, percabangan, dan pemulihan instan. Untuk perbandingan fitur dengan Lakebase Provisioned, lihat memilih antar versi.

Mulai dan operasikan Lakebase Postgres dalam beberapa menit. Buat proyek pertama Anda, sambungkan ke database Anda, dan jelajahi fitur utama termasuk integrasi Unity Catalog.

Membuat proyek pertama Anda

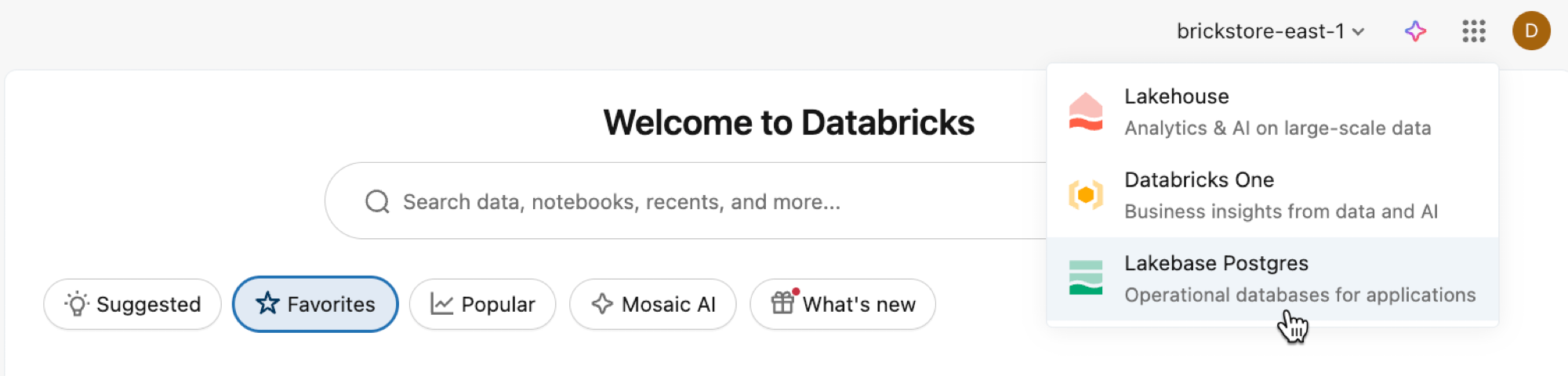

Buka Aplikasi Lakebase dari pengalih aplikasi.

Pilih Autoscaling untuk mengakses UI Lakebase Autoscaling.

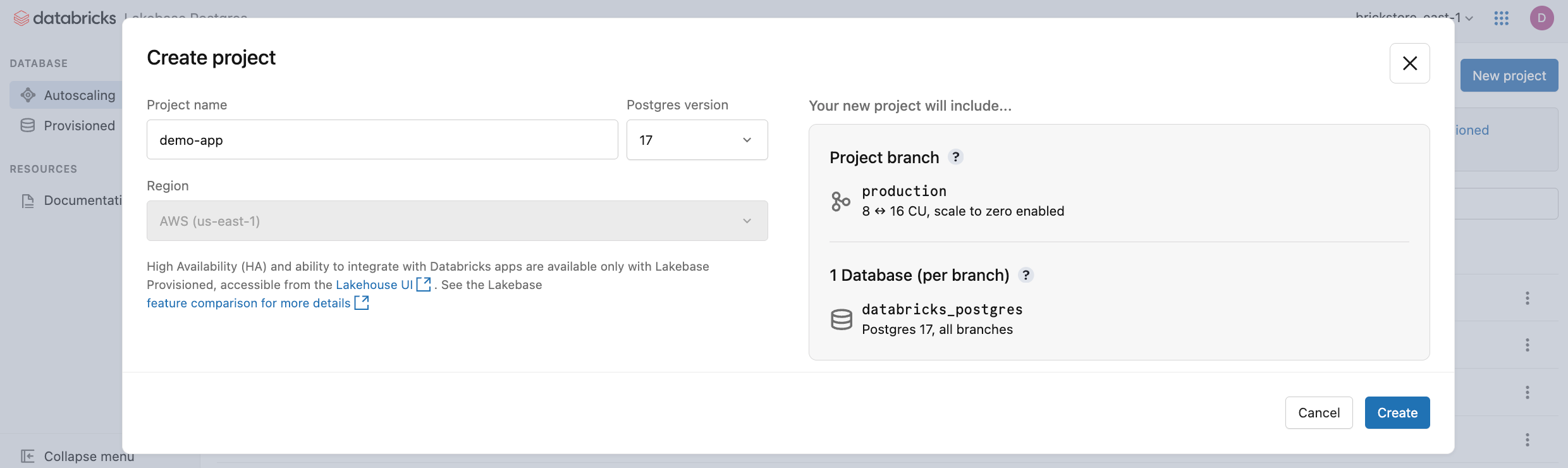

Klik Proyek baru. Beri nama proyek Anda dan pilih versi Postgres Anda. Proyek Anda dibuat dengan satu production cabang, database default databricks_postgres , dan sumber daya komputasi yang dikonfigurasi untuk cabang.

Mungkin perlu beberapa monen agar komputasi Anda diaktifkan. Komputasi untuk production cabang selalu aktif secara default (skala-ke-nol dinonaktifkan), tetapi Anda dapat mengonfigurasi pengaturan ini jika diperlukan.

Wilayah untuk proyek Anda secara otomatis diatur ke wilayah ruang kerja Anda. Untuk opsi konfigurasi terperinci, lihat Membuat proyek.

Menghubungkan ke database Anda

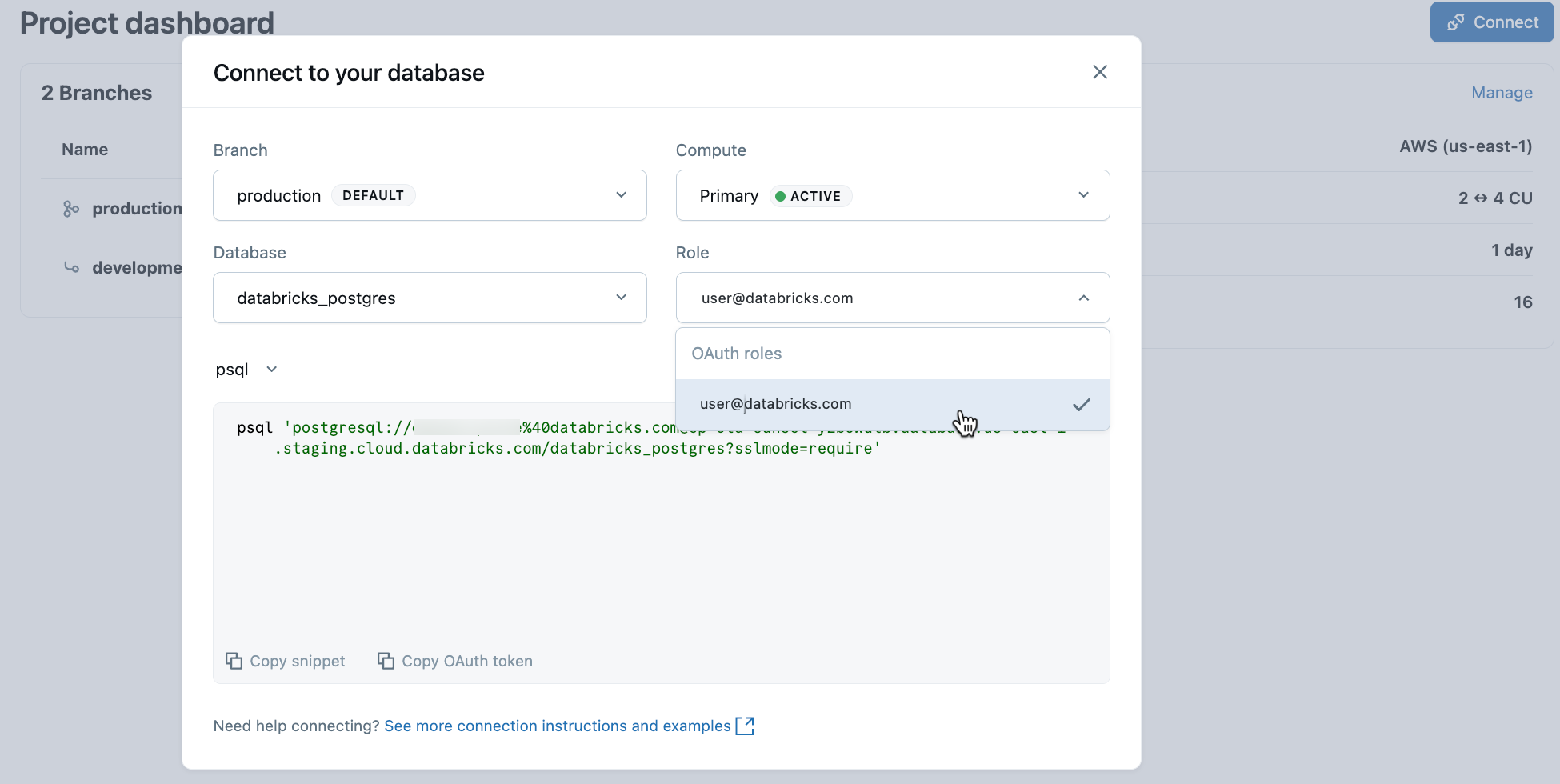

Dari proyek Anda, pilih cabang produksi dan klik Sambungkan. Anda dapat terhubung menggunakan identitas Databricks Anda dengan autentikasi OAuth, atau membuat peran kata sandi Postgres asli. String koneksi berfungsi dengan klien Postgres standar seperti psql, pgAdmin, atau alat yang kompatibel dengan Postgres.

Saat Anda membuat proyek, peran Postgres untuk identitas Databricks Anda (misalnya, user@databricks.com) dibuat secara otomatis. Peran ini memiliki database default databricks_postgres dan merupakan anggota databricks_superuser, memberikan hak istimewa yang luas untuk mengelola objek database.

Untuk menyambungkan menggunakan identitas Databricks Anda dengan OAuth, salin cuplikan psql koneksi dari dialog koneksi.

psql 'postgresql://your-email@databricks.com@ep-abc-123.databricks.com/databricks_postgres?sslmode=require'

Setelah memasukkan psql perintah koneksi di terminal Anda, Anda diminta untuk memberikan token OAuth. Dapatkan token Anda dengan mengklik opsi Salin token OAuth dalam dialog koneksi.

Untuk detail koneksi dan opsi autentikasi, lihat Mulai Cepat.

Buat tabel pertama Anda

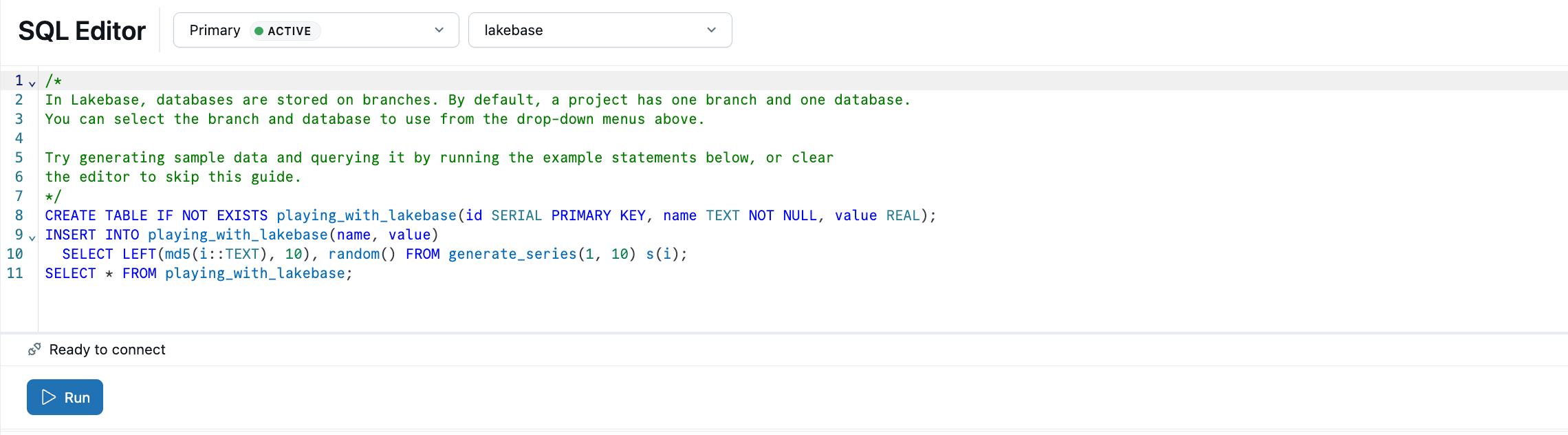

Editor Lakebase SQL dilengkapi dengan sampel SQL untuk membantu Anda memulai. Dari proyek Anda, pilih cabang produksi , buka Editor SQL, dan jalankan pernyataan yang disediakan untuk membuat playing_with_lakebase tabel dan menyisipkan data sampel. Anda juga dapat menggunakan Editor Tabel untuk manajemen data visual atau terhubung dengan klien Postgres eksternal.

Pelajari selengkapnya tentang opsi kueri: Editor SQL | Editor Tabels | Klien Postgres

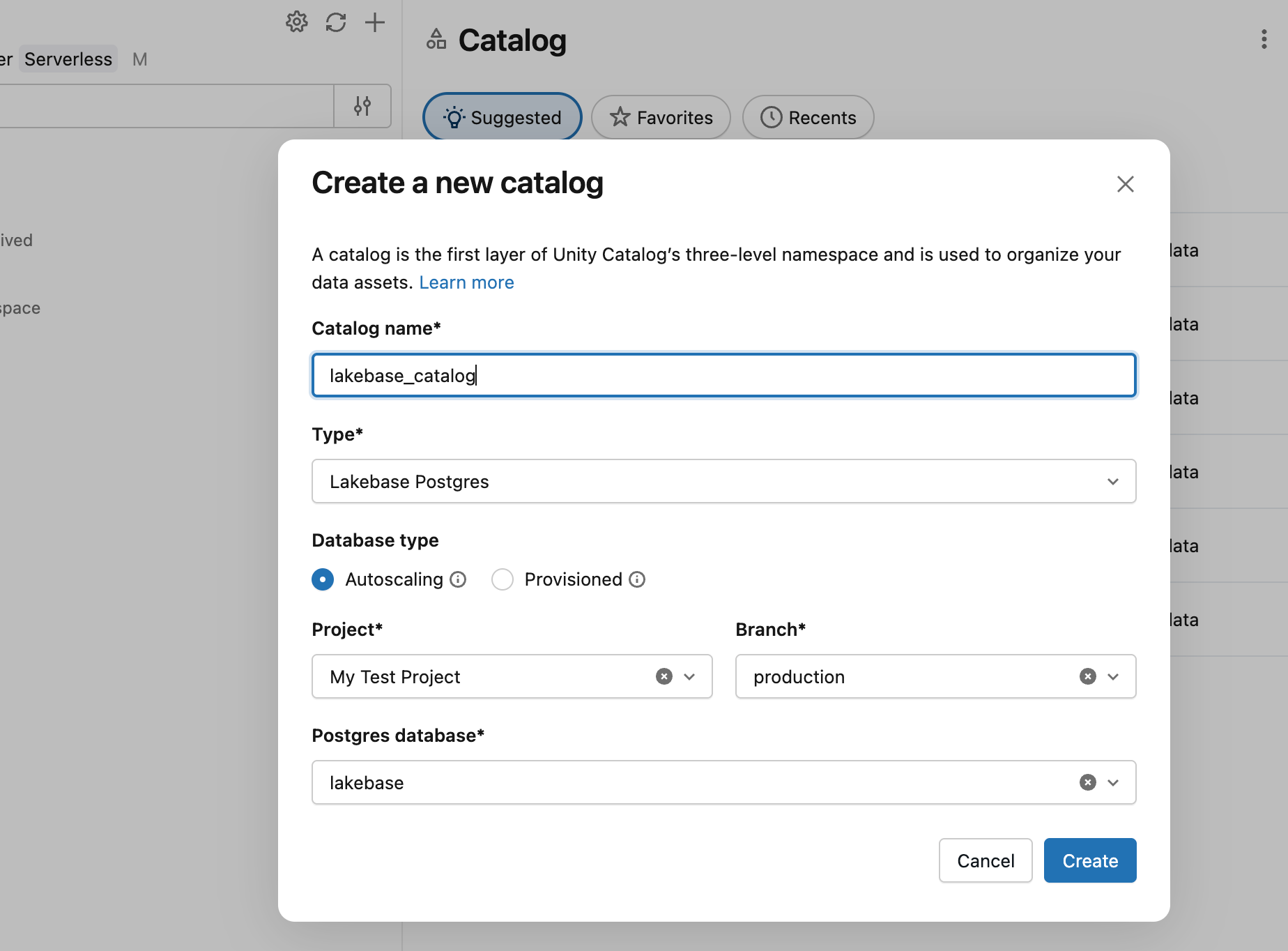

Daftar di Katalog Unity

Sekarang setelah Anda membuat tabel di cabang produksi Anda, mari kita daftarkan database di Unity Catalog sehingga Anda dapat mengkueri data tersebut dari Editor SQL Databricks.

- Gunakan pengalih aplikasi untuk menavigasi ke Lakehouse.

- Di Catalog Explorer, klik ikon plus dan Buat katalog.

- Masukkan nama katalog (misalnya,

lakebase_catalog). - Pilih Lakebase Postgres sebagai jenis katalog dan aktifkan opsi Autoscaling .

- Pilih proyek Anda,

productioncabang, dandatabricks_postgresdatabase. - Klik Buat.

Sekarang Anda dapat mengkueri tabel yang playing_with_lakebase baru saja Anda buat dari Editor SQL Databricks menggunakan gudang SQL:

SELECT * FROM lakebase_catalog.public.playing_with_lakebase;

Ini memungkinkan kueri terfederasi yang menggabungkan data transaksi lakebase Anda dengan analitik lakehouse. Untuk detailnya, lihat Mendaftar di Katalog Unity.

Menyinkronkan data dengan Reverse ETL

Anda baru saja melihat cara membuat data Lakebase dapat dikueri di Unity Catalog. Lakebase juga bekerja ke arah terbalik: membawa data analitik yang dikumpulkan DARI Unity Catalog KE database Lakebase Anda. Ini berguna ketika Anda telah memperkaya data, fitur pembelajaran mesin, atau metrik agregat yang dihitung di lakehouse Anda yang perlu didukung oleh aplikasi dengan kueri transaksi berlatensi rendah.

Pertama, buat tabel di Unity Catalog yang mewakili data analitik. Buka gudang atau notebook SQL dan jalankan:

CREATE TABLE main.default.user_segments AS

SELECT * FROM VALUES

(1001, 'premium', 2500.00, 'high'),

(1002, 'standard', 450.00, 'medium'),

(1003, 'premium', 3200.00, 'high'),

(1004, 'basic', 120.00, 'low')

AS segments(user_id, tier, lifetime_value, engagement);

Sekarang sinkronkan tabel ini ke database Lakebase Anda:

- Di Lakehouse Catalog Explorer, menujuutama>default>user_segments.

- Klik Buat>tabel Yang Disinkronkan.

- Konfigurasikan sinkronisasi:

-

Nama tabel: Masukkan

user_segments_synced. - Jenis database: Pilih Lakebase Serverless (Autoscaling).

- Mode sinkronisasi: Pilih Rekam jepret untuk sinkronisasi data satu kali.

- Pilih proyek Anda, cabang produksi , dan

databricks_postgresdatabase.

-

Nama tabel: Masukkan

- Klik Buat.

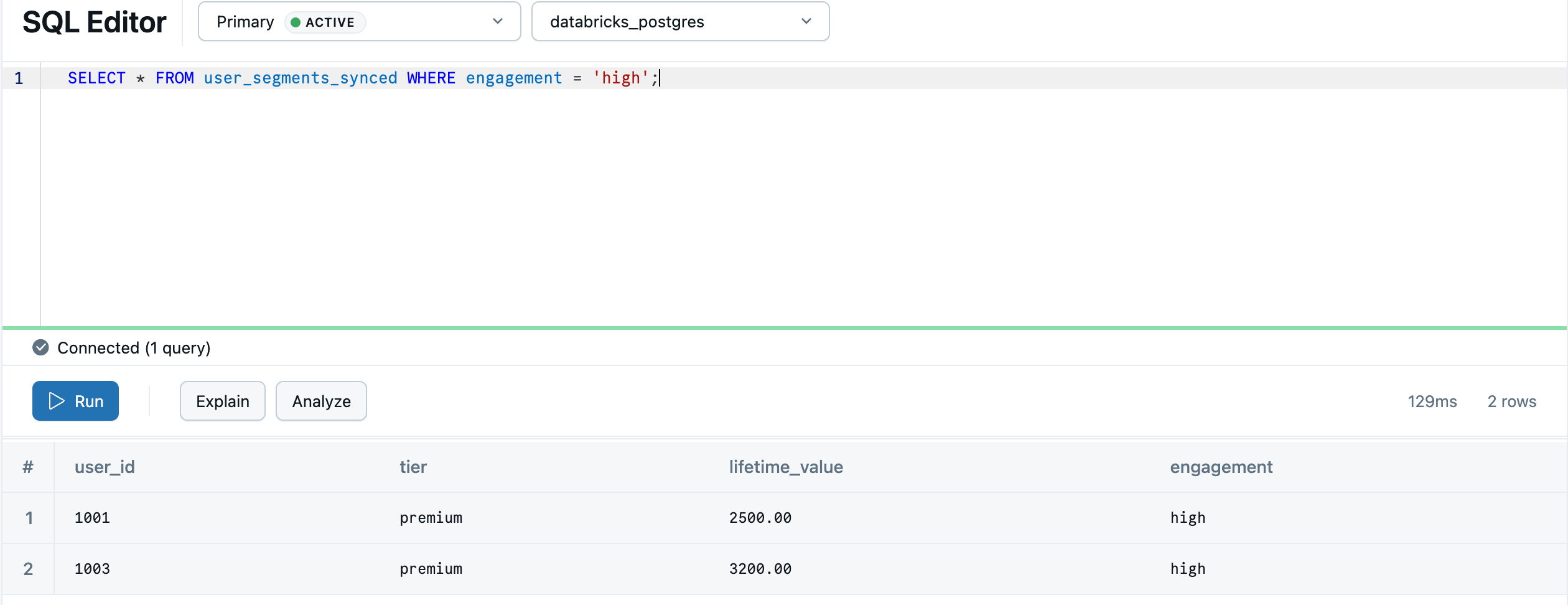

Setelah sinkronisasi selesai, tabel muncul di database Lakebase Anda. Proses sinkronisasi membuat default skema di Postgres agar sesuai dengan skema Katalog Unity, sehingga main.default.user_segments_synced menjadi default.user_segments_synced. Navigasi kembali ke Lakebase menggunakan pengalih aplikasi dan kueri di Editor Lakebase SQL:

SELECT * FROM "default"."user_segments_synced" WHERE "engagement" = 'high';

Analitik lakehouse Anda sekarang tersedia untuk penyajian real time dalam database transaksi anda. Untuk sinkronisasi berkelanjutan, konfigurasi tingkat lanjut, dan pemetaan jenis data, lihat Reverse ETL.