Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Tutorial ini menyajikan skenario end-to-end lengkap dalam pengalaman ilmu data Fabric. Mereka mencakup setiap langkah, dari

- Penyerapan data

- Pembersihan data

- Penyiapan data

ke

- Pelatihan model pembelajaran mesin

- Pembuatan wawasan

lalu mencakup konsumsi wawasan tersebut dengan alat visualisasi - misalnya, Power BI.

Orang yang baru menggunakan Microsoft Fabric harus mengunjungi Apa itu Microsoft Fabric?.

Perkenalan

Siklus hidup proyek ilmu data biasanya mencakup langkah-langkah berikut:

- Memahami aturan bisnis

- Memperoleh data

- Menjelajahi, membersihkan, menyiapkan, dan memvisualisasikan data

- Melatih model dan melacak eksperimen

- Menilai model dan menghasilkan wawasan

Langkah-langkahnya sering dilanjutkan secara berulang. Tujuan dan kriteria keberhasilan setiap tahap bergantung pada kolaborasi, berbagi data, dan dokumentasi. Pengalaman ilmu data Fabric melibatkan beberapa fitur bawaan asli yang memungkinkan kolaborasi, akuisisi data, berbagi, dan konsumsi yang mulus.

Tutorial ini menempatkan Anda dalam peran ilmuwan data yang harus menjelajahi, membersihkan, dan mengubah himpunan data yang berisi status churn 10.000 nasabah bank. Anda kemudian membangun model pembelajaran mesin untuk memprediksi pelanggan bank mana yang kemungkinan akan pergi.

Anda melakukan aktivitas berikut dalam tutorial:

- Menggunakan notebook Fabric untuk skenario ilmu data

- Menggunakan Apache Spark untuk menyerap data ke dalam Fabric lakehouse

- Memuat data yang ada dari tabel delta lakehouse

- Menggunakan alat berbasis Apache Spark dan Python untuk membersihkan dan mengubah data

- Membuat eksperimen dan menjalankan untuk melatih model pembelajaran mesin yang berbeda

- Gunakan MLflow dan UI Fabric untuk mendaftar dan melacak model terlatih

- Jalankan penilaian dalam skala besar, dan simpan prediksi dan hasil inferensi ke lakehouse

- Menggunakan DirectLake untuk memvisualisasikan prediksi di Power BI

Arsitektur

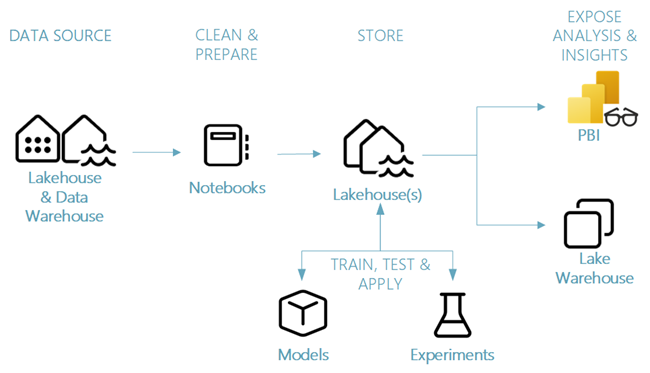

Seri tutorial ini menampilkan skenario ilmu data end-to-end yang disederhanakan yang melibatkan:

- Penyerapan data dari sumber data eksternal.

- Eksplorasi dan pembersihan data.

- Pelatihan dan pendaftaran model pembelajaran mesin.

- Penghitungan nilai secara batch dan penyimpanan prediksi.

- Visualisasi hasil prediksi di Power BI.

Komponen skenario ilmu data yang berbeda

Sumber data - Untuk menyerap data dengan Fabric, Anda dapat dengan mudah dan cepat terhubung ke Azure Data Services, platform cloud lainnya, dan sumber daya data lokal. Dengan Fabric Notebooks, Anda dapat menyerap data dari sumber daya ini:

- Rumah Data Bawaan

- Gudang Data

- Model Semantik

- Berbagai sumber data Apache Spark

- Berbagai sumber data yang mendukung Python

Rangkaian tutorial ini berfokus pada penyerapan dan pemuatan data dari danau data (lakehouse).

Jelajahi, bersihkan, dan siapkan - Pengalaman ilmu data Fabric mendukung pembersihan, transformasi, eksplorasi, dan fiturisasi data. Ini menggunakan pengalaman Spark bawaan dan alat berbasis Python - misalnya, Data Wrangler dan SemPy Library. Tutorial ini menampilkan eksplorasi data dengan seaborn pustaka Python, serta pembersihan dan persiapan data dengan Apache Spark.

Model dan eksperimen - Dengan Fabric, Anda dapat melatih, mengevaluasi, dan menilai model pembelajaran mesin dengan eksperimen bawaan. Untuk mendaftarkan dan menyebarkan model Anda, dan melacak eksperimen, MLflow menawarkan integrasi yang mulus dengan Fabric sebagai cara untuk memodelkan item. Untuk membangun dan berbagi wawasan bisnis, Fabric menawarkan fitur lain untuk prediksi model dalam skala besar (PREDICT), untuk membangun dan berbagi wawasan bisnis.

Penyimpanan - Fabric menstandarkan penggunaan Delta Lake, yang berarti semua mesin Fabric dapat berinteraksi dengan himpunan data yang sama yang disimpan di dalam lakehouse. Dengan lapisan penyimpanan tersebut, Anda dapat menyimpan data terstruktur dan tidak terstruktur yang mendukung penyimpanan berbasis file dan format tabular. Anda dapat dengan mudah mengakses himpunan data dan file yang disimpan melalui semua item pengalaman Fabric - misalnya, notebook dan alur.

Mengekspos analisis dan wawasan - Power BI, alat kecerdasan bisnis terkemuka di industri, dapat menggunakan data lakehouse untuk pembuatan laporan dan visualisasi. Dalam sumber daya notebook, pustaka visualisasi bawaan Python atau Spark

matplotlibseabornplotly- dan lain-lain.

dapat memvisualisasikan data yang tersimpan di lakehouse. Pustaka SemPy juga mendukung visualisasi data. Pustaka ini mendukung visualisasi tugas khusus yang terintegrasi untuk

- Model data semantik

- Dependensi dan pelanggarannya

- Kasus penggunaan klasifikasi dan regresi