Gegevens kopiëren uit Spark met behulp van Azure Data Factory of Synapse Analytics

VAN TOEPASSING OP:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Probeer Data Factory uit in Microsoft Fabric, een alles-in-één analyseoplossing voor ondernemingen. Microsoft Fabric omvat alles, van gegevensverplaatsing tot gegevenswetenschap, realtime analyses, business intelligence en rapportage. Meer informatie over het gratis starten van een nieuwe proefversie .

In dit artikel wordt beschreven hoe u de kopieeractiviteit gebruikt in een Azure Data Factory- of Synapse Analytics-pijplijn om gegevens uit Spark te kopiëren. Het is gebaseerd op het artikel over het overzicht van kopieeractiviteiten met een algemeen overzicht van de kopieeractiviteit.

Ondersteunde mogelijkheden

Deze Spark-connector wordt ondersteund voor de volgende mogelijkheden:

| Ondersteunde mogelijkheden | IR |

|---|---|

| Copy-activiteit (bron/-) | (1) (2) |

| Activiteit Lookup | (1) (2) |

(1) Azure Integration Runtime (2) Zelf-hostende Integration Runtime

Zie de tabel Ondersteunde gegevensarchieven voor een lijst met gegevensarchieven die worden ondersteund als bronnen/sinks door de kopieeractiviteit.

De service biedt een ingebouwd stuurprogramma om connectiviteit in te schakelen, daarom hoeft u geen stuurprogramma handmatig te installeren met behulp van deze connector.

Vereisten

Als uw gegevensarchief zich in een on-premises netwerk, een virtueel Azure-netwerk of een virtuele particuliere cloud van Amazon bevindt, moet u een zelf-hostende Integration Runtime configureren om er verbinding mee te maken.

Als uw gegevensarchief een beheerde cloudgegevensservice is, kunt u De Azure Integration Runtime gebruiken. Als de toegang is beperkt tot IP-adressen die zijn goedgekeurd in de firewallregels, kunt u IP-adressen van Azure Integration Runtime toevoegen aan de acceptatielijst.

U kunt ook de beheerde functie voor integratieruntime voor virtuele netwerken in Azure Data Factory gebruiken om toegang te krijgen tot het on-premises netwerk zonder een zelf-hostende Integration Runtime te installeren en te configureren.

Zie Strategieën voor gegevenstoegang voor meer informatie over de netwerkbeveiligingsmechanismen en -opties die door Data Factory worden ondersteund.

Aan de slag

Als u de kopieeractiviteit wilt uitvoeren met een pijplijn, kunt u een van de volgende hulpprogramma's of SDK's gebruiken:

- Het hulpprogramma voor het kopiëren van gegevens

- Azure Portal

- De .NET-SDK

- De Python-SDK

- Azure PowerShell

- De REST API

- Een Azure Resource Manager-sjabloon

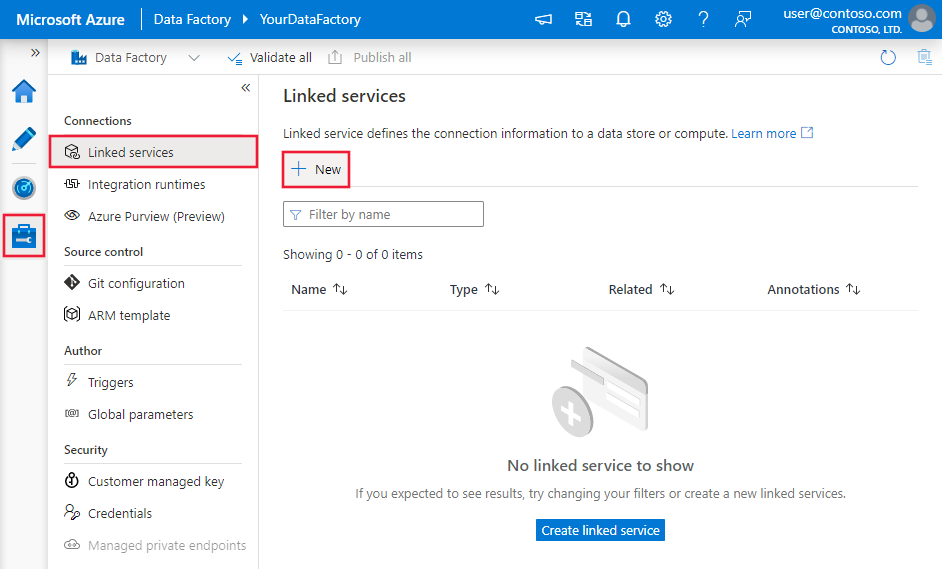

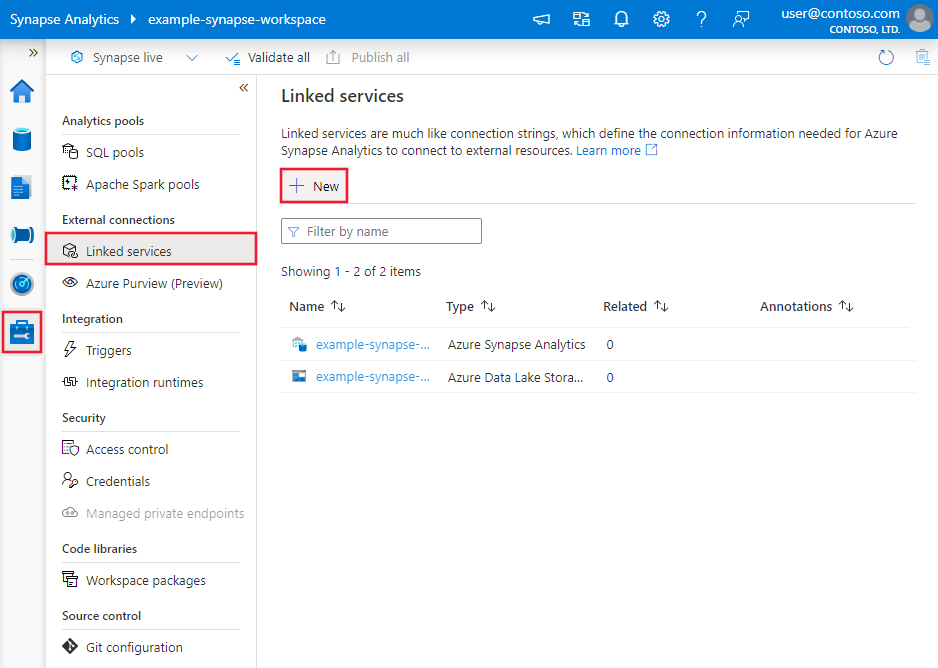

Een gekoppelde service maken voor Spark met behulp van de gebruikersinterface

Gebruik de volgende stappen om een gekoppelde service te maken voor Spark in de gebruikersinterface van Azure Portal.

Blader naar het tabblad Beheren in uw Azure Data Factory- of Synapse-werkruimte en selecteer Gekoppelde services en klik vervolgens op Nieuw:

Zoek naar Spark en selecteer de Spark-connector.

Configureer de servicedetails, test de verbinding en maak de nieuwe gekoppelde service.

Configuratiedetails van connector

De volgende secties bevatten details over eigenschappen die worden gebruikt voor het definiëren van Data Factory-entiteiten die specifiek zijn voor Spark-connector.

Eigenschappen van gekoppelde service

De volgende eigenschappen worden ondersteund voor de gekoppelde Spark-service:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De eigenschap Type moet worden ingesteld op: Spark | Ja |

| host | IP-adres of hostnaam van de Spark-server | Ja |

| poort | De TCP-poort die de Spark-server gebruikt om te luisteren naar clientverbindingen. Als u verbinding maakt met Azure HDInsights, geeft u poort op als 443. | Ja |

| serverType | Het type Spark-server. Toegestane waarden zijn: SharkServer, SharkServer2, SparkThriftServer |

Nee |

| thriftTransportProtocol | Het transportprotocol dat moet worden gebruikt in de Thrift-laag. Toegestane waarden zijn: Binair, SASL, HTTP |

Nee |

| authenticationType | De verificatiemethode die wordt gebruikt voor toegang tot de Spark-server. Toegestane waarden zijn: Anoniem, Gebruikersnaam, UsernameAndPassword, WindowsAzureHDInsightService |

Ja |

| gebruikersnaam | De gebruikersnaam die u gebruikt voor toegang tot Spark Server. | Nee |

| password | Het wachtwoord dat overeenkomt met de gebruiker. Markeer dit veld als SecureString om het veilig op te slaan of verwijs naar een geheim dat is opgeslagen in Azure Key Vault. | Nee |

| httpPath | De gedeeltelijke URL die overeenkomt met de Spark-server. | Nee |

| enableSsl | Hiermee geeft u op of de verbindingen met de server zijn versleuteld met behulp van TLS. De standaardwaarde is false. | Nee |

| trustedCertPath | Het volledige pad van het PEM-bestand met vertrouwde CA-certificaten voor het verifiëren van de server bij het maken van verbinding via TLS. Deze eigenschap kan alleen worden ingesteld wanneer u TLS gebruikt op zelf-hostende IR. De standaardwaarde is het cacerts.pem-bestand dat is geïnstalleerd met de IR. | Nee |

| useSystemTrustStore | Hiermee geeft u op of u een CA-certificaat uit het systeemvertrouwensarchief of een opgegeven PEM-bestand wilt gebruiken. De standaardwaarde is false. | Nee |

| allowHostNameCNMismatch | Hiermee geeft u op of een door een CA uitgegeven TLS/SSL-certificaatnaam moet overeenkomen met de hostnaam van de server bij het maken van verbinding via TLS. De standaardwaarde is false. | Nee |

| allowSelfSignedServerCert | Hiermee geeft u op of zelfondertekende certificaten van de server moeten worden toegestaan. De standaardwaarde is false. | Nee |

| connectVia | De Integration Runtime die moet worden gebruikt om verbinding te maken met het gegevensarchief. Meer informatie vindt u in de sectie Vereisten . Als dit niet is opgegeven, wordt de standaard Azure Integration Runtime gebruikt. | Nee |

Voorbeeld:

{

"name": "SparkLinkedService",

"properties": {

"type": "Spark",

"typeProperties": {

"host" : "<cluster>.azurehdinsight.net",

"port" : "<port>",

"authenticationType" : "WindowsAzureHDInsightService",

"username" : "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

}

}

}

Eigenschappen van gegevensset

Zie het artikel gegevenssets voor een volledige lijst met secties en eigenschappen die beschikbaar zijn voor het definiëren van gegevenssets . Deze sectie bevat een lijst met eigenschappen die worden ondersteund door de Spark-gegevensset.

Als u gegevens uit Spark wilt kopiëren, stelt u de typeeigenschap van de gegevensset in op SparkObject. De volgende eigenschappen worden ondersteund:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap van de gegevensset moet zijn ingesteld op: SparkObject | Ja |

| schema | Naam van het schema. | Nee (als 'query' in de activiteitsbron is opgegeven) |

| table | Naam van de tabel. | Nee (als 'query' in de activiteitsbron is opgegeven) |

| tableName | Naam van de tabel met schema. Deze eigenschap wordt ondersteund voor compatibiliteit met eerdere versies. Gebruik schema en table voor nieuwe workload. |

Nee (als 'query' in de activiteitsbron is opgegeven) |

Voorbeeld

{

"name": "SparkDataset",

"properties": {

"type": "SparkObject",

"typeProperties": {},

"schema": [],

"linkedServiceName": {

"referenceName": "<Spark linked service name>",

"type": "LinkedServiceReference"

}

}

}

Eigenschappen van de kopieeractiviteit

Zie het artikel Pijplijnen voor een volledige lijst met secties en eigenschappen die beschikbaar zijn voor het definiëren van activiteiten. Deze sectie bevat een lijst met eigenschappen die worden ondersteund door spark-bron.

Spark als bron

Als u gegevens uit Spark wilt kopiëren, stelt u het brontype in de kopieeractiviteit in op SparkSource. De volgende eigenschappen worden ondersteund in de sectie bron van kopieeractiviteit:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap van de bron van de kopieeractiviteit moet worden ingesteld op: SparkSource | Ja |

| query | Gebruik de aangepaste SQL-query om gegevens te lezen. Voorbeeld: "SELECT * FROM MyTable". |

Nee (als 'tableName' in de gegevensset is opgegeven) |

Voorbeeld:

"activities":[

{

"name": "CopyFromSpark",

"type": "Copy",

"inputs": [

{

"referenceName": "<Spark input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "SparkSource",

"query": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Eigenschappen van opzoekactiviteit

Als u meer wilt weten over de eigenschappen, controleert u de lookup-activiteit.

Gerelateerde inhoud

Zie ondersteunde gegevensarchieven voor een lijst met gegevensarchieven die worden ondersteund als bronnen en sinks door de kopieeractiviteit.