Wykaz modeli i kolekcje w usłudze Azure AI Studio

Ważne

Niektóre funkcje opisane w tym artykule mogą być dostępne tylko w wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Wykaz modeli w usłudze Azure AI Studio to centrum do odnajdywania i używania szerokiej gamy modeli do tworzenia aplikacji generacyjnych sztucznej inteligencji. Wykaz modeli zawiera setki modeli wśród dostawców modeli, takich jak Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA i Hugging Face, w tym modele, które szkoli firma Microsoft. Modele od dostawców innych niż Microsoft są produktami innych niż Microsoft, zgodnie z definicją w warunkach produktów firmy Microsoft i podlegają warunkom dostarczonym z modelami.

Kolekcje modeli

Wykaz modeli organizuje modele w trzy typy kolekcji:

Wyselekcjonowany przez usługę Azure AI: najbardziej popularne modele inne niż Microsoft open-weight i zastrzeżone, spakowane i zoptymalizowane pod kątem bezproblemowej pracy na platformie Azure AI. Korzystanie z tych modeli podlega postanowieniom licencyjnym dostawców modeli. Podczas wdrażania tych modeli w usłudze Azure AI Studio ich dostępność podlega odpowiedniej umowie dotyczącej poziomu usług platformy Azure (SLA), a firma Microsoft zapewnia pomoc techniczną dotyczącą problemów z wdrażaniem.

Modele od partnerów, takich jak Meta, NVIDIA i Mistral AI, to przykłady modeli dostępnych w tej kolekcji w katalogu. Te modele można zidentyfikować, wyszukując zielony znacznik wyboru na kafelkach modelu w katalogu. Możesz też filtrować według kolekcji Curated by Azure AI (Wyselekcjonowane przez sztuczną inteligencję platformy Azure).

Modele usługi Azure OpenAI dostępne wyłącznie na platformie Azure: flagowe modele usługi Azure OpenAI dostępne za pośrednictwem integracji z usługą Azure OpenAI Service. Firma Microsoft obsługuje te modele i ich użycie zgodnie z warunkami produktu i umową SLA dla usługi Azure OpenAI Service.

Otwieranie modeli z centrum Hugging Face: setki modeli z centrum Hugging Face hub na potrzeby wnioskowania w czasie rzeczywistym za pomocą zarządzanych obliczeń. Przytulanie twarzy tworzy i utrzymuje modele wymienione w tej kolekcji. Aby uzyskać pomoc, skorzystaj z forum Hugging Face lub obsługa przytulania twarzy. Dowiedz się więcej w artykule Deploy open models with Azure AI Studio (Wdrażanie otwartych modeli za pomocą programu Azure AI Studio).

Możesz przesłać żądanie dodania modelu do katalogu modeli przy użyciu tego formularza.

Omówienie możliwości wykazu modeli

Niektóre modele można wdrożyć w modelach nadzorowanych przez usługę Azure AI i Open z kolekcji hugging Face Hub za pomocą opcji zarządzanego środowiska obliczeniowego. Niektóre modele są dostępne do wdrożenia za pośrednictwem bezserwerowych interfejsów API z rozliczeniami płatności zgodnie z rzeczywistym użyciem.

Możesz odnajdywać, porównywać, oceniać, dostosowywać (jeśli są obsługiwane) i wdrażać te modele na dużą skalę. Następnie możesz zintegrować modele z wygenerowanymi aplikacjami sztucznej inteligencji z zabezpieczeniami i ładem danych klasy korporacyjnej. Poniższa lista zawiera szczegółowe opisy działań:

- Odnajdywanie: Przejrzyj karty modelu, wypróbuj przykładowe wnioskowanie i przejrzyj przykłady kodu, aby ocenić, dostosować lub wdrożyć model.

- Porównaj: Porównaj testy porównawcze między modelami i zestawami danych dostępnymi w branży, aby ocenić, który z nich spełnia Twój scenariusz biznesowy.

- Oceń: oceń, czy model jest odpowiedni dla konkretnego obciążenia, podając własne dane testowe. Użyj metryk oceny, aby zwizualizować, jak dobrze działa wybrany model w danym scenariuszu.

- Dostrajanie: Dostosuj modele z możliwością dostosowania przy użyciu własnych danych treningowych i wybierz najlepszy model, porównując metryki we wszystkich zadaniach dostrajania. Wbudowane optymalizacje przyspieszają dostrajanie i zmniejszanie wymaganej pamięci i mocy obliczeniowej.

- Wdrażanie: bezproblemowe wdrażanie wstępnie wytrenowanych modeli lub dostosowanych modeli w celu wnioskowania. Można również pobrać modele, które można wdrożyć w zarządzanych obliczeniach.

Aby uzyskać więcej informacji na temat modeli usługi Azure OpenAI, zobacz Co to jest usługa Azure OpenAI Service?.

Wdrażanie modelu: zarządzany interfejs API obliczeniowy i bezserwerowy (płatność zgodnie z rzeczywistym użyciem)

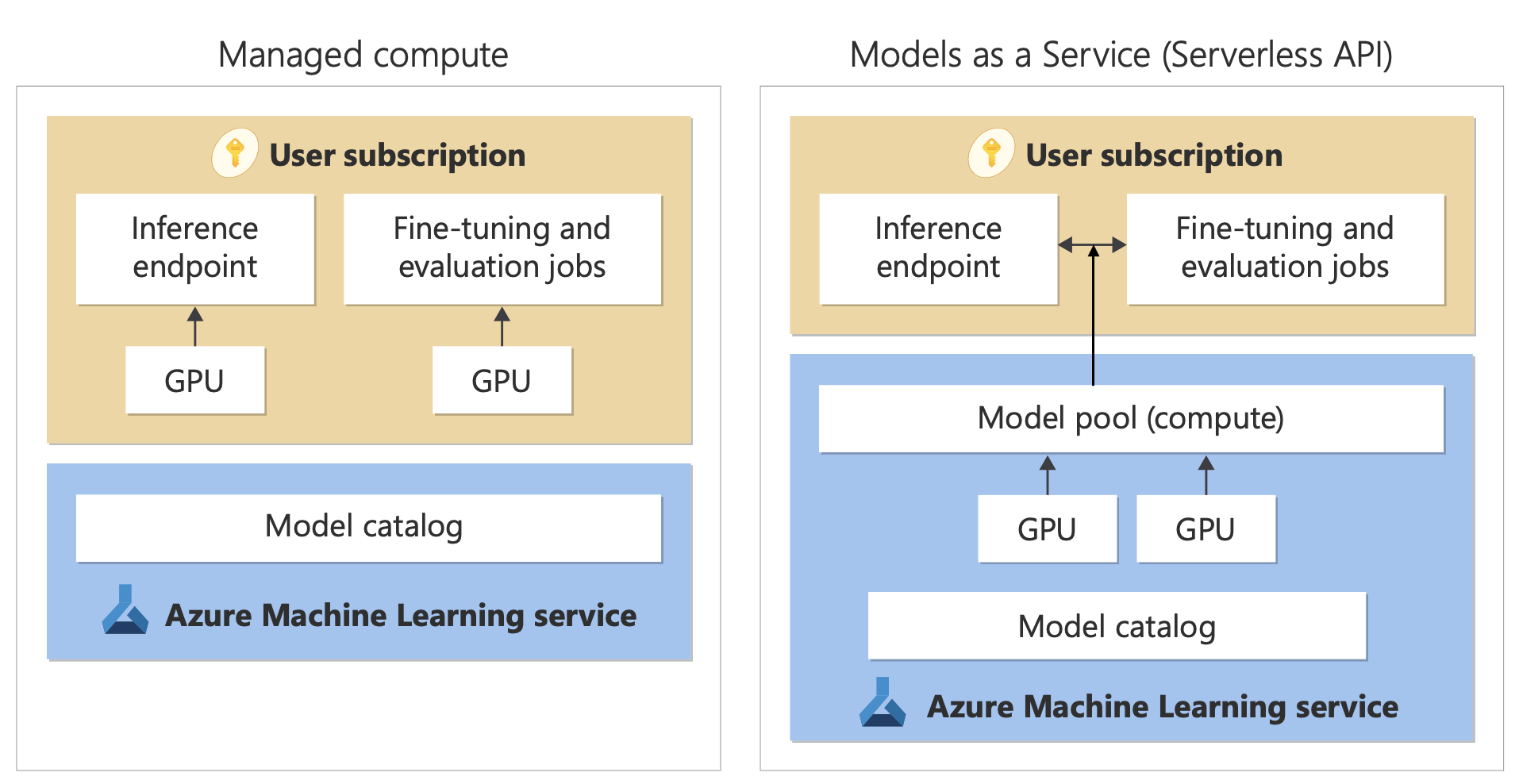

Katalog modeli oferuje dwa różne sposoby wdrażania modeli do użycia: zarządzane zasoby obliczeniowe i bezserwerowe interfejsy API.

Opcje wdrażania i funkcje dostępne dla każdego modelu różnią się w zależności od opisu w poniższych tabelach. Dowiedz się więcej o przetwarzaniu danych przy użyciu opcji wdrażania.

| Funkcje | Zarządzane obliczenia | Bezserwerowy interfejs API (płatność zgodnie z rzeczywistym użyciem) |

|---|---|---|

| Środowisko wdrażania i rozliczenia | Wagi modelu są wdrażane na dedykowanych maszynach wirtualnych z zarządzanymi obliczeniami. Zarządzane zasoby obliczeniowe, które mogą mieć co najmniej jedno wdrożenie, udostępnia interfejs API REST na potrzeby wnioskowania. Opłaty są naliczane za godziny rdzenia maszyny wirtualnej używane przez wdrożenia. | Dostęp do modeli odbywa się za pośrednictwem wdrożenia, które aprowizuje interfejs API w celu uzyskania dostępu do modelu. Interfejs API zapewnia dostęp do modelu hostowanego przez firmę Microsoft i zarządzania nim w celu wnioskowania. Opłaty są naliczane za dane wejściowe i wyjściowe w interfejsach API, zazwyczaj w tokenach. Informacje o cenach są udostępniane przed wdrożeniem. |

| Uwierzytelnianie interfejsu API | Klucze i uwierzytelnianie firmy Microsoft Entra. | Tylko klucze. |

| Bezpieczeństwo zawartości | Użyj interfejsów API usługi Azure AI Content Safety Service. | Filtry bezpieczeństwa zawartości platformy Azure AI są dostępne zintegrowane z interfejsami API wnioskowania. Filtry bezpieczeństwa zawartości usługi Azure AI są rozliczane oddzielnie. |

| Izolacja sieciowa | Konfigurowanie sieci zarządzanych dla centrów usługi Azure AI Studio. | Zarządzane zasoby obliczeniowe są zgodne z ustawieniem flagi dostępu do sieci publicznej (PNA) centrum. Aby uzyskać więcej informacji, zobacz sekcję Izolacja sieciowa dla modeli wdrożonych za pośrednictwem bezserwerowych interfejsów API w dalszej części tego artykułu. |

| Model | Zarządzane obliczenia | Bezserwerowy interfejs API (płatność zgodnie z rzeczywistym użyciem) |

|---|---|---|

| Modele rodziny Llama | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Poinstruowanie Llama-3-70B-Poinstruowanie Llama-3-8B Llama-3-70B |

Llama-3-70B-Poinstruowanie Llama-3-8B-Poinstruowanie Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Modele rodziny Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Mistral-NeMo |

| Modele rodziny cohere | Niedostępny | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-wielojęzyczny Cohere-rerank-v3-english Cohere-rerank-v3-wielojęzyczny |

| JAIS | Niedostępny | jais-30b-chat |

| Modele rodziny Phi-3 | Phi-3-mini-4k-Poinstruowanie Phi-3-mini-128k-Poinstruowanie Phi-3-small-8k-Poinstruuj Phi-3-small-128k-Poinstruuj Phi-3-medium-4k-poinstruowanie Phi-3-medium-128k-poinstruowanie Phi-3-vision-128k-Poinstruowanie Phi-3.5-mini-Poinstruowanie Phi-3.5-vision-Poinstruowanie Phi-3.5-Moe-Poinstruowanie |

Phi-3-mini-4k-Poinstruowanie Phi-3-mini-128k-Poinstruowanie Phi-3-small-8k-Poinstruuj Phi-3-small-128k-Poinstruuj Phi-3-medium-4k-poinstruowanie Phi-3-medium-128k-poinstruowanie Phi-3.5-mini-Poinstruowanie Phi-3.5-vision-Poinstruowanie Phi-3.5-Moe-Poinstruowanie |

| Nixtla | Niedostępny | TimeGEN-1 |

| Inne modele | Dostępna | Niedostępny |

Zarządzane obliczenia

Możliwość wdrażania modeli jako zarządzanych obliczeń opiera się na możliwościach platformy usługi Azure Machine Learning, aby umożliwić bezproblemową integrację szerokiej kolekcji modeli w katalogu modeli w całym cyklu życia operacji dużego modelu językowego (LLM).

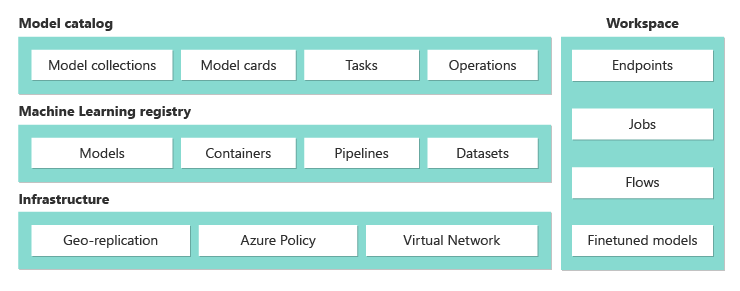

Dostępność modeli wdrażania jako zarządzanych zasobów obliczeniowych

Modele są udostępniane za pośrednictwem rejestrów usługi Azure Machine Learning. Te rejestry umożliwiają podejście oparte na uczeniu maszynowym do hostowania i rozpowszechniania zasobów usługi Azure Machine Learning. Te zasoby obejmują wagi modeli, środowiska uruchomieniowe kontenerów do uruchamiania modeli, potoki do oceny i dostrajania modeli oraz zestawów danych dla testów porównawczych i przykładów.

Rejestry bazują na wysoce skalowalnej i gotowej do użycia infrastrukturze, która:

Dostarcza artefakty modelu dostępu o małych opóźnieniach do wszystkich regionów świadczenia usługi Azure z wbudowaną replikacją geograficzną.

Obsługuje wymagania dotyczące zabezpieczeń przedsiębiorstwa, takie jak ograniczanie dostępu do modeli przy użyciu usługi Azure Policy i bezpieczne wdrażanie przy użyciu zarządzanych sieci wirtualnych.

Wdrażanie modeli na potrzeby wnioskowania za pomocą zarządzanych zasobów obliczeniowych

Modele dostępne do wdrożenia do zarządzanych zasobów obliczeniowych można wdrożyć w zarządzanych obliczeniach usługi Azure Machine Learning na potrzeby wnioskowania w czasie rzeczywistym. Wdrożenie w zarządzanych obliczeniach wymaga uzyskania limitu przydziału maszyn wirtualnych w ramach subskrypcji platformy Azure dla określonych produktów, które należy optymalnie uruchomić model. Niektóre modele umożliwiają wdrożenie tymczasowego udostępnionego limitu przydziału na potrzeby testowania modelu.

Dowiedz się więcej o wdrażaniu modeli:

Tworzenie aplikacji generacyjnych sztucznej inteligencji przy użyciu zarządzanych zasobów obliczeniowych

Funkcja przepływu monitów w usłudze Azure Machine Learning oferuje doskonałe środowisko do tworzenia prototypów. Modele wdrożone z zarządzanymi obliczeniami można używać w przepływie monitów za pomocą narzędzia Open Model LLM. Możesz również użyć interfejsu API REST udostępnianego przez zarządzane zasoby obliczeniowe w popularnych narzędziach LLM, takich jak LangChain z rozszerzeniem Usługi Azure Machine Learning.

Bezpieczeństwo zawartości dla modeli wdrożonych jako zarządzane zasoby obliczeniowe

Usługa Bezpieczeństwa zawartości usługi Azure AI jest dostępna do użycia z zarządzanymi obliczeniami w celu sprawdzania pod kątem różnych kategorii szkodliwych treści, takich jak zawartość seksualna, przemoc, nienawiść i samookaleczenia. Za pomocą usługi można również wyświetlać zaawansowane zagrożenia, takie jak wykrywanie ryzyka zabezpieczeń systemu i wykrywanie tekstu chronionego materiału.

Zapoznaj się z tym notesem, aby zapoznać się z integracją referencyjną z usługą Azure AI Content Safety for Llama 2. Możesz też użyć narzędzia Bezpieczeństwo zawartości (tekst) w przepływie monitu, aby przekazać odpowiedzi z modelu do bezpieczeństwa zawartości usługi Azure AI na potrzeby kontroli zawartości. Opłaty są naliczane oddzielnie za takie użycie, zgodnie z opisem w temacie Azure AI Content Safety pricing (Cennik bezpieczeństwa zawartości usługi Azure AI).

Bezserwerowe interfejsy API z rozliczeniami płatności zgodnie z rzeczywistym użyciem

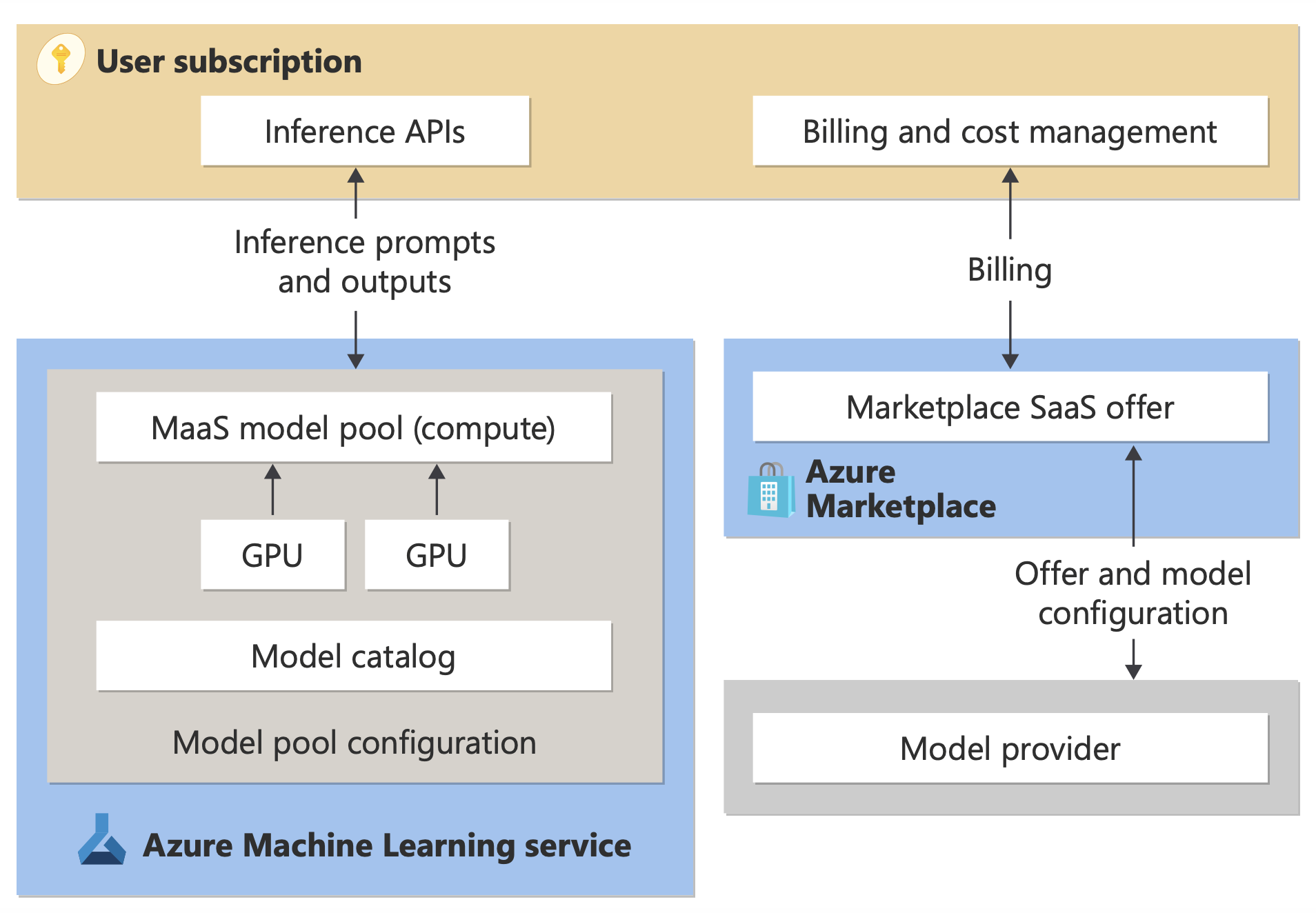

Niektóre modele można wdrożyć w wykazie modeli jako bezserwerowe interfejsy API z rozliczeniami płatności zgodnie z rzeczywistym użyciem. Ta metoda wdrażania, czasami nazywana modelem jako usługą (MaaS), umożliwia korzystanie z modeli jako interfejsów API bez hostowania ich w ramach subskrypcji. Modele są hostowane w infrastrukturze zarządzanej przez firmę Microsoft, która umożliwia dostęp oparty na interfejsie API do modelu dostawcy modelu. Dostęp oparty na interfejsie API może znacznie obniżyć koszt uzyskiwania dostępu do modelu i uprościć środowisko aprowizacji.

Modele, które są dostępne do wdrożenia jako bezserwerowe interfejsy API z rozliczeniami płatności zgodnie z rzeczywistym użyciem, są oferowane przez dostawcę modelu, ale są hostowane w infrastrukturze platformy Azure zarządzanej przez firmę Microsoft i dostępne za pośrednictwem interfejsu API. Dostawcy modeli definiują postanowienia licencyjne i określają cenę użycia swoich modeli. Usługa Azure Machine Learning:

- Zarządza infrastrukturą hostingu.

- Udostępnia interfejsy API wnioskowania.

- Działa jako procesor danych dla monitów przesłanych i danych wyjściowych zawartości przez modele wdrożone za pośrednictwem usługi MaaS.

Dowiedz się więcej o przetwarzaniu danych dla usługi MaaS w artykule dotyczącym prywatności danych.

Rozliczenia

Środowisko odnajdywania, subskrypcji i użycia modeli wdrożonych za pośrednictwem usługi MaaS jest dostępne w usłudze Azure AI Studio i usłudze Azure Machine Learning Studio. Użytkownicy akceptują postanowienia licencyjne dotyczące używania modeli. Informacje o cenach użycia są udostępniane podczas wdrażania.

Modele od dostawców innych niż Microsoft są rozliczane za pośrednictwem witryny Azure Marketplace zgodnie z warunkami użytkowania witryny Microsoft Commercial Marketplace.

Modele firmy Microsoft są rozliczane za pośrednictwem mierników platformy Azure jako usług zużycie przez firmę First Party. Zgodnie z opisem w warunkach produktu kupujesz usługi Zużycie pierwszej firmy przy użyciu mierników platformy Azure, ale nie podlegają warunkom świadczenia usług platformy Azure. Korzystanie z tych modeli podlega podanym postanowieniom licencyjnym.

Dostrajanie modeli

Niektóre modele obsługują również bezserwerowe dostrajanie. W przypadku tych modeli możesz skorzystać z hostowanego dostrajania z rozliczeniami płatności zgodnie z rzeczywistym użyciem, aby dostosować modele przy użyciu udostępnianych danych. Aby uzyskać więcej informacji, zobacz szczegółowe omówienie dostrajania.

Rag z modelami wdrożonym jako bezserwerowe interfejsy API

W usłudze Azure AI Studio można używać indeksów wektorów i generowania rozszerzonego pobierania (RAG). Modele, które można wdrażać za pośrednictwem bezserwerowych interfejsów API, można użyć do generowania osadzania i wnioskowania na podstawie danych niestandardowych. Te osadzanie i wnioskowanie mogą następnie generować odpowiedzi specyficzne dla twojego przypadku użycia. Aby uzyskać więcej informacji, zobacz Tworzenie i używanie indeksów wektorów w usłudze Azure AI Studio.

Regionalna dostępność ofert i modeli

Rozliczanie zgodnie z rzeczywistym użyciem jest dostępne tylko dla użytkowników, których subskrypcja platformy Azure należy do konta rozliczeniowego w kraju, w którym dostawca modelu udostępnił ofertę. Jeśli oferta jest dostępna w odpowiednim regionie, użytkownik musi mieć centrum/projekt w regionie świadczenia usługi Azure, w którym model jest dostępny do wdrożenia lub dostrajania, zgodnie z obowiązującymi przepisami. Zobacz Dostępność regionów dla modeli w punktach końcowych bezserwerowego interfejsu API | Program Azure AI Studio zawiera szczegółowe informacje.

Bezpieczeństwo zawartości dla modeli wdrożonych za pośrednictwem bezserwerowych interfejsów API

W przypadku modeli językowych wdrożonych za pośrednictwem bezserwerowych interfejsów API usługa Azure AI implementuje domyślną konfigurację filtrów moderowania tekstu bezpieczeństwa zawartości usługi Azure AI, które wykrywają szkodliwe treści, takie jak nienawiść, samookaleczenia, treści seksualne i brutalne. Aby dowiedzieć się więcej na temat filtrowania zawartości (wersja zapoznawcza), zobacz Kategorie szkód w obszarze Bezpieczeństwo zawartości sztucznej inteligencji platformy Azure.

Napiwek

Filtrowanie zawartości (wersja zapoznawcza) nie jest dostępne dla niektórych typów modeli wdrożonych za pośrednictwem bezserwerowych interfejsów API. Te typy modeli obejmują osadzanie modeli i modeli szeregów czasowych.

Filtrowanie zawartości (wersja zapoznawcza) odbywa się synchronicznie, ponieważ procesy usługi monituje o wygenerowanie zawartości. Opłaty mogą być naliczane oddzielnie zgodnie z cennikiem bezpieczeństwa zawartości usługi Azure AI dla takiego użycia. Możesz wyłączyć filtrowanie zawartości (wersja zapoznawcza) dla pojedynczych punktów końcowych bezserwerowych:

- W momencie pierwszego wdrożenia modelu językowego

- Później, wybierając przełącznik filtrowania zawartości na stronie szczegółów wdrożenia

Załóżmy, że postanawiasz użyć interfejsu API innego niż interfejs API wnioskowania modelu AI platformy Azure do pracy z modelem wdrożonym za pośrednictwem bezserwerowego interfejsu API. W takiej sytuacji filtrowanie zawartości (wersja zapoznawcza) nie jest włączone, chyba że zaimplementowano je oddzielnie przy użyciu bezpieczeństwa zawartości usługi Azure AI.

Aby rozpocząć pracę z bezpieczeństwem zawartości usługi Azure AI, zobacz Szybki start: analizowanie zawartości tekstowej. Jeśli nie używasz filtrowania zawartości (wersja zapoznawcza) podczas pracy z modelami wdrożonym za pośrednictwem bezserwerowych interfejsów API, wystąpi większe ryzyko ujawnienia użytkownikom szkodliwej zawartości.

Izolacja sieciowa dla modeli wdrożonych za pośrednictwem bezserwerowych interfejsów API

Zarządzane obliczenia dla modeli wdrożonych jako bezserwerowe interfejsy API są zgodne z ustawieniem flagi dostępu do sieci publicznej centrum AI Studio, w którym istnieje projekt, w którym istnieje wdrożenie. Aby ułatwić zabezpieczanie zarządzanych zasobów obliczeniowych, wyłącz flagę dostępu do sieci publicznej w centrum AI Studio. Możesz pomóc zabezpieczyć komunikację przychodzącą od klienta do zarządzanych zasobów obliczeniowych przy użyciu prywatnego punktu końcowego dla centrum.

Aby ustawić flagę dostępu do sieci publicznej dla centrum AI Studio:

- Przejdź do portalu Azure Portal.

- Wyszukaj grupę zasobów, do której należy centrum, i wybierz centrum AI Studio z zasobów wymienionych dla tej grupy zasobów.

- Na stronie przeglądu centrum w okienku po lewej stronie przejdź do pozycji Ustawienia>Sieć.

- Na karcie Dostęp publiczny można skonfigurować ustawienia flagi dostępu do sieci publicznej.

- Zapisz zmiany. Propagacja zmian może potrwać do pięciu minut.

Ograniczenia

Jeśli masz centrum AI Studio z zarządzanym wystąpieniem obliczeniowym utworzonym przed 11 lipca 2024 r., zarządzane obliczenia dodane do projektów w tym centrum nie będą zgodne z konfiguracją sieciową centrum. Zamiast tego należy utworzyć nowe zarządzane zasoby obliczeniowe dla centrum i utworzyć nowe wdrożenia bezserwerowego interfejsu API w projekcie, aby nowe wdrożenia mogły być zgodne z konfiguracją sieci koncentratora.

Jeśli masz centrum AI Studio z wdrożeniami maaS utworzonymi przed 11 lipca 2024 r. i włączysz zarządzane zasoby obliczeniowe w tym centrum, istniejące wdrożenia usługi MaaS nie będą zgodne z konfiguracją sieciową centrum. Aby wdrożenia bezserwerowego interfejsu API w centrum postępowały zgodnie z konfiguracją sieci koncentratora, należy ponownie utworzyć wdrożenia.

Obecnie obsługa usługi Azure OpenAI on Your Data nie jest dostępna w przypadku wdrożeń usługi MaaS w prywatnych centrach, ponieważ prywatne centra mają wyłączoną flagę dostępu do sieci publicznej.

Propagowanie dowolnej zmiany konfiguracji sieci (na przykład włączenie lub wyłączenie flagi dostępu do sieci publicznej) może potrwać do pięciu minut.