Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Zusammenfassung

Azure HDInsight ist unter Enterprisekunden einer der beliebtesten Dienste für Open-Source-Analysen in Azure. Abonnieren Sie die HDInsight-Versionshinweise, die aktuelle Informationen zu HDInsight und allen HDInsight-Versionen enthalten.

Klicken Sie zum Abonnieren auf die Schaltfläche „Ansehen“ im Banner, und prüfen Sie auf neue HDInsight-Releases.

Informationen zu dieser Version

Veröffentlichungsdatum: 28. April 2025

Hinweis

Dies ist eine Hotfix-/Wartungsversion für Ressourcenanbieter. Weitere Informationen finden Sie unter: Ressourcenanbieter.

Azure HDInsight veröffentlicht regelmäßig Wartungsupdates für die Bereitstellung von Fehlerbehebungen, Leistungsverbesserungen und Sicherheitspatches, um sicherzustellen, dass Sie mit diesen Updates auf dem neuesten Stand sind, und dass eine optimale Leistung und Zuverlässigkeit garantiert wird.

Diese Versionshinweise gelten für

HDInsight Version 5.1

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2501080039. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Behobene Fehler

- Bei verwalteter identitätsbasierter Authentifizierung für WASB treten Probleme auf, wenn die Netzwerk-ACL im Speicher aktiviert ist.

- Bei der verwalteten identitätsbasierten Authentifizierung für SQL-Datenbanken treten Probleme auf, wenn Verfügbarkeitszonen verwendet werden.

- Mehrere Sicherheitsfixes.

Aktualisierungen

- Aktive PIN-Anforderungen zum Erstellen von HDInsight-Clustern mit vordefinierten Bildversionen werden am 26. Mai 2025 widerrufen/abgebrochen. Ab diesem Datum können Kunden nur Cluster mithilfe der aktualisierten (kompatiblen) Images jeder HDInsight-Version erstellen. Diese Maßnahme soll die Clustersicherheit verbessern und potenzielle Probleme mit Clustern und Gatewayknoten verhindern.

Erinnerung

Der HDInsight-Dienst wurde für alle Clusterkonfigurationen aufgrund der Ankündigung der Einstellung von Azure Load Balancer Basic auf Standard-Lastenausgleichsmodule umgestellt.

Wichtig

Standardmäßig erfolgt die Erstellung eines neuen HDInsight-Clusters mit Standardlastenausgleichsmodulen. Wir empfehlen, sich auf den Migrationsleitfaden zum Neuerstellen des Clusters zu beziehen. Wenden Sie sich an den Support, um Unterstützung zu erhalten.

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die aktuellen Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheitskorrekturen bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 23. Januar 2025

Azure HDInsight veröffentlicht regelmäßig Wartungsupdates für die Bereitstellung von Fehlerbehebungen, Leistungsverbesserungen und Sicherheitspatches, um sicherzustellen, dass Sie mit diesen Updates auf dem neuesten Stand sind, und dass eine optimale Leistung und Zuverlässigkeit garantiert wird.

Diese Versionshinweise gelten für

HDInsight Version 5.1

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2501080039. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Neue Funktion

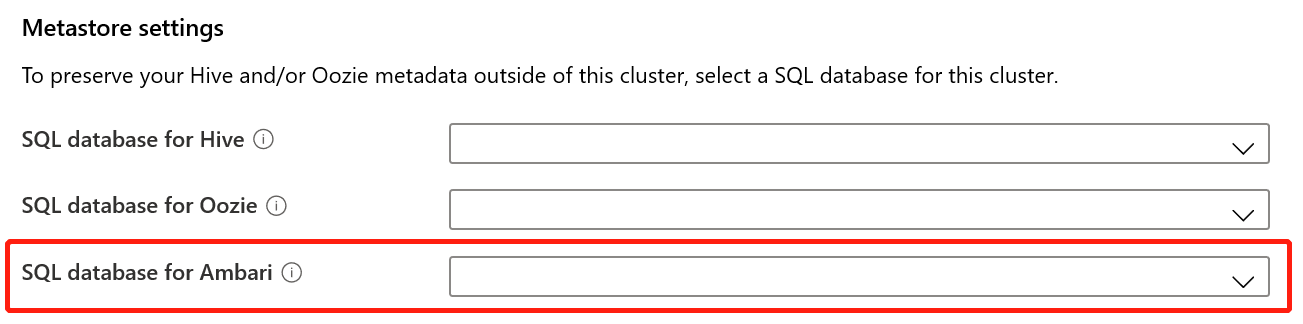

MSI-basierte Authentifizierung für SQL-Datenbanken

HDInsight bietet jetzt die Option „Verwaltete Identität“ für die sichere Authentifizierung bei SQL-Datenbanken in den Clusterangeboten. Diese Erweiterung stellt einen sichereren Mechanismus für die Authentifizierung bereit. Weitere Informationen finden Sie unter Verwendung der verwalteten Identität für die SQL-Datenbankauthentifizierung in Azure HDInsight.

Führen Sie die folgenden Schritte aus, um die Option „Verwaltete Identität“ für SQL-Datenbanken zu verwenden:

Dies Funktion wird nicht standardmäßig aktiviert. Um es zu aktivieren, senden Sie ein Supportticket mit Ihren Abonnement- und Regionsdetails.

Nachdem die Funktion aktiviert wurde, erstellen Sie den Cluster neu.

Hinweis

Verwaltete Identität ist derzeit nur in öffentlichen Regionen verfügbar. Es wird in zukünftigen Versionen für andere Regionen (Bundes- und China-Regionen) eingeführt.

Neue Regionen

- Neuseeland, Norden

Erinnerung

Der HDInsight-Dienst wurde für alle Clusterkonfigurationen aufgrund der Ankündigung der Einstellung von Azure Load Balancer Basic auf Standard-Lastenausgleichsmodule umgestellt.

Hinweis

Diese Änderung ist in allen Regionen verfügbar. Erstellen Sie Ihren Cluster neu, um diese Änderung zu berücksichtigen. Wenden Sie sich an den Support, um Unterstützung zu erhalten.

Wichtig

Wenn Sie Ihr eigenes virtuelles Netzwerk (benutzerdefiniertes VNet) während der Clustererstellung verwenden, sollten Sie beachten, dass die Clustererstellung nach der Aktivierung dieser Änderung nicht mehr erfolgreich ist. Wir empfehlen, sich auf den Migrationsleitfaden zum Neuerstellen des Clusters zu beziehen. Wenden Sie sich an den Support, um Unterstützung zu erhalten.

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

Bald verfügbar

Bald verfügbar

- Benachrichtigungen zur Einstellung von HDInsight 4.0 und HDInsight 5.0.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die aktuellen Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheitskorrekturen bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 22. Oktober 2024

Hinweis

Dies ist eine Hotfix-/Wartungsversion für Ressourcenanbieter. Weitere Informationen finden Sie unter: Ressourcenanbieter.

Azure HDInsight veröffentlicht regelmäßig Wartungsupdates für die Bereitstellung von Fehlerbehebungen, Leistungsverbesserungen und Sicherheitspatches, um sicherzustellen, dass Sie mit diesen Updates auf dem neuesten Stand sind, und dass eine optimale Leistung und Zuverlässigkeit garantiert wird.

Diese Versionshinweise gelten für

HDInsight Version 5.1

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2409240625. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Aktualisiert

Unterstützung für die MSI-basierte Authentifizierung für Azure Blob Storage verfügbar.

- Azure HDInsight unterstützt jetzt die OAuth-basierte Authentifizierung für den Zugriff auf Azure Blob Storage durch Nutzung von Azure Active Directory (AAD) und verwalteten Identitäten (MSI). Mit dieser Erweiterung verwendet HDInsight benutzerseitig zugewiesene verwaltete Identitäten für den Zugriff auf Azure Blob Storage. Weitere Informationen finden Sie unter Verwaltete Identitäten für Azure-Ressourcen.

Der HDInsight-Dienst wurde für alle Clusterkonfigurationen aufgrund der Ankündigung der Einstellung von Azure Load Balancer Basic auf Standard-Lastenausgleichsmodule umgestellt.

Hinweis

Diese Änderung ist in allen Regionen verfügbar. Erstellen Sie Ihren Cluster neu, um diese Änderung zu berücksichtigen. Wenden Sie sich an den Support, um Unterstützung zu erhalten.

Wichtig

Wenn Sie Ihr eigenes virtuelles Netzwerk (benutzerdefiniertes VNet) während der Clustererstellung verwenden, sollten Sie beachten, dass die Clustererstellung nach der Aktivierung dieser Änderung nicht mehr erfolgreich ist. Wir empfehlen, sich auf den Migrationsleitfaden zum Neuerstellen des Clusters zu beziehen. Wenden Sie sich an den Support, um Unterstützung zu erhalten.

Bald verfügbar

Bald verfügbar

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

Benachrichtigungen zur Einstellung von HDInsight 4.0 und HDInsight 5.0.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die aktuellen Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheitskorrekturen bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 30. August 2024

Hinweis

Dies ist eine Hotfix-/Wartungsversion für Ressourcenanbieter. Weitere Informationen finden Sie unter: Ressourcenanbieter.

Azure HDInsight veröffentlicht regelmäßig Wartungsupdates für die Bereitstellung von Fehlerbehebungen, Leistungsverbesserungen und Sicherheitspatches, um sicherzustellen, dass Sie mit diesen Updates auf dem neuesten Stand sind, und dass eine optimale Leistung und Zuverlässigkeit garantiert wird.

Diese Versionshinweise gelten für

HDInsight Version 5.1

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2407260448. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Problem behoben

- Standardmäßige DB-Fehlerkorrektur

Demnächst verfügbar

-

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- Benachrichtigungen zur Einstellung von HDInsight 4.0 und HDInsight 5.0.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 9. August 2024

Diese Versionshinweise gelten für

HDInsight Version 5.1

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2407260448. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Aktualisierungen

Hinzufügung von Azure Monitor Agent für Log Analytics in HDInsight

Hinzufügung von SystemMSI und automatisierten DCR für Log-Analysen angesichts der Abschaffung der neuen Azure Monitor-Erfahrung (Vorschau)

Hinweis

Effektive Imagenummer 2407260448: Kunden, die das Portal für Protokollanalysen verwenden, nutzen die Standardversion von Azure Monitor-Agent. Falls Sie zur Azure Monitor-Benutzeroberfläche (Vorschau) wechseln möchten, können Sie Ihre Cluster an alte Image anheften, indem Sie eine Supportanfrage stellen.

Veröffentlichungsdatum: 05. Juli 2024

Hinweis

Dies ist eine Hotfix-/Wartungsversion für Ressourcenanbieter. Weitere Informationen finden Sie unter: Ressourcenanbieter.

Behobene Probleme

HOBO-Tags überschreiben Benutzertags.

- HOBO-Tags überschreiben Benutzertags auf Unterressourcen bei der HDInsight-Clustererstellung.

Veröffentlichungsdatum: 19. Juni 2024

Diese Versionshinweise gelten für

HDInsight Version 5.1

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2406180258. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Behobene Probleme

Sicherheitserweiterungen

Verbesserungen in der HDInsight Log Analytics mit System Managed Identity-Unterstützung für HDInsight Resource Provider.

Hinzufügen einer neuen Aktivität zum Aktualisieren der

mdsd-Agent-Version für alte Images (älter als 2024).Aktivierung von MISE im Gateway als Teil der fortlaufenden Verbesserungen der MSAL Migration.

Integrieren Sie Spark Thrift Server

Httpheader hiveConfin die Jetty HTTP ConnectionFactory.Widerruf von RANGER-3753 und RANGER-3593.

Die

setOwnerUser-Implementierung in der Version Ranger 2.3.0 hat ein kritisches Regressionsproblem, wenn sie von Hive verwendet wird. Wenn HiveServer2 in Ranger 2.3.0 versucht, die Richtlinien auszuwerten, versucht der Ranger-Client, den Eigentümer der Hive-Tabelle zu ermitteln, indem er den Metastore in der Funktion setOwnerUser aufruft, die im Wesentlichen den Speicher anruft, um den Zugriff auf diese Tabelle zu prüfen. Dieses Problem führt dazu, dass die Abfragen langsam laufen, wenn Hive auf 2.3.0 Ranger läuft.

Neue Regionen hinzugefügt

- Italien, Norden

- Israel, Mitte

- Spanien, Mitte

- Mexiko, Mitte

- Jio Indien, Mitte

In Archivhinweisen vom Juni 2024 hinzufügen

Demnächst verfügbar

-

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- Benachrichtigungen zur Einstellung von HDInsight 4.0 und HDInsight 5.0.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 16. Mai 2024

Diese Versionshinweise gelten für

HDInsight Version 5.0

HDInsight Version 4.0

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2405081840. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Behobene Probleme

- Im Rahmen der SFI-Initiative wurde dem Gateway eine API hinzugefügt, um Token für Keyvault zu erhalten.

- In der neuen Protokollüberwachungstabelle

HDInsightSparkLogsfür den ProtokolltypSparkDriverLogfehlten einige der Felder. Beispiel:LogLevel & Message. Diese Version fügt die fehlenden Felder zu Schemata und fester Formatierung fürSparkDriverLoghinzu. - Livy-Protokolle sind in der Log Analytics-Überwachungstabelle

SparkDriverLognicht verfügbar, was auf ein Problem mit dem Livy-Protokollquellenpfad und der Protokollparsing-Regex in denSparkLivyLog-Konfigurationen zurückzuführen war. - Jeder HDInsight-Cluster, der ADLS Gen2 als primäres Speicherkonto verwendet, kann den MSI-basierten Zugriff auf alle Azure-Ressourcen (z. B. SQL, Keyvaults) nutzen, die im Anwendungscode verwendet werden.

Bald verfügbar

-

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- Benachrichtigungen zur Einstellung von HDInsight 4.0 und HDInsight 5.0.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 15. April 2024

Diese Versionshinweise gelten für die Version HDInsight 5.1.

Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Diese Versionshinweise gelten für die Imagenummer 2403290825. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workloadspezifischen Versionen finden Sie unter HDInsight 5.x-Komponentenversionen.

Behobene Probleme

- Fehlerbehebungen für Ambari DB, Hive Warehouse Controller (HWC), Spark, HDFS

- Fehlerbehebungen für das Protokollanalysemodul für HDInsightSparkLogs

- CVE-Fixes für HDInsight-Ressourcenanbieter.

Demnächst verfügbar

-

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- Benachrichtigungen zur Einstellung von HDInsight 4.0 und HDInsight 5.0.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen.

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community.

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 15. Februar 2024

Dieses Release gilt für die HDInsight-Versionen 4.x und 5.x. Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Dieses Release gilt für die Imagenummer 2401250802. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workload-spezifischen Versionen finden Sie

Neue Funktionen

- Apache Ranger-Unterstützung für Spark SQL in Spark 3.3.0 (HDInsight Version 5.1) mit Enterprise-Sicherheitspaket. Weitere Informationen dazu finden Sie hier.

Behobene Probleme

- Sicherheitsupdates von Ambari- und Oozie-Komponenten

Bald verfügbar

Bald verfügbar

- Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Nächste Schritte

- Azure HDInsight: Häufig gestellte Fragen

- Konfigurieren des Zeitplans für das Patchen des Betriebssystems für Linux-basierte HDInsight-Cluster

- Vorherige Versionshinweise

Azure HDInsight ist unter Enterprisekunden einer der beliebtesten Dienste für Open-Source-Analysen in Azure. Wenn Sie die Anmerkungen zu dieser Version abonnieren möchten, sehen Sie sich die Releases auf diesem GitHub-Repository an.

Veröffentlichungsdatum: 10. Januar 2024

Dieses Hotfixrelease gilt für die HDInsight-Versionen 4.x und 5.x. Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Dieses Release gilt für die Imagenummer 2401030422. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Hinweis

Ubuntu 18.04 wird unter ESM (Extended Security Maintenance) vom Azure Linux-Team ab dem Release Azure HDInsight Juli 2023 unterstützt.

Informationen zu workload-spezifischen Versionen finden Sie

Behobene Probleme

- Sicherheitsupdates von Ambari- und Oozie-Komponenten

Bald verfügbar

Bald verfügbar

- Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 26. Oktober 2023

Dieses Release gilt für HDInsight 4.x und 5.x. Das HDInsight-Release wird für alle Regionen mehrere Tage lang verfügbar sein. Dieses Release gilt für die Image-Nummer 2310140056. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informationen zu workload-spezifischen Versionen finden Sie

Neuerungen

HDInsight kündigt die allgemeine Verfügbarkeit von HDInsight 5.1 ab dem 1. November 2023 an. Diese Version bietet eine vollständige Stapelaktualisierung der Open Source-Komponenten und der Integrationen von Microsoft.

- Die neuesten Open Source-Versionen – Für HDInsight 5.1 ist die neueste stabile Open-Source-Version verfügbar. Kunden können von allen neuesten Open-Source-Features, Microsoft-Leistungsverbesserungen und Bugfixes profitieren.

- Sicher – Die aktuellsten Versionen enthalten die neuesten Sicherheitsverbesserungen, sowohl Open-Source als auch von Microsoft.

- Niedrigere Gesamtkosten – Dank der Leistungsverbesserungen und der verbesserte Autoskalierung können Kunden die Betriebskosten senken.

Cluster-Berechtigungen für sicheren Speicher

- Kunden können (während der Cluster-Erstellung) angeben, ob ein sicherer Kanal für HDInsight-Cluster-Knoten für die Verbindung des Speicherkontos verwendet werden soll.

HDInsight-Clustererstellung mit benutzerdefinierten VNETs

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

Microsoft Network/virtualNetworks/subnets/join/actionverfügen, um Erstellungsvorgänge ausführen zu können. Es können Fehler bei der Erstellung auftreten, wenn diese Überprüfung nicht aktiviert ist.

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

ABFS-Cluster ohne ESP [Clusterberechtigungen für World Readable]

- ABFS-Cluster ohne Enterprise-Sicherheitspaket hindern Gruppenbenutzer ohne Hadoop an der Ausführung von Hadoop-Befehlen für Speichervorgänge. Diese Änderung dient dazu, den Sicherheitsstatus des Clusters zu verbessern.

Inline-Kontingentaktualisierung

- Jetzt können Sie die Kontingenterhöhung direkt von der Seite „Mein Kontingent“ anfordern, wobei der direkte API-Aufruf viel schneller ist. Wenn der API-Aufruf fehlschlägt, können Sie eine neue Supportanfrage zur Erhöhung des Kontingents erstellen.

Bald verfügbar

Bald verfügbar

Die maximale Länge des Clusternamens wird von 59 auf 45 Zeichen geändert, um den Sicherheitsstatus von Clustern zu verbessern. Diese Änderung wird mit der bevorstehenden Veröffentlichung für alle Regionen eingeführt.

Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten.

- Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen

Wir hören zu: Unter HDInsight Ideas können Sie gerne weitere Ideen sowie andere Themen hinzufügen und abstimmen. Folgen Sie uns für weitere Neuigkeiten in der Azure HDInsight-Community

Hinweis

Dieses Release behandelt die folgenden CVEs, die am 12. September 2023 von MSRC veröffentlicht wurden. Die Aktion besteht darin, auf das neueste Image 2308221128 oder 2310140056 zu aktualisieren. Kunden wird empfohlen, dies entsprechend zu planen.

| CVE | severity | CVE-Titel | Anmerkung |

|---|---|---|---|

| CVE-2023-38156 | Wichtig | Sicherheitsanfälligkeit in Azure HDInsight: Rechteerweiterung in Apache Ambari | Im Image 2308221128 oder 2310140056 enthalten |

| CVE-2023-36419 | Wichtig | Sicherheitsanfälligkeit in Azure HDInsight: Rechteerweiterung in Apache Oozie Workflow Scheduler | Anwenden einer Skriptaktion auf Ihre Cluster oder Aktualisieren auf Image 2310140056 |

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 7. September 2023

Dieses Release gilt für HDInsight 4.x und 5.x. Das HDInsight-Release wird für alle Regionen mehrere Tage lang verfügbar sein. Dieses Release gilt für die Image-Nummer 2308221128. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informationen zu workload-spezifischen Versionen finden Sie

Wichtig

Dieses Release behandelt die folgenden CVEs, die am 12. September 2023 von MSRC veröffentlicht wurden. Die Aktion besteht darin, auf das neueste Image 2308221128 zu aktualisieren. Kunden wird empfohlen, dies entsprechend zu planen.

| CVE | severity | CVE-Titel | Anmerkung |

|---|---|---|---|

| CVE-2023-38156 | Wichtig | Sicherheitsanfälligkeit in Azure HDInsight: Rechteerweiterung in Apache Ambari | Im Image 2308221128 enthalten |

| CVE-2023-36419 | Wichtig | Sicherheitsanfälligkeit in Azure HDInsight: Rechteerweiterung in Apache Oozie Workflow Scheduler | Anwenden einer Skriptaktion auf Ihre Cluster |

In Kürze verfügbar

- Die maximale Länge des Clusternamens wird von 59 auf 45 Zeichen geändert, um den Sicherheitsstatus von Clustern zu verbessern. Diese Änderung wird bis zum 30. September 30 2023 implementiert.

- Cluster-Berechtigungen für sicheren Speicher

- Kunden können (während der Cluster-Erstellung) angeben, ob ein sicherer Kanal für HDInsight-Cluster-Knoten zum Kontaktieren des Speicherkontos verwendet werden soll.

- Inline-Kontingentaktualisierung

- Anforderungskontingente werden direkt über die Seite „Mein Kontingent“ erhöht. Dies ist ein direkter API-Aufruf und daher schneller. Wenn der APdl-Aufruf fehlschlägt, müssen Kunden eine neue Supportanfrage zur Erhöhung des Kontingents erstellen.

- HDInsight-Clustererstellung mit benutzerdefinierten VNETs

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

Microsoft Network/virtualNetworks/subnets/join/actionverfügen, um Erstellungsvorgänge ausführen zu können. Kunden sollten entsprechend planen, da es sich bei dieser Änderung um eine obligatorische Überprüfung handelt, um Fehler bei der Erstellung von Clustern nach dem 30. September 2023 zu vermeiden.

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

- Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten. Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- ABFS-Cluster ohne ESP [Clusterberechtigungen für World Readable]

- Planen Sie die Einführung einer Änderung in ABFS-Clustern ohne Enterprise-Sicherheitspaket, die Gruppenbenutzer ohne Hadoop an der Ausführung von Hadoop-Befehlen für Speichervorgänge hindert. Diese Änderung dient dazu, den Sicherheitsstatus des Clusters zu verbessern. Kunden müssen die Updates vor dem 30. September 2023 einplanen.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen

In der HDInsight Community (azure.com) können Sie gerne weitere Vorschläge und Ideen sowie andere Themen hinzufügen und abstimmen.

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 25. Juli 2023

Dieses Release gilt für HDInsight 4.x und 5.x. Das HDInsight-Release wird für alle Regionen mehrere Tage lang verfügbar sein. Dieses Release gilt für die Imagenummer 2307201242. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informationen zu workload-spezifischen Versionen finden Sie

Neuigkeiten

Neuigkeiten

- HDInsight 5.1 wird jetzt mit ESP-Clustern unterstützt.

- Aktualisierte Versionen von Ranger 2.3.0 und Oozie 5.2.1 sind jetzt Bestandteil von HDInsight 5.1

- Der Spark 3.3.1-Cluster (HDInsight 5.1) umfasst den Hive Warehouse-Connector 2.1 (HWC), der mit dem Interactive Query-Cluster (HDInsight 5.1) zusammenarbeitet.

- Ubuntu 18.04 wird unter ESM(Extended Security Maintenance) vom Azure Linux-Team für Azure HDInsight Juli 2023 ab Version unterstützt.

Wichtig

Dieses Release behandelt die folgenden CVEs, die am 8. August 2023 von MSRC veröffentlicht wurden. Die Aktion besteht darin, auf das neueste Image 2307201242 zu aktualisieren. Kunden wird empfohlen, dies entsprechend zu planen.

| CVE | severity | CVE-Titel |

|---|---|---|

| CVE-2023-35393 | Wichtig | Spoofing-Sicherheitsrisiko in Azure Apache Hive |

| CVE-2023-35394 | Wichtig | Spoofing-Sicherheitsrisiko in Azure HDInsight-Jupyter Notebook |

| CVE-2023-36877 | Wichtig | Spoofing-Sicherheitsrisiko in Azure Apache Oozie |

| CVE-2023-36881 | Wichtig | Spoofing-Sicherheitsrisiko in Azure Apache Ambari |

| CVE-2023-38188 | Wichtig | Spoofing-Sicherheitsrisiko in Azure Apache Hadoop |

Bald verfügbar

Bald verfügbar

- Die maximale Länge des Clusternamens wird von 59 auf 45 Zeichen geändert, um den Sicherheitsstatus von Clustern zu verbessern. Kunden müssen die Updates vor dem 30. September 2023 einplanen.

- Cluster-Berechtigungen für sicheren Speicher

- Kunden können (während der Cluster-Erstellung) angeben, ob ein sicherer Kanal für HDInsight-Cluster-Knoten zum Kontaktieren des Speicherkontos verwendet werden soll.

- Inline-Kontingentaktualisierung

- Anforderungskontingente werden direkt über die Seite „Mein Kontingent“ erhöht. Dies ist ein direkter API-Aufruf und daher schneller. Wenn der API-Aufruf fehlschlägt, müssen Kunden eine neue Supportanfrage zur Erhöhung des Kontingents erstellen.

- HDInsight-Clustererstellung mit benutzerdefinierten VNETs

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

Microsoft Network/virtualNetworks/subnets/join/actionverfügen, um Erstellungsvorgänge ausführen zu können. Kunden sollten entsprechend planen, da es sich bei dieser Änderung um eine obligatorische Überprüfung handelt, um Fehler bei der Erstellung von Clustern nach dem 30. September 2023 zu vermeiden.

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

- Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten. Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- ABFS-Cluster ohne ESP [Clusterberechtigungen für World Readable]

- Planen Sie die Einführung einer Änderung in ABFS-Clustern ohne Enterprise-Sicherheitspaket, die Gruppenbenutzer ohne Hadoop an der Ausführung von Hadoop-Befehlen für Speichervorgänge hindert. Diese Änderung dient dazu, den Sicherheitsstatus des Clusters zu verbessern. Kund*innen müssen die Updates vor dem 30. September 2023 einplanen.

Sollten Sie weitere Fragen haben, wenden Sie sich an den Azure-Support.

Sie können uns Fragen zu HDInsight jederzeit im Microsoft Q&A zu Azure HDInsight stellen

In der HDInsight Community (azure.com) können Sie gerne weitere Vorschläge und Ideen sowie andere Themen hinzufügen und abstimmen. Hier können Sie uns auf X folgen

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 08. Mai 2023

Dieses Release gilt für HDInsight 4.x und 5.x. Das HDInsight-Release wird für alle Regionen mehrere Tage lang verfügbar sein. Dieses Release gilt für die Image-Nummer 2304280205. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informationen zu workload-spezifischen Versionen finden Sie

![]()

Azure HDInsight 5.1 aktualisiert mit

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Apache 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Hinweis

- Alle Komponenten sind in Hadoop 3.3.4 und ZK 3.6.3 integriert

- Alle oben aktualisierten Komponenten sind jetzt in Nicht-ESP-Clustern für die öffentliche Vorschau verfügbar.

![]()

Erweiterte Autoskalierung für HDInsight

Azure HDInsight hat die Stabilität und Latenz bei der automatischen Skalierung erheblich verbessert. Die wesentlichen Änderungen umfassen eine verbesserte Feedbackschleife für Skalierungsentscheidungen, eine deutliche Verbesserung der Latenz für die Skalierung und Unterstützung für die Wiedereinsetzung der außer Betrieb gesetzten Knoten. Erfahren Sie mehr über die Erweiterungen und wie Sie Ihren Cluster benutzerdefiniert konfigurieren und zu einer verbesserten Autoskalierung migrieren können. Die erweiterte Autoskalierungsfunktion ist ab dem 17. Mai 2023 in allen unterstützten Regionen verfügbar.

Azure HDInsight ESP für Apache Kafka 2.4.1 ist jetzt allgemein verfügbar.

Azure HDInsight ESP für Apache Kafka 2.4.1 befindet sich seit April 2022 in der öffentlichen Vorschauphase. Nach bedeutenden Verbesserungen bei CVE-Fixes und -Stabilität ist Azure HDInsight ESP Kafka 2.4.1 jetzt allgemein verfügbar und bereit für Produktionsworkloads. Hier finden Sie weitere Informationen zur Konfiguration und zur Migration.

Kontingentverwaltung für HDInsight

HDInsight ordnet Kundenabonnements derzeit Kontingente auf regionaler Ebene zu. Die Kunden zugeordneten Kerne sind generisch und nicht auf VM-Familienebene klassifiziert (z. B.

Dv2,Ev3,Eav4usw.).HDInsight hat eine verbesserte Ansicht eingeführt, die Details und eine Klassifizierung von Kontingenten für VMs auf Familienebene bietet. Mit diesem Feature können Kunden aktuelle und verbleibende Kontingente für eine Region auf VM-Familienebene anzeigen. Die erweiterte Ansicht bieten den Kunden eine umfassendere Transparenz für die Planung von Kontingenten sowie eine bessere Benutzererfahrung. Dieses Feature ist derzeit in HDInsight 4.x und 5.x für die EUAP-Region „USA, Osten“ verfügbar. Weitere Regionen werden später folgen.

Weitere Informationen finden Sie unter Anzeigen der Kontingentverwaltung für HDInsight | Microsoft Learn.

![]()

- Polen, Mitte

- Die maximale Länge des Clusternamens wird von 59 in 45 Zeichen geändert, um den Sicherheitsstatus von Clustern zu verbessern.

- Cluster-Berechtigungen für sicheren Speicher

- Kunden können (während der Cluster-Erstellung) angeben, ob ein sicherer Kanal für HDInsight-Cluster-Knoten zum Kontaktieren des Speicherkontos verwendet werden soll.

- Inline-Kontingentaktualisierung

- Anforderungskontingente werden direkt über die Seite „Mein Kontingent“ erhöht. Dies ist ein direkter API-Aufruf und daher schneller. Wenn der API-Aufruf fehlschlägt, müssen Kunden eine neue Supportanfrage zur Erhöhung des Kontingents erstellen.

- HDInsight-Clustererstellung mit benutzerdefinierten VNETs

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

Microsoft Network/virtualNetworks/subnets/join/actionverfügen, um Erstellungsvorgänge ausführen zu können. Kunden müssten entsprechend planen, da dies eine obligatorische Überprüfung ist, um Fehler bei der Clustererstellung zu vermeiden.

- Zur Verbesserung des allgemeinen Sicherheitsstatus der HDInsight-Cluster muss für HDInsight-Cluster mit Verwendung benutzerdefinierter VNETs sichergestellt werden, dass die Benutzer*innen über die Berechtigung für

- Einstellung von Basic- und Standard-VMs der A-Serie

- Am 31. August 2024 werden die Basic- und Standard-VMs der A-Serie ausgemustert. Vor diesem Datum müssen Sie Ihre Workloads auf VMs der Av2-Serie migrieren, die mehr Arbeitsspeicher pro vCPU und schnelleren Speicher auf SSD-Laufwerken (Solid State Drive) bieten. Um Dienstunterbrechungen zu vermeiden, migrieren Sie Ihre Workloads von VMs der Basic- und Standard-A-Serie vor dem 31. August 2024 zu VMs der Av2-Serie.

- ABFS-Cluster ohne Enterprise-Sicherheitspaket [Cluster-Berechtigungen für World Readable]

- Planen Sie die Einführung einer Änderung in ABFS-Clustern ohne Enterprise-Sicherheitspaket, die Gruppenbenutzer ohne Hadoop an der Ausführung von Hadoop-Befehlen für Speichervorgänge hindert. Diese Änderung dient dazu, den Sicherheitsstatus des Clusters zu verbessern. Kunden müssen die Updates planen.

Veröffentlichungsdatum: 28. Februar 2023

Dieses Release gilt für HDInsight 4.0. und 5.0, 5.1. Das HDInsight-Release ist mehrere Tage lang für alle Regionen verfügbar. Dieses Release gilt für die Image-Nummer 2302250400. Wie überprüft man die Image-Nummer?

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Informationen zu workload-spezifischen Versionen finden Sie

Wichtig

Microsoft hat CVE-2023-23408 veröffentlicht, die in der aktuellen Version behoben sind, und Kunden wird empfohlen, ein Upgrade ihres Clusters auf das neueste Image zu durchzuführen.

![]()

HDInsight 5.1

Wir haben mit dem Rollout einer neuen Version von HDInsight 5.1 begonnen. Alle neuen Open-Source-Releases werden als inkrementelle Releases auf HDInsight 5.1 hinzugefügt.

Weitere Informationen finden Sie unter HDInsight 5.1.0-Version

![]()

Kafka 3.2.0-Upgrade (Vorschau)

- Kafka 3.2.0 enthält mehrere wichtige neue Features/Verbesserungen.

- Zookeeper auf 3.6.3 geupgradet

- Unterstützung für Kafka Streams

- Höhere Liefergarantien für den standardmäßig aktivierten Kafka Producer.

-

log4j1.x ersetzt durchreload4j. - Senden Sie einen Hinweis an den Partitionsleiter, um die Partition wiederherzustellen.

-

JoinGroupRequestundLeaveGroupRequesthaben einen Grund angefügt. - Broker-Anzahlmetriken8 hinzugefügt.

- Mirror

Maker2Verbesserungen.

HBase 2.4.11-Upgrade (Vorschau)

- Diese Version bietet neue Features, z. B. das Hinzufügen neuer Cache-Mechanismustypen für den Block-Cache, die Möglichkeit, die Tabelle über die HBase-WEB-Benutzeroberfläche zu ändern

hbase:meta tableund anzuzeigenhbase:meta.

Phoenix 5.1.2-Upgrade (Vorschau)

- Die Phoenix-Version wurde in diesem Release auf 5.1.2 upgegradet. Dieses Upgrade umfasst den Phoenix Query Server. Der Phoenix Query Server stellt den standardmäßigen Phoenix JDBC-Treiber als Proxy und ein abwärtskompatibles Wire-Protokoll zum Aufrufen dieses JDBC-Treibers bereit.

Ambari-CVEs

- Mehrere Ambari-CVEs sind behoben.

Hinweis

ESP wird in dieser Version nicht für Kafka und HBase unterstützt.

![]()

Nächste Schritte

- Automatische Skalierung

- Automatische Skalierung mit verbesserter Latenz und mehreren Verbesserungen

- Einschränkung der Änderung des Cluster-Namens

- Die maximale Länge des Clusternamens wird in Public, Azure China und Azure Government in 45 von 59 geändert.

- Cluster-Berechtigungen für sicheren Speicher

- Kunden können (während der Cluster-Erstellung) angeben, ob ein sicherer Kanal für HDInsight-Cluster-Knoten zum Kontaktieren des Speicherkontos verwendet werden soll.

- ABFS-Cluster ohne Enterprise-Sicherheitspaket [Cluster-Berechtigungen für World Readable]

- Planen Sie die Einführung einer Änderung in ABFS-Clustern ohne Enterprise-Sicherheitspaket, die Gruppenbenutzer ohne Hadoop an der Ausführung von Hadoop-Befehlen für Speichervorgänge hindert. Diese Änderung dient dazu, den Sicherheitsstatus des Clusters zu verbessern. Kunden müssen die Updates planen.

- Open-Source-Upgrades

- Apache Spark 3.3.0 und Hadoop 3.3.4 werden in HDInsight 5.1 entwickelt und enthalten einige wichtige neue Features, Leistungsverbesserungen und andere Verbesserungen.

Hinweis

Wir empfehlen Kunden, die neuesten Versionen von HDInsight-Images zu verwenden, da sie das Beste aus Open Source-Updates, Azure-Updates und Sicherheits-Patches bieten. Weitere Informationen finden Sie unter Bewährte Methoden.

Veröffentlichungsdatum: 12. Dezember 2022

Dieses Release gilt für HDInsight 4.0. Das HDInsight 5.0-Release wird über mehrere Tage für alle Regionen verfügbar gemacht.

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

Betriebssystemversionen

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

![]()

- Log Analytics: Kunden können die klassische Überwachung aktivieren, um die neueste OMS-Version 14.19 zu erhalten. Um alte Versionen zu entfernen, deaktivieren und aktivieren Sie die klassische Überwachung.

- Automatische Benutzeroberflächenabmeldung von Ambari-Benutzern aufgrund von Inaktivität. Weitere Informationen finden Sie hier.

- Spark: In diesem Release ist eine neue und optimierte Version von Spark 3.1.3 enthalten. Wir haben Apache Spark 3.1.2 (vorherige Version) und Apache Spark 3.1.3 (aktuelle Version) mithilfe der TPC-DS-Benchmark getestet. Der Test wurde mit der E8 V3-SKU für Apache Spark für eine Workload mit 1 TB durchgeführt. Apache Spark 3.1.3 (aktuelle Version) übertraf Apache Spark 3.1.2 (Vorgängerversion) unter Verwendung derselben Hardwarespezifikationen bei der Gesamtlaufzeit von TPC-DS-Abfragen um mehr als 40 %. Das Microsoft Spark-Team hat Optimierungen hinzugefügt, die in Azure Synapse mit Azure HDInsight verfügbar sind. Weitere Informationen finden Sie unter Beschleunigen Ihrer Datenworkloads mit Leistungsupdates für Apache Spark 3.1.2 in Azure Synapse.

![]()

- Katar, Mitte

- Deutschland, Norden

![]()

HDInsight ist von Azul Zulu Java JDK 8 zu

Adoptium Temurin JDK 8gewechselt, um hochwertige TCK-zertifizierte Runtimes und zugehörige Technologie für die Verwendung im gesamten Java-Ökosystem zu unterstützen.HDInsight wurde zu

reload4jmigriert. Dielog4j-Änderungen gelten für- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache-Struktur

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

HDInsight implementiert TLS1.2 in Zukunft, und frühere Versionen werden auf der Plattform aktualisiert. Wenn Sie Anwendungen zusätzlich zu HDInsight ausführen und diese TLS 1.0 und 1.1 verwenden, führen Sie ein Upgrade auf TLS 1.2 durch, um Dienstunterbrechungen zu vermeiden.

Weitere Informationen finden Sie unter Aktivieren von TLS 1.2 auf Clients.

![]()

Am 30. November 2022 läuft der Support für Azure HDInsight-Cluster unter Ubuntu 16.04 LTS ab. HDInsight beginnt am 27. Juni 2021 mit der Veröffentlichung von Clusterimages mittels Ubuntu 18.04. Unseren Kunden, die Cluster mit Ubuntu 16.04 ausführen, wird empfohlen, ihre Cluster bis zum 30. November 2022 mit den neuesten HDInsight-Images neu zu erstellen.

Weitere Informationen zum Überprüfen der Ubuntu-Version des Clusters finden Sie hier.

Führen Sie den Befehl „lsb_release -a“ im Terminal aus.

Wenn der Wert für die Eigenschaft „Description“ in der Ausgabe „Ubuntu 16.04 LTS“ lautet, gilt dieses Update für den Cluster.

![]()

- Unterstützung der Auswahl von Verfügbarkeitszonen für Kafka- und HBase-Cluster (Schreibzugriff)

Open Source-Fehlerkorrekturen

Hive-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| HIVE-26127 | INSERT OVERWRITE-Fehler – Datei nicht gefunden |

| HIVE-24957 | Falsche Ergebnisse, wenn die Unterabfrage COALESCE im Korrelationsprädikat enthält |

| HIVE-24999 | HiveSubQueryRemoveRule generiert einen ungültigen Plan für die IN-Unterabfrage mit mehreren Korrelationen. |

| HIVE-24322 | Wenn eine direkte Einfügung erfolgt, muss die Versuchs-ID beim Lesen der Manifestdateien überprüft werden |

| HIVE-23363 | Upgrade der DataNucleus-Abhängigkeit auf 5.2 |

| HIVE-26412 | Erstellen einer Schnittstelle zum Abrufen verfügbarer Slots und Hinzufügen der Standardschnittstelle |

| HIVE-26173 | Upgrade von derby auf 10.14.2.0 |

| HIVE-25920 | Bumpen von Xerce2 zu 2.12.2. |

| HIVE-26300 | Upgrade der Jackson-Datenbindungsversion auf Version 2.12.6.1 und höher, um CVE-2020-36518 zu vermeiden |

Veröffentlichungsdatum: 10.08.2022

Dieses Release gilt für HDInsight 4.0. Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht.

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

![]()

Neue Funktion

1. Anfügen externer Datenträger in HDI Hadoop-/Spark-Clustern

Ein HDInsight-Cluster weist einen vordefinierten SKU-basierenden Speicherplatz auf. Dieser Speicherplatz reicht in umfangreichen Auftragsszenarien möglicherweise nicht aus.

Mit diesem neuen Feature können Sie weitere Datenträger im Cluster hinzufügen, die als lokales Knotenverwaltungsverzeichnis verwendet werden. Sie können bei der HIVE- und Spark-Clustererstellung mehrere Datenträger zu Workerknoten hinzufügen, während die ausgewählten Datenträger Teil der lokalen Knotenverwaltungsverzeichnisse sind.

Hinweis

Die hinzugefügten Datenträger werden nur für lokale NodeManager-Verzeichnisse konfiguriert.

Weitere Informationen finden Sie hier.

2. Selektive Protokollierungsanalyse

Die selektive Protokollierungsanalyse ist jetzt in allen Regionen als öffentliche Vorschau verfügbar. Sie können Ihren Cluster mit einem Log Analytics-Arbeitsbereich verbinden. Nach der Aktivierung können Sie die Protokolle und Metriken wie HDInsight-Sicherheitsprotokolle, Yarn Resource Manager, Systemmetriken usw. anzeigen. Sie können Workloads überwachen und sehen, wie sie sich auf die Clusterstabilität auswirken. Mit der selektiven Protokollierung können Sie alle Tabellen aktivieren/deaktivieren oder ausgewählte Tabellen im Log Analytics-Arbeitsbereich aktivieren. Sie können den Quellentyp für jede Tabelle anpassen, da eine Tabelle in der neuen Version der Geneva-Überwachung über mehrere Quellen verfügt.

- Das Geneva-Überwachungssystem verwendet mdsd (MDS-Daemon), der ein Überwachungs-Agent ist, und fluentd zum Sammeln von Protokollen mit einheitlicher Protokollierungsebene.

- Die selektive Protokollierung verwendet Skriptaktionen, um Tabellen und ihre Protokolltypen zu deaktivieren/aktivieren. Da keine neuen Ports geöffnet oder vorhandene Sicherheitseinstellungen geändert werden, gibt es keine Sicherheitsänderungen.

- Die Skriptaktion wird parallel auf allen angegebenen Knoten ausgeführt und ändert die Konfigurationsdateien zum Deaktivieren/Aktivieren von Tabellen und deren Protokolltypen.

Weitere Informationen finden Sie hier.

![]()

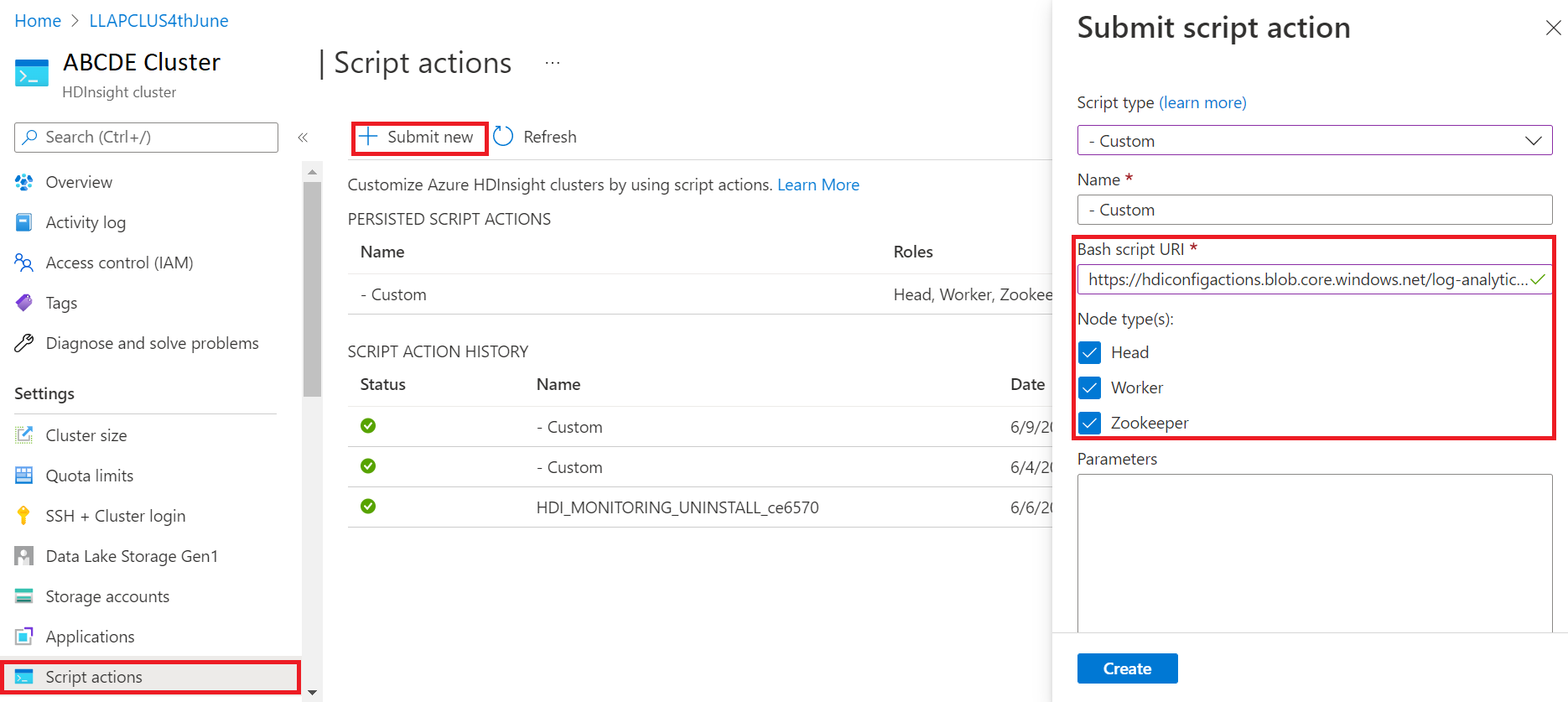

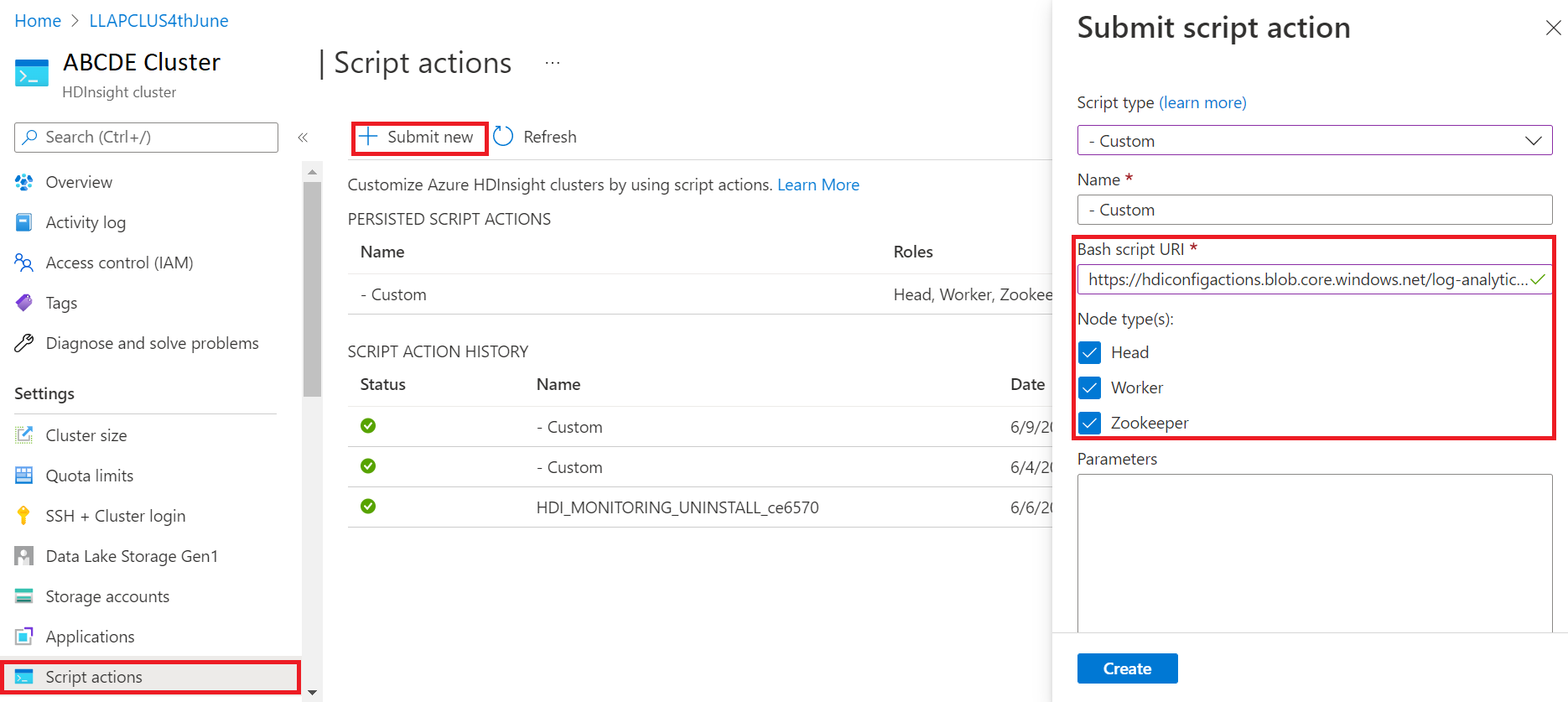

Fest

Log Analytics

Für Log Analytics, das in Azure HDInsight mit OMS-Version 13 integriert ist, muss ein Upgrade auf OMS-Version 14 durchgeführt werden, um die neuesten Sicherheitsupdates anzuwenden. Kunden, die eine ältere Version des Clusters mit OMS-Version 13 verwenden, müssen OMS-Version 14 installieren, um die Sicherheitsanforderungen zu erfüllen. (Informationen zum Überprüfen der aktuellen Version und Installieren von Version 14)

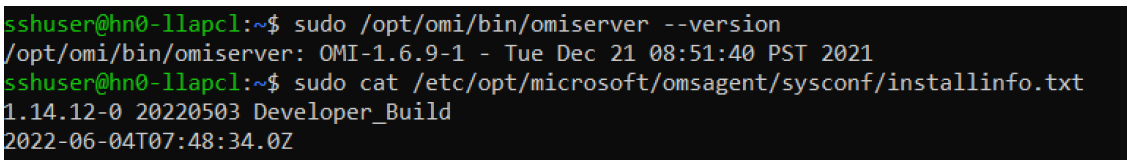

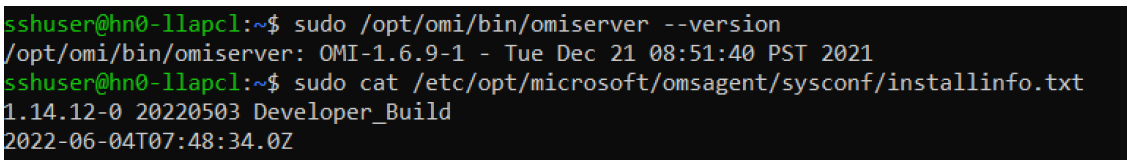

Ermitteln der aktuellen OMS-Version

- Melden Sie sich per SSH bei dem Cluster an.

- Führen Sie in Ihrem SSH-Client den folgenden Befehl aus.

sudo /opt/omi/bin/ominiserver/ --version

Aktualisieren der OMS-Version von 13 auf 14

- Melden Sie sich beim Azure-Portal

- Wählen Sie in der Ressourcengruppe die HDInsight-Clusterressource aus.

- Wählen Sie Skriptaktionen aus.

- Wählen Sie im Bereich der Skriptaktion „Übermitteln“ den Skripttyp „Benutzerdefiniert“ aus.

- Fügen Sie den folgenden Link im URL-Feld des Bash-Skripts ein: https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh.

- Wählen Sie Knotentyp(en) aus.

- Klicken Sie auf Erstellen

Führen Sie die folgenden Schritte aus, um die erfolgreiche Installation des Patchs zu überprüfen:

Melden Sie sich per SSH bei dem Cluster an.

Führen Sie in Ihrem SSH-Client den folgenden Befehl aus.

sudo /opt/omi/bin/ominiserver/ --version

Weitere Fehlerbehebungen

- Die CLI des Yarn-Protokolls kann die Protokolle nicht abrufen, wenn

TFilebeschädigt oder leer ist. - Der Fehler mit ungültigen Dienstprinzipaldetails beim Abrufen des OAuth-Token von Azure Active Directory wurde behoben.

- Verbesserte Zuverlässigkeit der Clustererstellung, wenn mehr als 100 Workerknoten konfiguriert werden.

Open Source-Fehlerkorrekturen

TEZ-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| Tez Buildfehler: FileSaver.js nicht gefunden | TEZ-4411 |

Falsche FS-Ausnahme, wenn sich Warehouse und scratchdir auf unterschiedlichen FS befinden |

TEZ-4406 |

| TezUtils.createConfFromByteString bei einer Konfiguration mit mehr als 32 MB löst eine „com.google.protobuf.CodedInputStream“-Ausnahme aus. | TEZ-4142 |

| TezUtils::createByteStringFromConf sollte snappy anstelle von DeflaterOutputStream verwenden. | TEZ-4113 |

| Aktualisierung der protobuf-Abhängigkeit auf 3.x | TEZ-4363 |

Hive-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| Perf-Optimierungen in ORC-Splitgenerierung | HIVE-21457 |

| Vermeiden, eine Tabelle als ACID zu lesen, wenn der Tabellenname mit „delta“ beginnt, die Tabelle aber nicht transaktional ist und die BI-Splitstrategie verwendet wird | HIVE-22582 |

| Entfernen eines FS#exists-Aufrufs aus AcidUtils#getLogicalLength | HIVE-23533 |

| Vektorisierung von OrcAcidRowBatchReader.computeOffset und Bucketoptimierung | HIVE-17917 |

Bekannte Probleme

HDInsight ist mit Apache HIVE 3.1.2 kompatibel. Aufgrund eines Fehlers in dieser Version wird die Hive-Version in Hive-Oberflächen als 3.1.0 angezeigt. Es gibt jedoch keine Auswirkungen auf die Funktionalität.

Veröffentlichungsdatum: 10.08.2022

Dieses Release gilt für HDInsight 4.0. Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht.

HDInsight verwendet sichere Bereitstellungsmethoden einschließlich einer graduellen Bereitstellung in Regionen. Es kann bis zu 10 Arbeitstage dauern, bis ein neues Release oder eine neue Version in allen Regionen verfügbar ist.

![]()

Neue Funktion

1. Anfügen externer Datenträger in HDI Hadoop-/Spark-Clustern

Ein HDInsight-Cluster weist einen vordefinierten SKU-basierenden Speicherplatz auf. Dieser Speicherplatz reicht in umfangreichen Auftragsszenarien möglicherweise nicht aus.

Mit diesem neuen Feature können Sie weitere Datenträger im Cluster hinzufügen, die als lokales NodeManager-Verzeichnis verwendet werden. Sie können bei der HIVE- und Spark-Clustererstellung mehrere Datenträger zu Workerknoten hinzufügen, während die ausgewählten Datenträger Teil der lokalen Knotenverwaltungsverzeichnisse sind.

Hinweis

Die hinzugefügten Datenträger werden nur für lokale NodeManager-Verzeichnisse konfiguriert.

Weitere Informationen finden Sie hier.

2. Selektive Protokollierungsanalyse

Die selektive Protokollierungsanalyse ist jetzt in allen Regionen als öffentliche Vorschau verfügbar. Sie können Ihren Cluster mit einem Log Analytics-Arbeitsbereich verbinden. Nach der Aktivierung können Sie die Protokolle und Metriken wie HDInsight-Sicherheitsprotokolle, Yarn Resource Manager, Systemmetriken usw. anzeigen. Sie können Workloads überwachen und sehen, wie sie sich auf die Clusterstabilität auswirken. Mit der selektiven Protokollierung können Sie alle Tabellen aktivieren/deaktivieren oder ausgewählte Tabellen im Log Analytics-Arbeitsbereich aktivieren. Sie können den Quellentyp für jede Tabelle anpassen, da eine Tabelle in der neuen Version der Geneva-Überwachung über mehrere Quellen verfügt.

- Das Geneva-Überwachungssystem verwendet mdsd (MDS-Daemon), der ein Überwachungs-Agent ist, und fluentd zum Sammeln von Protokollen mit einheitlicher Protokollierungsebene.

- Die selektive Protokollierung verwendet Skriptaktionen, um Tabellen und ihre Protokolltypen zu deaktivieren/aktivieren. Da keine neuen Ports geöffnet oder vorhandene Sicherheitseinstellungen geändert werden, gibt es keine Sicherheitsänderungen.

- Die Skriptaktion wird parallel auf allen angegebenen Knoten ausgeführt und ändert die Konfigurationsdateien zum Deaktivieren/Aktivieren von Tabellen und deren Protokolltypen.

Weitere Informationen finden Sie hier.

![]()

Fest

Log Analytics

Für Log Analytics, das in Azure HDInsight mit OMS-Version 13 integriert ist, muss ein Upgrade auf OMS-Version 14 durchgeführt werden, um die neuesten Sicherheitsupdates anzuwenden. Kunden, die eine ältere Version des Clusters mit OMS-Version 13 verwenden, müssen OMS-Version 14 installieren, um die Sicherheitsanforderungen zu erfüllen. (Informationen zum Überprüfen der aktuellen Version und Installieren von Version 14)

Ermitteln der aktuellen OMS-Version

- Stellen Sie mit SSH eine Verbindung mit dem Cluster her.

- Führen Sie in Ihrem SSH-Client den folgenden Befehl aus.

sudo /opt/omi/bin/ominiserver/ --version

Aktualisieren der OMS-Version von 13 auf 14

- Melden Sie sich beim Azure-Portal

- Wählen Sie in der Ressourcengruppe die HDInsight-Clusterressource aus.

- Wählen Sie Skriptaktionen aus.

- Wählen Sie im Bereich der Skriptaktion „Übermitteln“ den Skripttyp „Benutzerdefiniert“ aus.

- Fügen Sie den folgenden Link im URL-Feld des Bash-Skripts ein: https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh.

- Wählen Sie Knotentyp(en) aus.

- Klicken Sie auf Erstellen

Führen Sie die folgenden Schritte aus, um die erfolgreiche Installation des Patchs zu überprüfen:

Melden Sie sich per SSH bei dem Cluster an.

Führen Sie in Ihrem SSH-Client den folgenden Befehl aus.

sudo /opt/omi/bin/ominiserver/ --version

Weitere Fehlerbehebungen

- Die CLI des Yarn-Protokolls kann die Protokolle nicht abrufen, wenn

TFilebeschädigt oder leer ist. - Der Fehler mit ungültigen Dienstprinzipaldetails beim Abrufen des OAuth-Token von Azure Active Directory wurde behoben.

- Verbesserte Zuverlässigkeit der Clustererstellung, wenn mehr als 100 Workerknoten konfiguriert werden.

Open Source-Fehlerkorrekturen

TEZ-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| Tez Buildfehler: FileSaver.js nicht gefunden | TEZ-4411 |

Falsche FS-Ausnahme, wenn sich Warehouse und scratchdir auf unterschiedlichen FS befinden |

TEZ-4406 |

| TezUtils.createConfFromByteString bei einer Konfiguration mit mehr als 32 MB löst eine „com.google.protobuf.CodedInputStream“-Ausnahme aus. | TEZ-4142 |

| TezUtils::createByteStringFromConf sollte snappy anstelle von DeflaterOutputStream verwenden. | TEZ-4113 |

| Aktualisierung der protobuf-Abhängigkeit auf 3.x | TEZ-4363 |

Hive-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| Perf-Optimierungen in ORC-Splitgenerierung | HIVE-21457 |

| Vermeiden, eine Tabelle als ACID zu lesen, wenn der Tabellenname mit „delta“ beginnt, die Tabelle aber nicht transaktional ist und die BI-Splitstrategie verwendet wird | HIVE-22582 |

| Entfernen eines FS#exists-Aufrufs aus AcidUtils#getLogicalLength | HIVE-23533 |

| Vektorisierung von OrcAcidRowBatchReader.computeOffset und Bucketoptimierung | HIVE-17917 |

Bekannte Probleme

HDInsight ist mit Apache HIVE 3.1.2 kompatibel. Aufgrund eines Fehlers in dieser Version wird die Hive-Version in Hive-Oberflächen als 3.1.0 angezeigt. Es gibt jedoch keine Auswirkungen auf die Funktionalität.

Veröffentlichungsdatum: 03.06.2022

Dieses Release gilt für HDInsight 4.0. Das HDInsight-Release wird über mehrere Tage für alle Regionen verfügbar gemacht. Das hier angegebene Veröffentlichungsdatum entspricht dem Veröffentlichungsdatum in der ersten Region. Es kann sein, dass die unten angegebenen Änderungen in Ihrer Region erst einige Tage später verfügbar werden.

Highlights der Version

Der Hive Warehouse Connector (HWC) auf Spark v3.1.2

Mit dem Hive Warehouse Connector (HWC) können Sie die einzigartigen Features von Hive und Spark nutzen, um leistungsfähige Big Data-Anwendungen zu entwickeln. HWC wird derzeit nur für Spark v2.4 unterstützt. Mit diesem Feature wird ein geschäftlicher Mehrwert erzeugt, indem ACID-Transaktionen mit Hive-Tabellen mithilfe von Spark zugelassen werden. Dieses Feature ist für Kunden nützlich, die Hive und Spark in ihrem Datenbestand verwenden. Weitere Informationen finden Sie unter Apache Spark und Hive – Hive Warehouse Connector – Azure HDInsight | Microsoft-Dokumentation

Ambari

- Änderungen zur Verbesserung von Skalierung und Bereitstellung

- HDI Hive ist jetzt mit OSS-Version 3.1.2 kompatibel.

Die HDI Hive 3.1-Version wurde auf OSS Hive 3.1.2 aktualisiert. Diese Version enthält all Fixes und Features, die in der Open Source-Version 3.1.2 von Hive verfügbar sind.

Hinweis

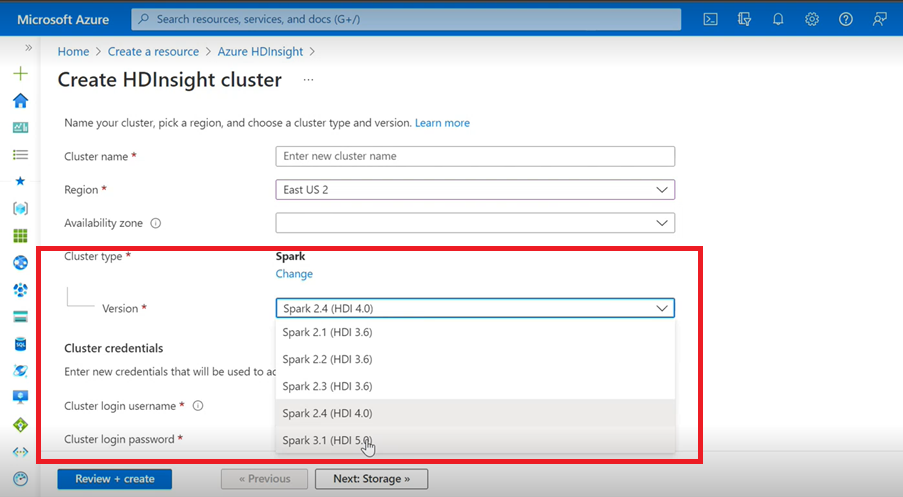

Funke

- Wenn Sie die Azure-Benutzeroberfläche zum Erstellen von Spark-Clustern für HDInsight verwenden, wird in der Dropdownliste eine weitere Version Spark 3.1 (HDI 5.0) zusammen mit den älteren Versionen angezeigt. Diese Version ist eine umbenannte Version von Spark 3.1. (HDI 4.0). Dies ist lediglich eine Änderung auf Benutzeroberflächenebene, die sich sonst gar nicht auf die vorhandenen Benutzer und Benutzer, die bereits die ARM-Vorlage verwenden, auswirkt.

Hinweis

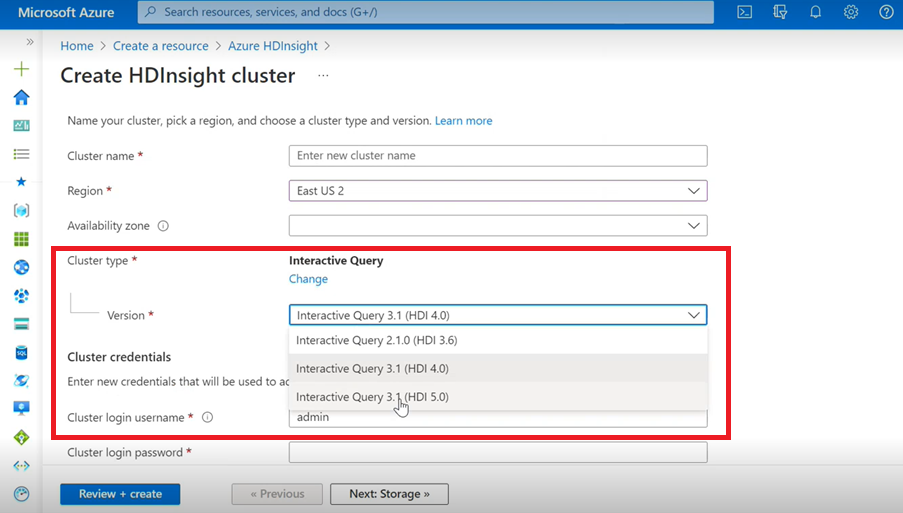

Interaktive Abfrage

- Wenn Sie einen Interactive Query-Cluster erstellen, wird in der Dropdownliste eine andere Version als Interactive Query 3.1 (HDI 5.0) angezeigt.

- Wenn Sie die Version „Spark 3.1“ zusammen mit Hive verwenden möchten, wofür ACID-Unterstützung erforderlich ist, müssen Sie diese Version „Interactive Query 3.1 (HDI 5.0)“ auswählen.

TEZ-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString bei einer Konfiguration mit mehr als 32 MB löst eine „com.google.protobuf.CodedInputStream“-Ausnahme aus. | TEZ-4142 |

| TezUtils createByteStringFromConf sollte snappy anstelle von DeflaterOutputStream verwenden. | TEZ-4113 |

HBase-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

TableSnapshotInputFormat sollte ReadType.STREAM zum Überprüfen von HFiles verwenden |

HBASE-26273 |

| Option hinzufügen, um scanMetrics in TableSnapshotInputFormat zu deaktivieren. | HBASE-26330 |

| Fix für ArrayIndexOutOfBoundsException bei Ausführung des Balancers | HBASE-22739 |

Hive-Fehlerbehebungen

| Fehlerbehebungen | Apache JIRA |

|---|---|

| NPE beim Einfügen von Daten mit „distribute by“-Klausel mit dynpart-Sortieroptimierung | HIVE-18284 |

| MSCK REPAIR-Befehl mit Partitionsfilterung schlägt beim Trennen von Partitionen fehl. | HIVE-23851 |

| Falsche Ausnahme ausgelöst, wenn Kapazität <= 0. | HIVE-25446 |

| Unterstützung für parallelen Ladevorgang für HastTables – Schnittstellen | HIVE-25583 |

| MultiDelimitSerDe standardmäßig in HiveServer2 einschließen | HIVE-20619 |

| Die Klassen glassfish.jersey und mssql-jdbc aus jdbc-standalone-JAR entfernen | HIVE-22134 |

| Nullzeigerausnahme beim Ausführen der Komprimierung gegen eine MM-Tabelle. | HIVE-21280 |

Große Hive-Abfrage über knox schlägt fehl mit fehlerhaftem Pipeschreibvorgang |

HIVE-22231 |

| Hinzufügen der Möglichkeit für den Benutzer zum Festlegen des Bindungsbenutzers | HIVE-21009 |

| Implementieren von UDF zum Interpretieren von Datum/Zeitstempel mithilfe der internen Darstellung und des Gregorianischen-Julianischen Hybridkalenders | HIVE-22241 |

| Beeline-Option zum Anzeigen/nicht Anzeigen des Ausführungsberichts. | HIVE-22204 |

| Tez: SplitGenerator versucht, nach Plandateien zu suchen, die es für Tez nicht gibt | HIVE-22169 |

Entfernen der kostspieligen Protokollierung aus dem hotpath des LLAP-Caches |

HIVE-22168 |

| UDF: FunctionRegistry synchronisiert auf org.apache.hadoop.hive.ql.udf.UDFType-Klasse. | HIVE-22161 |

| Erstellung des Abfrageweiterleitungs-Appenders verhindern, wenn die Eigenschaft auf „false“ festgelegt ist. | HIVE-22115 |

| Abfrageübergreifende Synchronisierung für die Partitionsauswertung entfernen. | HIVE-22106 |

| Einrichten des Scratchverzeichnisses für Hive während der Planung überspringen. | HIVE-21182 |

| Erstellen von Scratchverzeichnissen für tez überspringen, wenn RPC aktiviert ist. | HIVE-21171 |

Hive-UDFs auf Verwendung des Re2J-Regex-Moduls umschalten |

HIVE-19661 |

| Gruppierte Tabellen, die mit bucketing_version 1 für Hive 3 migriert wurden, verwenden bucketing_version 2 für Einfügungen. | HIVE-22429 |

| Bucketing: Bucketing, Version 1, partitioniert Daten fehlerhaft. | HIVE-21167 |

| ASF-Lizenzheader wird zu neu hinzugefügter Datei hinzugefügt. | HIVE-22498 |

| Verbesserungen des Schematools zur Unterstützung von mergeCatalog | HIVE-22498 |

| Hive mit TEZ UNION ALL und UDTF führt zu Datenverlust. | HIVE-21915 |

| Textdateien aufteilen, selbst wenn Kopf-/Fußzeile vorhanden ist. | HIVE-21924 |

| MultiDelimitSerDe gibt falsche Ergebnisse in der letzten Spalte zurück, wenn die geladene Datei mehr Spalten aufweist, als im Tabellenschema vorhanden sind. | HIVE-22360 |

| Externer LLAP-Client – Notwendigkeit zur Verringerung des Speicherbedarfs von LlapBaseInputFormat#getSplits(). | HIVE-22221 |

| Ein Spaltenname mit reserviertem Schlüsselwort ist nicht escapet, wenn eine Abfrage, die eine Verknüpfungen (join) mit einer Tabelle mit Maskenspalte enthält, erneut generiert wird (Zoltan Matyus über Zoltan Haindrich). | HIVE-22208 |

Verhindern des Herunterfahrens von LLAP bei AMReporter-bezogener RuntimeException |

HIVE-22113 |

| Der LLAP-Statusdiensttreiber kann sich bei einer falschen Yarn-App-ID aufhängen | HIVE-21866 |

| OperationManager.queryIdOperation bereinigt mehrere QueryIds nicht ordnungsgemäß. | HIVE-22275 |

| Das Herunterfahren eines Knoten-Managers blockiert den Neustart des LLAP-Diensts. | HIVE-22219 |

| Stack OverflowError beim Trennen vieler Partitionen | HIVE-15956 |

| Fehler bei der Zugriffsüberprüfung, wenn ein temporäres Verzeichnis entfernt wird. | HIVE-22273 |

| Beheben falscher Ergebnisse/ArrayOutOfBound-Ausnahme in linken äußeren Zuordnungsverknüpfungen bei bestimmten Grenzbedingungen. | HIVE-22120 |

| Entfernen des Distributionsverwaltungstags aus pom.xml. | HIVE-19667 |

| Die Analysezeit kann hoch sein, wenn tief geschachtelte Unterabfragen vorhanden sind. | HIVE-21980 |

Bei ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE'); werden Änderungen des TBL_TYPE-Attributs nicht wiedergegeben, wenn Groß-/Kleinschreibung nicht beachtet wird. |

HIVE-20057 |

JDBC: HiveConnection verdeckt log4j-Schnittstellen |

HIVE-18874 |

Aktualisieren von Repository-URLs in poms – Branch 3.1-Version |

HIVE-21786 |

DBInstall-Tests in Master und branch-3.1 fehlerhaft |

HIVE-21758 |

| Das Laden von Daten in eine Buckettabelle ignoriert Partitionsspezifikationen und lädt Daten in die Standardpartition. | HIVE-21564 |

| Abfragen mit Verknüpfungsbedingung mit Zeitstempel oder Zeitstempel mit lokalem Zeitzonenliteral lösen eine SemanticException aus. | HIVE-21613 |