Áttekintés az Azure Data Explorer adatbetöltéséről

Az adatbetöltés magában foglalja az adatok betöltését a fürt egy táblájába. Az Azure Data Explorer biztosítja az adatok érvényességét, szükség szerint átalakítja a formátumokat, és olyan műveleteket hajt végre, mint a sémaegyeztetés, a rendszerezés, az indexelés, a kódolás és a tömörítés. A betöltés után az adatok elérhetők a lekérdezéshez.

Az Azure Data Explorer egyszeri betöltést vagy folyamatos betöltési folyamat létrehozását kínálja streamelési vagy várólistás betöltési folyamat használatával. Annak megállapításához, hogy melyik a megfelelő az Ön számára, olvassa el az Egyszeri adatbetöltés és a Folyamatos adatbetöltés című témakört.

Megjegyzés

Az adatok a beállított adatmegőrzési szabályzatnak megfelelően tárolóban maradnak.

Egyszeri adatbetöltés

Az egyszeri betöltés hasznos az előzményadatok átviteléhez, a hiányzó adatok kitöltéséhez, valamint a prototípus-előkészítés és az adatelemzés kezdeti szakaszaihoz. Ez a megközelítés lehetővé teszi a gyors adatintegrációt anélkül, hogy folyamatos folyamatvállalásra van szükség.

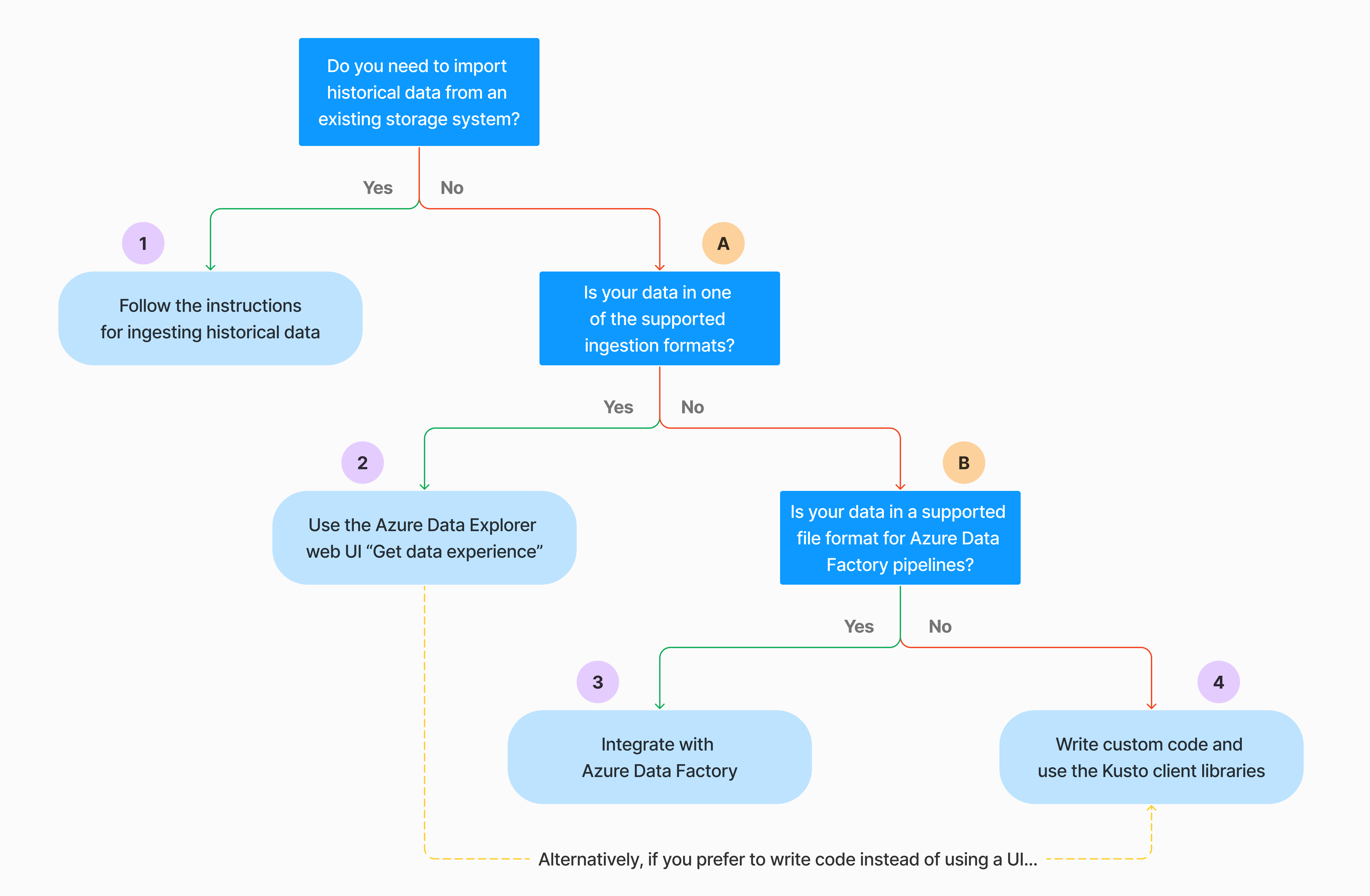

Az egyszeri adatbetöltés többféleképpen is elvégezhető. Használja a következő döntési fát a használati eset legmegfelelőbb lehetőségének meghatározásához:

További információkért tekintse meg a vonatkozó dokumentációt:

| Callout | Kapcsolódó dokumentáció |

|---|---|

|

A betöltéshez tekintse meg az Azure Data Explorer által támogatott adatformátumokat. |

|

Tekintse meg a Azure Data Factory folyamatokhoz támogatott fájlformátumokat. |

|

Ha meglévő tárolórendszerből szeretne adatokat importálni, olvassa el az Előzményadatok betöltése az Azure Data Explorer-ba című témakört. |

|

Az Azure Data Explorer webes felhasználói felületén adatokat kérhet le egy helyi fájlból, az Amazon S3-ból vagy az Azure Storage-ból. |

|

Az Azure Data Factory való integrációról az Adatok másolása az Azure Data Explorer Azure Data Factory használatával című témakörben olvashat. |

|

A Kusto-ügyfélkódtárak a C#, a Python, a Java, a JavaScript, a TypeScript és a Go számára érhetők el. Írhat kódot az adatok módosításához, majd a Kusto Ingest-kódtár használatával betöltheti az adatokat az Azure Data Explorer táblába. Az adatoknak a betöltés előtt a támogatott formátumok egyikében kell lenniük. |

Folyamatos adatbetöltés

A folyamatos betöltés olyan helyzetekben jelenik meg, amelyek azonnali betekintést igényelnek az élő adatokból. A folyamatos betöltés például hasznos a figyelési rendszerek, a napló- és eseményadatok, valamint a valós idejű elemzések esetében.

A folyamatos adatbetöltés magában foglalja egy betöltési folyamat beállítását streamelt vagy várólistás betöltéssel:

Streambetöltés: Ez a módszer közel valós idejű késést biztosít a táblánkénti kis adathalmazok esetében. Az adatok mikro kötegekben kerülnek be egy streamelési forrásból, először a sortárolóba kerülnek, majd átkerülnek az oszloptárolókba. További információ: Streambetöltés konfigurálása.

Várólista-betöltés: Ez a módszer a magas betöltési átviteli sebességre van optimalizálva. Az adatok kötegelése a betöltési tulajdonságok alapján történik, kis kötegekkel, majd egyesítve és a gyors lekérdezési eredményekhez optimalizálva. Alapértelmezés szerint a várólistán lévő értékek maximális száma 5 perc, 1000 elem vagy 1 GB teljes méret. Az üzenetsorba helyezett betöltési parancsok adatméretkorlátja 6 GB. Ez a módszer újrapróbálkozási mechanizmusokat használ az átmeneti hibák mérséklésére, és a "legalább egyszer" üzenetküldési szemantikát követi annak biztosítása érdekében, hogy ne vesszenek el üzenetek a folyamatban. Az üzenetsoros betöltéssel kapcsolatos további információkért lásd: Betöltési kötegelési szabályzat.

Megjegyzés

A legtöbb forgatókönyv esetében az üzenetsoros betöltés használatát javasoljuk, mivel ez a teljesítményesebb lehetőség.

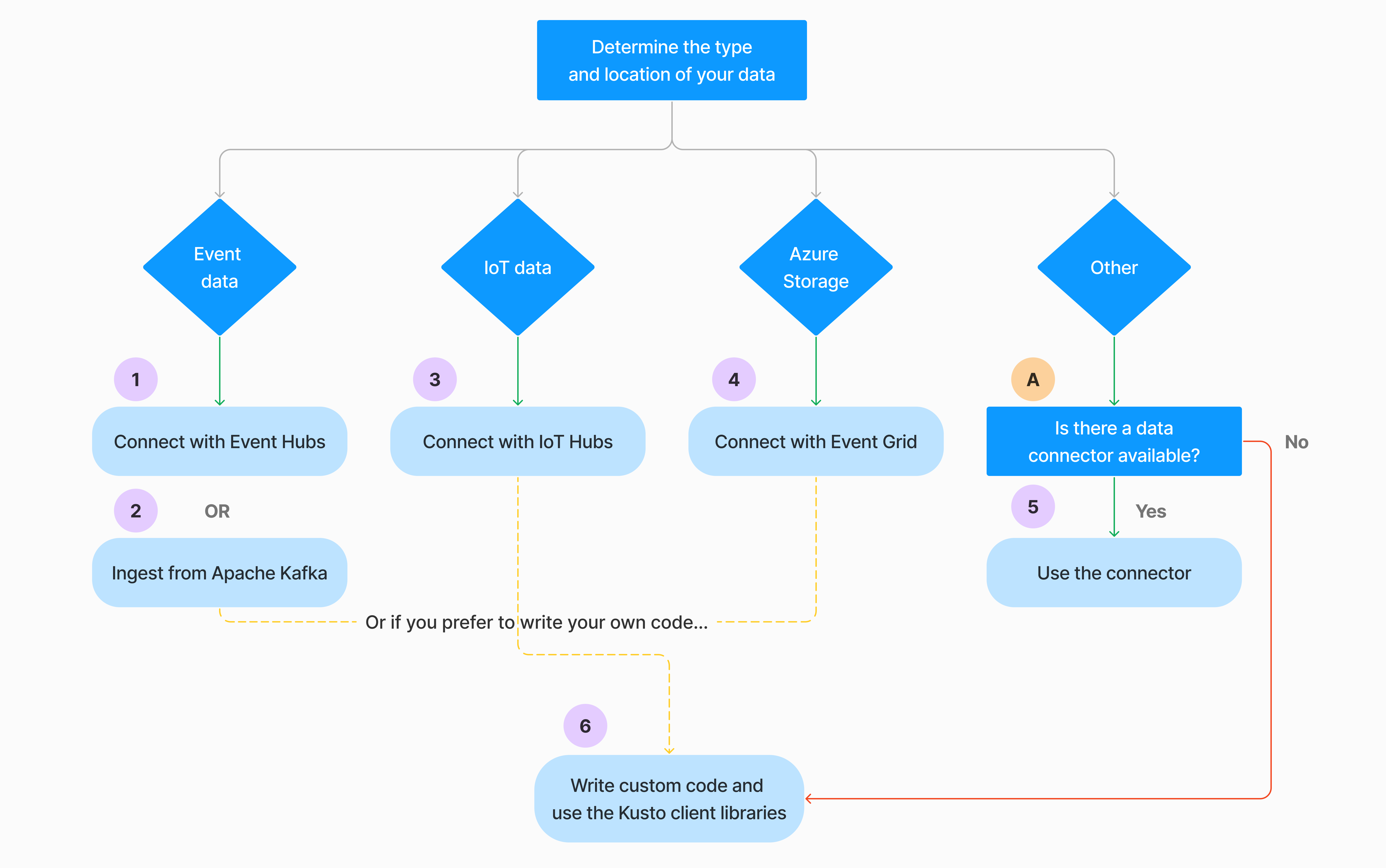

A folyamatos adatbetöltést többféleképpen is konfigurálhatja. Használja a következő döntési fát a használati eset legmegfelelőbb lehetőségének meghatározásához:

További információkért tekintse meg a vonatkozó dokumentációt:

| Callout | Kapcsolódó dokumentáció |

|---|---|

|

Az összekötők listáját lásd: Összekötők áttekintése. |

|

Event Hubs-adatkapcsolat létrehozása. Az Event Hubs-integráció olyan szolgáltatásokat nyújt, mint a szabályozás, az újrapróbálkozások, a monitorozás és a riasztások. |

|

Adatok betöltése az Apache Kafkából, amely egy elosztott streamelési platform, amely valós idejű streamelési adatfolyam-folyamatok létrehozására használható. |

|

Hozzon létre egy IoT Hub adatkapcsolatot. Az IoT Hubs-integráció olyan szolgáltatásokat nyújt, mint a szabályozás, az újrapróbálkozások, a monitorozás és a riasztások. |

|

Event Grid-adatkapcsolat létrehozása. Az Event Grid-integráció olyan szolgáltatásokat biztosít, mint a szabályozás, az újrapróbálkozás, a monitorozás és a riasztások. |

|

Tekintse meg a megfelelő összekötőre vonatkozó útmutatást, például az Apache Sparkot, az Apache Kafkát, az Azure Cosmos DB-t, a Fluent Bitet, a Logstashot, az Open Telemetryt, a Power Automate-t, a Splunkot és egyebeket. További információ: Összekötők áttekintése. |

|

A Kusto-ügyfélkódtárak a C#, a Python, a Java, a JavaScript, a TypeScript és a Go számára érhetők el. Írhat kódot az adatok módosításához, majd a Kusto Ingest-kódtár használatával betöltheti az adatokat az Azure Data Explorer táblába. Az adatoknak a betöltés előtt a támogatott formátumok egyikében kell lenniük. |

Megjegyzés

A streamelési betöltés nem támogatott minden betöltési módszerhez. A támogatási részletekért tekintse meg az adott betöltési módszer dokumentációját.

Közvetlen betöltés felügyeleti parancsokkal

Az Azure Data Explorer a következő betöltési felügyeleti parancsokat kínálja, amelyek az adatkezelési szolgáltatás használata helyett közvetlenül a fürtbe töltik be az adatokat. Ezeket csak feltárásra és prototípus-készítésre szabad használni, éles vagy nagy volumenű forgatókönyvekben nem.

- Beágyazott betöltés: A .ingest beágyazott parancs a parancs szövegének részét képező adatokat tartalmazza. Ez a módszer improvizált tesztelési célokra szolgál.

- Betöltés a lekérdezésből: A .set, .append, .set-or-append vagy .set-or-replace parancs közvetetten megadja a lekérdezés vagy parancs eredményeként betöltendő adatokat.

- Betöltés a tárolóból: A .ing into paranccsal az adatok külső tárolóból( például Azure Blob Storage) lesznek betöltve a fürt számára, és a parancsra mutatnak.

Betöltési módszerek összehasonlítása

Az alábbi táblázat a fő betöltési módszereket hasonlítja össze:

| Betöltési név | Adattípus | Maximális fájlméret | Streamelés, üzenetsorba rendezve, közvetlen | A leggyakoribb forgatókönyvek | Megfontolandó szempontok |

|---|---|---|---|---|---|

| Apache Spark-összekötő | A Spark-környezet által támogatott összes formátum | Korlátlan | Várólistán | Meglévő folyamat, a Spark-on a betöltés előtt történő előfeldolgozás, a Spark-környezet által támogatott különböző forrásokból származó biztonságos (Spark-) streamelési folyamat gyors létrehozása. | Fontolja meg a Spark-fürt költségeit. Kötegelt írás esetén hasonlítsa össze az Event Grid azure Data Explorer adatkapcsolatát. Spark-streamelés esetén hasonlítsa össze az eseményközpont adatkapcsolatát. |

| Azure Data Factory (ADF) | Támogatott adatformátumok | Korlátlan. Örökli az ADF-korlátozásokat. | Várólistán vagy ADF-eseményindítónként | Támogatja a nem támogatott formátumokat, például az Excelt és az XML-t, és nagy méretű fájlokat másolhat több mint 90 forrásból, a teljesítményről a felhőbe | Ez a módszer viszonylag több időt vesz igénybe az adatok betöltéséig. Az ADF feltölti az összes adatot a memóriába, majd megkezdi a betöltést. |

| Event Grid | Támogatott adatformátumok | 1 GB tömörítetlen | Várólistán | Folyamatos betöltés az Azure Storage-ból, külső adatok az Azure Storage-ban | A betöltés a blob átnevezésével vagy a bloblétrehozási műveletekkel aktiválható |

| Event Hub | Támogatott adatformátumok | N/A | Várólista, streamelés | Üzenetek, események | |

| Adatok lekérése | *SV, JSON | 1 GB tömörítetlen | Várólistára helyezett vagy közvetlen betöltés | Egyszeri, táblaséma létrehozása, a folyamatos betöltés definíciója az Event Griddel, tömeges betöltés tárolóval (legfeljebb 5000 blob, nincs korlát az előzménybetöltés használatakor) | |

| IoT Hub | Támogatott adatformátumok | N/A | Várólista, streamelés | IoT-üzenetek, IoT-események, IoT-tulajdonságok | |

| Kafka-összekötő | Avro, ApacheAvro, JSON, CSV, Parquet és ORC | Korlátlan. Java-korlátozásokat örököl. | Várólista, streamelés | Meglévő folyamat, nagy mennyiségű használat a forrásból. | A preferenciát több gyártó vagy fogyasztói szolgáltatás meglévő használata vagy a szolgáltatáskezelés kívánt szintje határozza meg. |

| Kusto-ügyfélkódtárak | Támogatott adatformátumok | 1 GB tömörítetlen | Várólista, streamelés, közvetlen | Saját kód írása a szervezeti igényeknek megfelelően | A programozott betöltés a betöltési költségek (COG-k) csökkentésére van optimalizálva a tárolási tranzakciók minimalizálásával a betöltési folyamat során és után. |

| LightIngest | Támogatott adatformátumok | 1 GB tömörítetlen | Várólistára helyezett vagy közvetlen betöltés | Adatmigrálás, előzményadatok módosított betöltési időbélyegekkel, tömeges betöltés | Kis- és nagybetűk megkülönböztetése |

| Logic Apps | Támogatott adatformátumok | 1 GB tömörítetlen | Várólistán | Folyamatok automatizálására szolgál | |

| LogStash | JSON | Korlátlan. Java-korlátozásokat örököl. | Várólistán | A meglévő folyamat a Logstash kiforrott, nyílt forráskód természetét használja a bemenet(ek)ből származó nagy mennyiségű felhasználáshoz. | A preferenciát több gyártó vagy fogyasztói szolgáltatás meglévő használata vagy a szolgáltatáskezelés kívánt szintje határozza meg. |

| Power Automate | Támogatott adatformátumok | 1 GB tömörítetlen | Várólistán | Betöltési parancsok a folyamat részeként. Folyamatok automatizálására szolgál. |

További információ a többi összekötőről: Összekötők áttekintése.

Engedélyek

Az alábbi lista a különböző betöltési forgatókönyvekhez szükséges engedélyeket ismerteti:

- Új tábla létrehozásához legalább adatbázis-felhasználói engedély szükséges.

- Az adatok meglévő táblába való betöltéséhez a séma módosítása nélkül legalább adatbázis-betöltési engedélyekre van szükség.

- Egy meglévő tábla sémájának módosításához legalább Table Rendszergazda vagy Database Rendszergazda engedély szükséges.

További információ: Kusto szerepköralapú hozzáférés-vezérlés.

A betöltési folyamat

Az alábbi lépések az általános betöltési folyamatot ismertetik:

Kötegelési szabályzat beállítása (nem kötelező): Az adatok kötegelése a betöltési kötegelési szabályzat alapján történik. Útmutatásért lásd: Optimalizálás az átviteli sebességhez.

Adatmegőrzési szabályzat beállítása (nem kötelező):Ha az adatbázis-adatmegőrzési szabályzat nem felel meg az igényeinek, felülbírálja azt a tábla szintjén. További információ: Adatmegőrzési szabályzat.

Tábla létrehozása: Ha az Adatok lekérése felületet használja, létrehozhat egy táblát a betöltési folyamat részeként. Ellenkező esetben hozzon létre egy táblát a betöltés előtt az Azure Data Explorer webes felhasználói felületén vagy a .create table paranccsal.

Sémaleképezés létrehozása: A sémaleképezések segítenek a forrásadatmezők céltáblaoszlopokhoz kötésében. A különböző típusú leképezések támogatottak, beleértve a sororientált formátumokat, például a CSV-t, a JSON-t és az AVRO-t, valamint az oszloporientált formátumokat, például a Parquetet. A legtöbb metódusban a leképezések előre is létrehozhatóak a táblán.

Frissítési szabályzat beállítása (nem kötelező): Bizonyos adatformátumok, például a Parquet, a JSON és az Avro egyszerű betöltési idejű átalakításokat tesznek lehetővé. A betöltés során történő bonyolultabb feldolgozáshoz használja a frissítési szabályzatot. Ez a szabályzat automatikusan végrehajtja a kinyeréseket és átalakításokat az eredeti táblában betöltött adatokon, majd egy vagy több céltáblába betölti a módosított adatokat.

Adatok betöltése: Az adatok beolvasásához használja az előnyben részesített betöltési eszközt, összekötőt vagy metódust.