Projektowanie rozwiązania do analizy biznesowej w przedsiębiorstwie przy użyciu usługi Azure Synapse Analytics

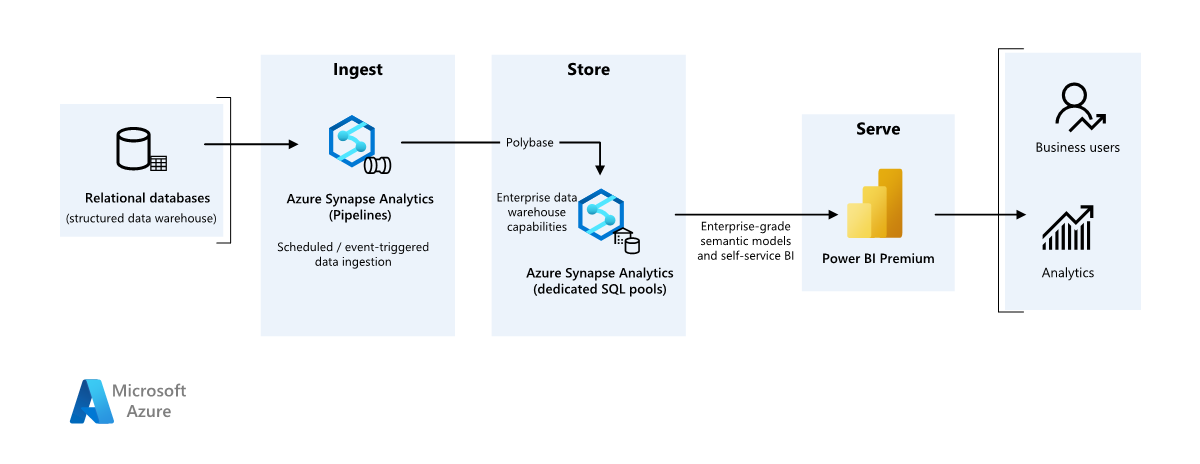

W tym artykule opisano sposób przesyłania danych z lokalnego magazynu danych do środowiska w chmurze, a następnie używania modelu analizy biznesowej (BI) do obsługi danych. Możesz użyć tego podejścia jako celu końcowego lub pierwszego kroku w kierunku pełnej modernizacji z składnikami opartymi na chmurze.

Te wskazówki opierają się na kompleksowej wersji scenariusza usługi Azure Synapse Analytics. Ten proces używa potoków usługi Azure Synapse Analytics do pozyskiwania danych z bazy danych SQL do pul SQL. Następnie wykonuje transformację danych na potrzeby analizy. Ten artykuł koncentruje się na potokach usługi Azure Synapse Analytics, ale do wykonywania tych zadań można również użyć potoków usługi Azure Data Factory lub potoków usługi Fabric Data Factory.

Kiedy należy używać tej architektury

Możesz użyć różnych metod, aby spełnić wymagania biznesowe dotyczące analizy biznesowej w przedsiębiorstwie. Różne aspekty definiują wymagania biznesowe, takie jak bieżące inwestycje technologiczne, umiejętności człowieka, oś czasu modernizacji, przyszłe cele i to, czy masz preferencje dotyczące platformy jako usługi (PaaS) lub oprogramowania jako usługi (SaaS).

Rozważ następujące podejścia projektowe:

Sieć szkieletowa i usługa Azure Databricks dla klientów, którzy mają istniejące inwestycje w usługę Azure Databricks i Power BI, i chcą zmodernizować usługę Fabric

Analiza biznesowa przedsiębiorstwa dla małych i średnich firm korzystających z ekosystemu usługi Azure SQL i sieci szkieletowej

Magazynowanie danych w całości w sieci szkieletowej dla klientów, którzy preferują usługę SaaS

Architektura w tym artykule zakłada, że używasz magazynu danych usługi Azure Synapse Analytics jako trwałej warstwy semantycznego modelu przedsiębiorstwa i używasz usługi Power BI do analizy biznesowej. To podejście PaaS ma elastyczność w zakresie obsługi różnych wymagań biznesowych i preferencji.

Architektura

Pobierz plik programu Visio z tą architekturą.

Przepływ pracy

Źródło danych

- Baza danych programu SQL Server na platformie Azure zawiera dane źródłowe. Aby zasymulować środowisko lokalne, skrypty wdrażania dla tego scenariusza umożliwiają skonfigurowanie bazy danych Azure SQL Database. Przykładowa baza danych AdventureWorks jest używana jako schemat danych źródłowych i przykładowe dane. Aby uzyskać więcej informacji, zobacz Kopiowanie i przekształcanie danych do i z programu SQL Server.

Pozyskiwanie i przechowywanie danych

Usługa Azure Data Lake Storage to tymczasowy obszar przejściowy podczas pozyskiwania danych. Za pomocą technologii PolyBase można kopiować dane do dedykowanej puli SQL usługi Azure Synapse Analytics.

Azure Synapse Analytics to rozproszony system, który wykonuje analizę dużych danych. Obsługuje ona masowe przetwarzanie równoległe, dzięki czemu może uruchamiać analizę o wysokiej wydajności. Dedykowana pula SQL usługi Azure Synapse Analytics jest celem ciągłego pozyskiwania ze środowiska lokalnego. Pula SQL może obsługiwać dane w usłudze Power BI za pośrednictwem trybu DirectQuery i wykonywać dalsze przetwarzanie.

Potoki usługi Azure Synapse Analytics organizują pozyskiwanie i przekształcanie danych w obszarze roboczym usługi Azure Synapse Analytics.

Analiza i raportowanie

- Podejście do modelowania danych w tym scenariuszu łączy model przedsiębiorstwa i semantyczny model analizy biznesowej. Dedykowana pula SQL usługi Azure Synapse Analytics zawiera model przedsiębiorstwa. Pojemność usługi Power BI Premium F64 zawiera model semantyczny analizy biznesowej. Usługa Power BI uzyskuje dostęp do danych za pośrednictwem trybu DirectQuery.

Składniki

W tym scenariuszu są używane następujące składniki:

Usługa Azure SQL Database to hostowany na platformie Azure serwer PaaS SQL. Ta architektura używa usługi SQL Database do zademonstrowania przepływu danych na potrzeby scenariusza migracji.

Usługa Data Lake Storage udostępnia elastyczny magazyn w chmurze dla danych bez struktury, które są używane do utrwalania wyników migracji pośredniej.

Azure Synapse Analytics to usługa analizy przedsiębiorstwa służąca do magazynowania danych i systemów danych big data. Usługa Azure Synapse Analytics służy jako główny magazyn obliczeniowy i trwały w semantycznym modelowaniu i obsłudze przedsiębiorstwa.

Power BI Premium to narzędzie do analizy biznesowej, które przedstawia i wizualizuje dane w tym scenariuszu.

Microsoft Entra ID to wielochmurowy pakiet rozwiązań tożsamości i sieci, który obsługuje przepływ uwierzytelniania i autoryzacji.

Uproszczona architektura

Szczegóły scenariusza

W tym scenariuszu organizacja ma bazę danych SQL, która zawiera duży lokalny magazyn danych. Organizacja chce używać usługi Azure Synapse Analytics do przeprowadzania analizy, a następnie dostarczać te szczegółowe informacje za pośrednictwem usługi Power BI do użytkowników i analiz.

Uwierzytelnianie

Identyfikator Entra firmy Microsoft uwierzytelnia użytkowników, którzy łączą się z pulpitami nawigacyjnymi i aplikacjami usługi Power BI. Logowanie jednokrotne łączy użytkowników ze źródłem danych w aprowizowanej puli usługi Azure Synapse Analytics. Autoryzacja występuje w źródle.

Ładowanie przyrostowe

Po uruchomieniu zautomatyzowanego procesu wyodrębniania, przekształcania, ładowania lub wyodrębniania, ładowania, przekształcania (ELT) należy załadować tylko dane, które uległy zmianie od poprzedniego uruchomienia. Ten proces jest nazywany obciążeniem przyrostowym. Z drugiej strony pełne obciążenie ładuje wszystkie dane. Aby wykonać obciążenie przyrostowe, określ sposób identyfikowania zmienionych danych. Można użyć podejścia o wysokiej wartości znaku wodnego , która śledzi najnowszą wartość kolumny daty i godziny lub unikatowej kolumny całkowitej w tabeli źródłowej.

Tabele czasowe można używać w programie SQL Server. Tabele czasowe to tabele w wersji systemowej, które przechowują historię zmian danych. Aparat bazy danych automatycznie rejestruje historię każdej zmiany w oddzielnej tabeli historii. Aby wykonać zapytanie dotyczące danych historycznych, możesz dodać klauzulę FOR SYSTEM_TIME do zapytania. Aparat bazy danych wykonuje zapytanie względem tabeli historii, ale jest niewidoczny dla aplikacji.

Tabele czasowe obsługują dane wymiarów, które mogą się zmieniać w czasie. Tabele faktów zwykle reprezentują niezmienną transakcję, taką jak sprzedaż, w takim przypadku utrzymywanie historii wersji systemu nie ma sensu. Zamiast tego transakcje zwykle mają kolumnę reprezentującą datę transakcji. Kolumna może służyć jako wartość limitu. Na przykład w magazynie SalesLT.* danych AdventureWorks tabele mają LastModified pole.

Oto ogólny przepływ potoku ELT:

Dla każdej tabeli w źródłowej bazie danych śledź czas odcięcia po uruchomieniu ostatniego zadania ELT. Zapisz te informacje w magazynie danych. W początkowej konfiguracji wszystkie czasy są ustawione na

1-1-1900.W kroku eksportowania danych czas odcięcia jest przekazywany jako parametr do zestawu procedur składowanych w źródłowej bazie danych. Te procedury składowane wysyłają zapytania do wszystkich rekordów, które są zmieniane lub tworzone po czasie odcięcia. W przypadku wszystkich tabel w przykładzie można użyć kolumny

ModifiedDate.Po zakończeniu migracji danych zaktualizuj tabelę, która przechowuje czasy odcięcia.

Potok danych

W tym scenariuszu przykładowa baza danych AdventureWorks jest używana jako źródło danych. Wzorzec ładowania przyrostowego danych gwarantuje, że tylko dane zmodyfikowane lub dodane po załadowaniu ostatniego uruchomienia potoku.

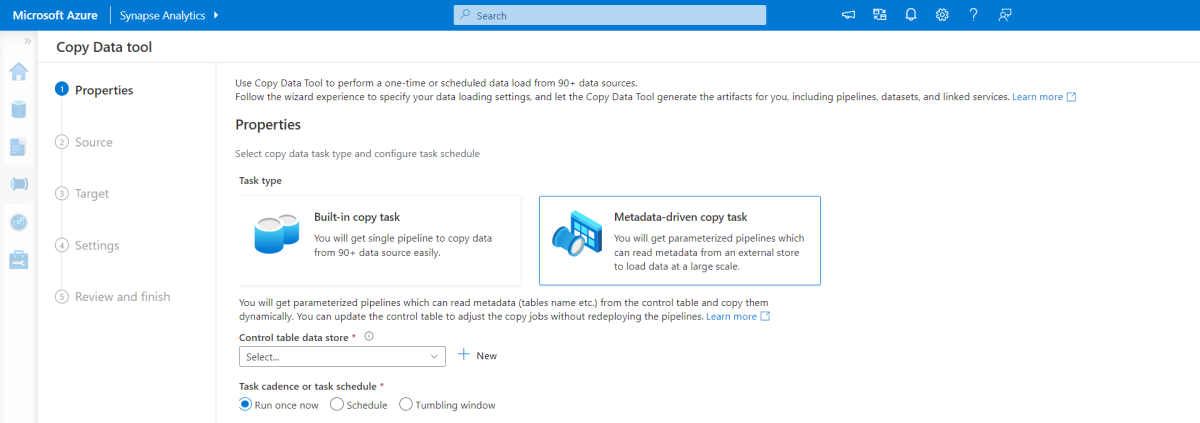

Narzędzie do kopiowania opartego na metadanych

Wbudowane narzędzie do kopiowania metadanych w potokach usługi Azure Synapse Analytics przyrostowo ładuje wszystkie tabele zawarte w relacyjnej bazie danych.

Użyj interfejsu kreatora, aby połączyć narzędzie do kopiowania danych ze źródłową bazą danych.

Po nawiązaniu połączenia skonfiguruj ładowanie przyrostowe lub pełne ładowanie dla każdej tabeli.

Narzędzie do kopiowania danych tworzy potoki i skrypty SQL potrzebne do wygenerowania tabeli sterowania. Ta tabela przechowuje dane, takie jak wysoka wartość limitu lub kolumna dla każdej tabeli, dla procesu ładowania przyrostowego.

Po uruchomieniu tych skryptów potok ładuje wszystkie tabele magazynu danych źródłowych do dedykowanej puli usługi Azure Synapse Analytics.

Zanim narzędzie ładuje dane, tworzy trzy potoki w celu iterowania tabel w bazie danych.

Potoki wykonują następujące zadania:

Zlicz liczbę obiektów, takich jak tabele, które mają być kopiowane w przebiegu potoku.

Iterowanie każdego obiektu do załadowania lub skopiowania.

Po wykonaniu iterację potoku nad każdym obiektem wykonuje następujące zadania:

Sprawdza, czy wymagane jest obciążenie różnicowe. W przeciwnym razie potok kończy normalne pełne obciążenie.

Pobiera wysoką wartość limitu z tabeli kontrolnej.

Kopiuje dane z tabel źródłowych do konta przejściowego w usłudze Data Lake Storage.

Ładuje dane do dedykowanej puli SQL za pośrednictwem wybranej metody kopiowania, takiej jak polyBase lub kopiuj polecenia.

Aktualizuje wysoką wartość limitu w tabeli kontrolnej.

Ładowanie danych do puli SQL usługi Azure Synapse Analytics

Działanie kopiowania kopiuje dane z bazy danych SQL do puli SQL usługi Azure Synapse Analytics. Ta przykładowa baza danych SQL znajduje się na platformie Azure, więc używa środowiska Azure Integration Runtime do odczytywania danych z bazy danych SQL Database i zapisywania danych w określonym środowisku przejściowym.

Instrukcja copy następnie ładuje dane ze środowiska przejściowego do dedykowanej puli usługi Azure Synapse Analytics.

Korzystanie z potoków usługi Azure Synapse Analytics

Potoki w usłudze Azure Synapse Analytics definiują uporządkowany zestaw działań w celu ukończenia wzorca obciążenia przyrostowego. Wyzwalacze ręczne lub automatyczne uruchamiają potok.

Przekształcanie danych

Przykładowa baza danych w tej architekturze referencyjnej jest mała, więc zreplikowane tabele, które nie mają żadnych partycji, są tworzone. W przypadku obciążeń produkcyjnych tabele rozproszone mogą zwiększyć wydajność zapytań. Aby uzyskać więcej informacji, zobacz Wskazówki dotyczące projektowania tabel rozproszonych w usłudze Azure Synapse Analytics. Przykładowe skrypty uruchamiają zapytania za pośrednictwem statycznej klasy zasobów.

W środowisku produkcyjnym rozważ utworzenie tabel przejściowych, które mają dystrybucję okrężną. Następnie przekształć i przenieść dane do tabel produkcyjnych, które mają klastrowane indeksy magazynu kolumn, co zapewnia najlepszą ogólną wydajność zapytań. Indeksy magazynu kolumn są zoptymalizowane pod kątem zapytań, które skanują wiele rekordów.

Indeksy magazynu kolumn nie działają optymalnie dla pojedynczych odnośników ani wyszukiwania w górę jednego wiersza. Jeśli musisz wykonywać częste pojedyncze wyszukiwania, możesz dodać indeks nieklastrowany do tabeli, co zwiększa szybkość. Jednak pojedyncze wyszukiwania są zwykle mniej powszechne w scenariuszach magazynu danych niż obciążenia przetwarzania transakcji online. Aby uzyskać więcej informacji, zobacz Indeksowanie tabel w usłudze Azure Synapse Analytics.

Uwaga

Tabele klastrowanego magazynu kolumn nie obsługują varchar(max)typów danych , nvarchar(max)ani varbinary(max) . Jeśli używasz tych typów danych, rozważ stos lub indeks klastrowany. Możesz również rozważyć umieszczenie tych kolumn w oddzielnej tabeli.

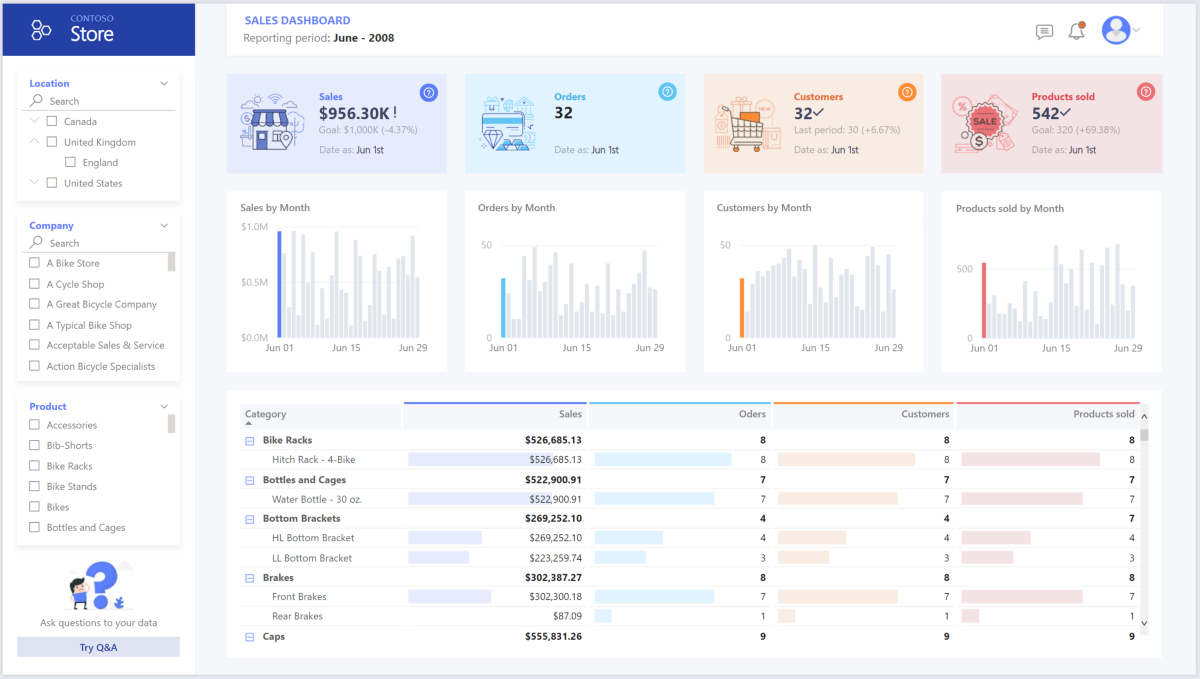

Uzyskiwanie dostępu, modelowanie i wizualizowanie danych przy użyciu usługi Power BI Premium

Usługa Power BI Premium obsługuje kilka opcji łączenia się ze źródłami danych na platformie Azure. Pule aprowizowane w usłudze Azure Synapse Analytics umożliwiają wykonywanie następujących zadań:

- Importowanie: dane są importowane do modelu usługi Power BI.

- Zapytanie bezpośrednie: dane są pobierane bezpośrednio z magazynu relacyjnego.

- Model złożony: połącz importowanie dla niektórych tabel i zapytania bezpośredniego dla innych.

W tym scenariuszu jest używany pulpit nawigacyjny trybu DirectQuery, ponieważ ma niewielką ilość danych i niską złożoność modelu. Zapytanie bezpośrednie deleguje zapytanie do zaawansowanego aparatu obliczeniowego poniżej i korzysta z rozbudowanych funkcji zabezpieczeń w źródle. Zapytanie bezpośrednie gwarantuje, że wyniki są zawsze zgodne z najnowszymi danymi źródłowymi.

Tryb importu zapewnia najszybszy czas odpowiedzi na zapytanie. Rozważ tryb importu, jeśli:

- Model mieści się w całości w pamięci usługi Power BI.

- Opóźnienie danych między odświeżeniami jest akceptowalne.

- Wymagane są złożone przekształcenia między systemem źródłowym a ostatecznym modelem.

W takim przypadku użytkownicy końcowi chcą mieć pełny dostęp do najnowszych danych bez opóźnień w odświeżaniu usługi Power BI i chcą wszystkich danych historycznych, które przekraczają pojemność zestawu danych usługi Power BI. Zestaw danych usługi Power BI może obsłużyć 25–400 GB, w zależności od rozmiaru pojemności. Model danych w dedykowanej puli SQL znajduje się już w schemacie gwiazdy i nie wymaga przekształcenia, dlatego zapytanie bezpośrednie jest odpowiednim wyborem.

Usługa Power BI Premium umożliwia zarządzanie dużymi modelami, raportami podzielonymi na strony i potokami wdrażania. Skorzystaj z wbudowanego punktu końcowego usług Azure Analysis Services. Możesz również mieć dedykowaną pojemność z unikatową propozycją wartości.

Gdy model analizy biznesowej rośnie lub zwiększa się złożoność pulpitu nawigacyjnego, możesz przełączyć się na modele złożone i zaimportować części tabel odnośników za pośrednictwem tabel hybrydowych i zaimportować wstępnie zagregowane dane. Buforowanie zapytań w usłudze Power BI można włączyć dla zaimportowanych zestawów danych i użyć podwójnych tabel dla właściwości trybu przechowywania.

W modelu złożonym zestawy danych pełnią rolę wirtualnej warstwy przekazywania. Gdy użytkownicy wchodzą w interakcje z wizualizacjami, usługa Power BI generuje zapytania SQL do pul SQL usługi Azure Synapse Analytics. Usługa Power BI określa, czy używać magazynu w pamięci, czy w trybie DirectQuery na podstawie wydajności. Aparat decyduje, kiedy przełączyć się z pamięci do trybu DirectQuery i wypchnie logikę do puli SQL usługi Azure Synapse Analytics. W zależności od kontekstu tabel zapytań mogą pełnić rolę buforowanych (importowanych) lub niebuforowanych modeli złożonych. Możesz wybrać tabelę do buforowania w pamięci, połączyć dane z co najmniej jednego źródła trybu DirectQuery lub połączyć dane źródła DirectQuery i zaimportowane dane.

W przypadku korzystania z trybu DirectQuery z aprowizowaną pulą usługi Azure Synapse Analytics:

Buforowanie zestawu wyników usługi Azure Synapse Analytics umożliwia buforowanie wyników zapytań w bazie danych użytkownika w celu powtarzalnego użycia. Takie podejście zwiększa wydajność zapytań do milisekund i zmniejsza użycie zasobów obliczeniowych. Zapytania korzystające z buforowanych zestawów wyników nie korzystają z żadnych miejsc współbieżności w usłudze Azure Synapse Analytics, więc nie są one liczone względem istniejących limitów współbieżności.

Użyj zmaterializowanych widoków usługi Azure Synapse Analytics, aby wstępnie skompilować, przechowywać i obsługiwać dane, takie jak tabela. Zapytania korzystające ze wszystkich danych lub podzestawu danych w zmaterializowanych widokach mogą osiągnąć szybszą wydajność bez konieczności bezpośredniego odwołowania się do zdefiniowanego zmaterializowanego widoku do użycia.

Kwestie wymagające rozważenia

Te zagadnienia obejmują implementację filarów platformy Azure Well-Architected Framework, która jest zestawem wytycznych, których można użyć do poprawy jakości obciążenia. Aby uzyskać więcej informacji, zobacz Well-Architected Framework.

Zabezpieczenia

Zabezpieczenia zapewniają ochronę przed celowymi atakami i nieprawidłowym użyciem cennych danych i systemów. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu dotyczącazabezpieczeń.

Modernizacja chmury wprowadza obawy dotyczące zabezpieczeń, takie jak naruszenia danych, infekcje złośliwego oprogramowania i wstrzyknięcie złośliwego kodu. Potrzebujesz dostawcy usług lub dostawcy usług w chmurze, które może rozwiązać Twoje problemy, ponieważ nieodpowiednie środki zabezpieczeń mogą powodować poważne problemy.

Ten scenariusz dotyczy najbardziej wymagających problemów z zabezpieczeniami przy użyciu kombinacji warstwowych mechanizmów kontroli zabezpieczeń: kontroli sieci, tożsamości, prywatności i autoryzacji. Aprowizowana pula usługi Azure Synapse Analytics przechowuje większość danych. Usługa Power BI uzyskuje dostęp do danych za pośrednictwem trybu DirectQuery za pośrednictwem logowania jednokrotnego. Do uwierzytelniania można użyć identyfikatora Entra firmy Microsoft. Istnieją również obszerne mechanizmy kontroli zabezpieczeń na potrzeby autoryzacji danych w aprowizowanych pulach.

Oto niektóre typowe pytania dotyczące zabezpieczeń:

Zdefiniuj, kto może zobaczyć, jakie dane.

- Upewnij się, że dane są zgodne z wytycznymi federalnymi, lokalnymi i firmowymi, aby ograniczyć ryzyko naruszenia zabezpieczeń danych. Usługa Azure Synapse Analytics zapewnia wiele funkcji ochrony danych w celu zapewnienia zgodności.

Ustal, jak zweryfikować tożsamość użytkownika.

- Użyj usługi Azure Synapse Analytics, aby kontrolować, kto może uzyskiwać dostęp do danych za pośrednictwem kontroli dostępu i uwierzytelniania.

Wybierz technologię zabezpieczeń sieci, aby chronić integralność, poufność i dostęp do sieci i danych.

- Zabezpieczanie usługi Azure Synapse Analytics przy użyciu opcji zabezpieczeń sieci .

Wybierz narzędzia do wykrywania i powiadamiania o zagrożeniach.

- Korzystanie z funkcji wykrywania zagrożeń usługi Azure Synapse Analytics, takich jak inspekcja SQL, wykrywanie zagrożeń SQL i ocena luk w zabezpieczeniach w celu przeprowadzania inspekcji, ochrony i monitorowania baz danych.

Określ, jak chronić dane na koncie magazynu.

- Użyj kont usługi Azure Storage dla obciążeń, które wymagają szybkich i spójnych czasów odpowiedzi lub mają dużą liczbę operacji wejścia/wyjścia na sekundę. Konta magazynu mogą przechowywać wszystkie obiekty danych i mieć kilka opcji zabezpieczeń konta magazynu.

Optymalizacja kosztów

Optymalizacja kosztów koncentruje się na sposobach zmniejszenia niepotrzebnych wydatków i poprawy wydajności operacyjnej. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu dlaoptymalizacji kosztów.

Ta sekcja zawiera informacje o cenach różnych usług związanych z tym rozwiązaniem oraz zawiera informacje o decyzjach podjętych w tym scenariuszu za pomocą przykładowego zestawu danych. Użyj tej konfiguracji początkowej w kalkulatorze cen platformy Azure i dostosuj ją do swojego scenariusza.

Azure Synapse Analytics

Usługa Azure Synapse Analytics to architektura bezserwerowa, której można użyć do niezależnego skalowania poziomów zasobów obliczeniowych i magazynu. Zasoby obliczeniowe generują koszty na podstawie użycia. Możesz skalować lub wstrzymać te zasoby na żądanie. Zasoby magazynu generują koszty na terabajt, więc koszty rosną w miarę pozyskiwania danych.

Potoki usługi Azure Synapse Analytics

Trzy główne składniki wpływają na cenę potoku:

- Działania potoku danych i godziny środowiska Integration Runtime

- Rozmiar i implementacja klastra przepływów danych

- opłat za operacje

Aby uzyskać szczegółowe informacje o cenach, zobacz kartę Integracja danych w cenniku usługi Azure Synapse Analytics.

Cena różni się w zależności od składników lub działań, częstotliwości i liczby jednostek środowiska Integration Runtime.

W przypadku przykładowego zestawu danych, który używa standardowego środowiska Integration Runtime hostowanego na platformie Azure, działanie kopiowania danych służy jako rdzeń potoku. Jest uruchamiany zgodnie z dziennym harmonogramem dla wszystkich jednostek (tabel) w źródłowej bazie danych. Scenariusz nie zawiera przepływów danych. Nie wiąże się to z kosztami operacyjnymi, ponieważ potoki działają mniej niż milion operacji miesięcznie.

Dedykowana pula i magazyn usługi Azure Synapse Analytics

W przypadku przykładowego zestawu danych można aprowizować 500 jednostek magazynu danych (DWU), aby zapewnić bezproblemowe środowisko obciążeń analitycznych. Obliczenia można obsługiwać w godzinach pracy na potrzeby raportowania. Jeśli rozwiązanie przejdzie do środowiska produkcyjnego, użyj pojemności zarezerwowanego magazynu danych jako strategii ekonomicznej. Użyj różnych technik, aby zmaksymalizować metryki kosztów i wydajności.

Aby uzyskać szczegółowe informacje o cenach dedykowanej puli usługi Azure Synapse Analytics, zobacz kartę Magazynowanie danych w cenniku usługi Azure Synapse Analytics. W ramach dedykowanego modelu zużycia klienci generują koszty dla każdej aprowizowanej jednostki DWU na godzinę czasu pracy. Należy również wziąć pod uwagę koszty magazynowania danych, w tym rozmiar danych magazynowanych, migawek i nadmiarowości geograficznej.

Przechowywanie blobów

Rozważ użycie pojemności zarezerwowanej usługi Azure Storage, aby zmniejszyć koszty magazynowania. Dzięki temu modelowi uzyskasz rabat, jeśli rezerwujesz stałą pojemność magazynu przez jeden lub trzy lata. Aby uzyskać więcej informacji, zobacz Optymalizowanie kosztów magazynu obiektów blob przy użyciu pojemności zarezerwowanej. W tym scenariuszu nie jest używany magazyn trwały.

Power BI Premium

W tym scenariuszu są używane obszary robocze usługi Power BI Premium z wbudowanymi ulepszeniami wydajności w celu zaspokojenia wymagających potrzeb analitycznych.

Aby uzyskać więcej informacji, zobacz Cennik usługi Power BI.

Doskonałość operacyjna

Doskonałość operacyjna obejmuje procesy operacyjne, które wdrażają aplikację i działają w środowisku produkcyjnym. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu dotycząca doskonałości operacyjnej.

Użyj potoku wydania usługi Azure DevOps i funkcji GitHub Actions, aby zautomatyzować wdrażanie obszaru roboczego usługi Azure Synapse Analytics w wielu środowiskach. Aby uzyskać więcej informacji, zobacz Ciągła integracja i ciągłe dostarczanie dla obszaru roboczego usługi Azure Synapse Analytics.

Umieść każde obciążenie w osobnym szablonie wdrożenia i zapisz zasoby w systemach kontroli źródła. Szablony można wdrażać razem lub indywidualnie w ramach procesu ciągłej integracji i ciągłego dostarczania (CI/CD). Takie podejście upraszcza proces automatyzacji. Ta architektura ma cztery główne obciążenia:

- Serwer magazynu danych i powiązane zasoby

- Potoki usługi Azure Synapse Analytics

- Zasoby usługi Power BI, w tym pulpity nawigacyjne, aplikacje i zestawy danych

- Scenariusz symulowany w środowisku lokalnym do chmury

Rozważ przemieszczanie obciążeń tam, gdzie jest to praktyczne. Wdróż obciążenie na różnych etapach. Uruchom testy weryfikacji na każdym etapie przed przejściem do następnego etapu. Takie podejście wypycha aktualizacje do środowisk produkcyjnych w kontrolowany sposób i minimalizuje nieoczekiwane problemy z wdrażaniem. Użyj strategii wdrażania niebieski-zielony i kanary wydania , aby zaktualizować środowiska produkcyjne na żywo.

Użyj strategii wycofywania do obsługi wdrożeń, które zakończyły się niepowodzeniem. Możesz na przykład automatycznie ponownie wdrożyć wcześniejsze, pomyślne wdrożenie z historii wdrożenia. Użyj flagi

--rollback-on-errorw interfejsie wiersza polecenia platformy Azure.Usługa Azure Monitor umożliwia analizowanie wydajności magazynu danych i całej platformy analizy platformy Azure w celu uzyskania zintegrowanego środowiska monitorowania. Usługa Azure Synapse Analytics udostępnia środowisko monitorowania w witrynie Azure Portal, aby wyświetlić szczegółowe informacje o obciążeniu magazynu danych. Użyj witryny Azure Portal do monitorowania magazynu danych. Zapewnia konfigurowalne okresy przechowywania, alerty, rekomendacje i dostosowywalne wykresy i pulpity nawigacyjne dla metryk i dzienników.

Aby uzyskać więcej informacji, zobacz następujące zasoby:

- Samouczek: rozpoczynanie pracy z usługą Azure Synapse Analytics

- Tworzenie obszaru roboczego usługi Azure Synapse Analytics przy użyciu interfejsu wiersza polecenia platformy Azure

Efektywność operacyjna

Wydajność odnosi się do możliwości skalowania obciążenia w celu efektywnego zaspokojenia wymagań użytkowników. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu pod kątem wydajności.

Ta sekcja zawiera szczegółowe informacje na temat decyzji o określaniu rozmiaru, aby uwzględnić ten zestaw danych.

Aprowizowana pula usługi Azure Synapse Analytics

Można użyć różnych konfiguracji magazynu danych.

| Jednostki DWU | Liczba węzłów obliczeniowych | Liczba dystrybucji na węzeł |

|---|---|---|

| DW100c | 1 | 60 |

-- TO -- |

||

| DW30000c | 60 | 1 |

Aby zobaczyć korzyści z wydajności skalowania w poziomie, szczególnie w przypadku większych jednostek DWU, użyj co najmniej zestawu danych o rozmiarze 1 TB. Aby znaleźć najlepszą liczbę jednostek DWU dla dedykowanej puli SQL, spróbuj przeprowadzić skalowanie w górę i w dół. Uruchamiaj zapytania, które mają różne liczby jednostek DWU po załadowaniu danych. Skalowanie jest szybkie, dzięki czemu można łatwo eksperymentować z różnymi poziomami wydajności.

Znajdowanie najlepszej liczby jednostek DWU

W przypadku dedykowanej puli SQL w programowania wybierz niewielką liczbę jednostek DWU jako punkt początkowy, na przykład DW400c lub DW200c. Monitoruj wydajność aplikacji dla każdej liczby jednostek DWU. Załóżmy liniową skalę i określ, o ile trzeba zwiększyć lub zmniejszyć liczbę jednostek DWU. Kontynuuj wprowadzanie korekt, dopóki nie osiągniesz optymalnego poziomu wydajności dla wymagań biznesowych.

Skalowanie puli SQL usługi Azure Synapse Analytics

Aby uzyskać informacje na temat funkcji optymalizacji skalowalności i wydajności potoków w usłudze Azure Synapse Analytics i używanego działania kopiowania, zobacz Przewodnik dotyczący wydajności i skalowalności działania kopiowania.

Aby uzyskać więcej informacji, zobacz następujące zasoby:

- Skalowanie zasobów obliczeniowych dla puli SQL usługi Azure Synapse Analytics za pomocą witryny Azure Portal

- Skalowanie zasobów obliczeniowych dla dedykowanej puli SQL przy użyciu programu Azure PowerShell

- Skalowanie zasobów obliczeniowych dla dedykowanej puli SQL w usłudze Azure Synapse Analytics przy użyciu języka T-SQL

- Zarządzanie obliczeniami dla dedykowanej puli SQL

Usługa Power BI Premium i sieć szkieletowa

W tym artykule przedstawiono możliwości analizy biznesowej przy użyciu pojemności F64 usługi Power BI Premium . Dedykowane pojemności usługi Power BI w sieci szkieletowej wahają się od F64 (8 rdzeni wirtualnych) do F1024 (128 rdzeni wirtualnych).

Aby określić, ile pojemności potrzebujesz:

- Oceń obciążenie pojemności.

- Zainstaluj aplikację Metryki pojemności sieci szkieletowej na potrzeby ciągłego monitorowania.

- Rozważ użycie technik optymalizacji pojemności związanych z obciążeniem.

Współautorzy

Firma Microsoft utrzymuje ten artykuł. Następujący współautorzy napisali ten artykuł.

Autorzy zabezpieczeń:

- Galina Polyakova | Starszy architekt rozwiązań w chmurze

- Noah Costar | Architekt rozwiązań w chmurze

- George Stevens | Architekt rozwiązań w chmurze

Inni współautorzy:

- Jim McLeod | Architekt rozwiązań w chmurze

- Miguel Myers | Starszy menedżer programu

Aby wyświetlić niepubliczne profile serwisu LinkedIn, zaloguj się do serwisu LinkedIn.

Następne kroki

- Co to jest usługa Power BI Premium?

- Czym jest usługa Microsoft Entra ID?

- Uzyskiwanie dostępu do usługi Data Lake Storage i usługi Azure Blob Storage za pomocą usługi Azure Databricks

- Co to jest usługa Azure Synapse Analytics?

- Potoki i działania w usłudze Azure Data Factory i Azure Synapse Analytics

- Co to jest usługa Azure SQL?