Formação

Módulo

Usar blocos de anotações do Spark num pipeline do Azure Synapse - Training

Este módulo descreve como os blocos de anotações do Apache Spark podem ser integrados a um pipeline do Azure Synapse Analytics.

Este browser já não é suportado.

Atualize para o Microsoft Edge para tirar partido das mais recentes funcionalidades, atualizações de segurança e de suporte técnico.

Neste início rápido, você usa o Azure Synapse Analytics para criar um pipeline usando a definição de trabalho do Apache Spark.

Depois que seu espaço de trabalho do Azure Synapse for criado, você terá duas maneiras de abrir o Synapse Studio:

Neste início rápido, usamos o espaço de trabalho chamado "sampletest" como exemplo.

Um pipeline contém o fluxo lógico para uma execução de um conjunto de atividades. Nesta seção, você cria um pipeline que contém uma atividade de definição de trabalho do Apache Spark.

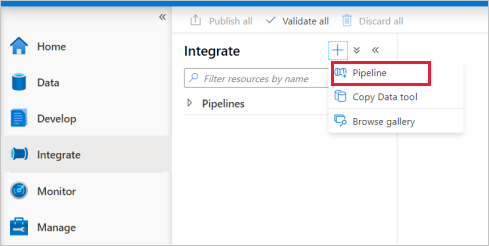

Selecione o ícone de adição ao lado do cabeçalho dos pipelines e selecione Pipeline.

Na página Configurações de propriedades do pipeline, insira demo para Name.

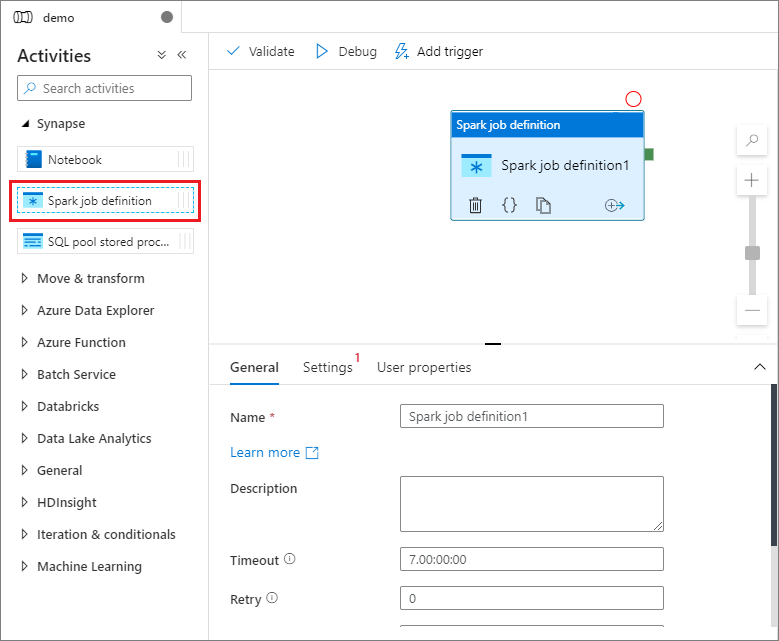

Em Sinapse , no painel Atividades , arraste a definição de trabalho do Spark para a tela do pipeline.

Depois de criar sua definição de trabalho do Apache Spark, você será enviado automaticamente para a tela de definição de trabalho do Spark.

Selecione o módulo de definição de tarefa de faísca na tela.

Na guia Geral, insira o exemplo para Nome.

(Opção) Você também pode inserir uma descrição.

Tempo limite: quantidade máxima de tempo que uma atividade pode ser executada. O padrão é de sete dias, que também é a quantidade máxima de tempo permitida. O formato está em D.HH:MM:SS.

Repetir: número máximo de tentativas de repetição.

Intervalo de novas tentativas: o número de segundos entre cada tentativa de repetição.

Saída segura: quando marcada, a saída da atividade não é capturada no registro.

Entrada segura: quando marcada, a entrada da atividade não é capturada no registro.

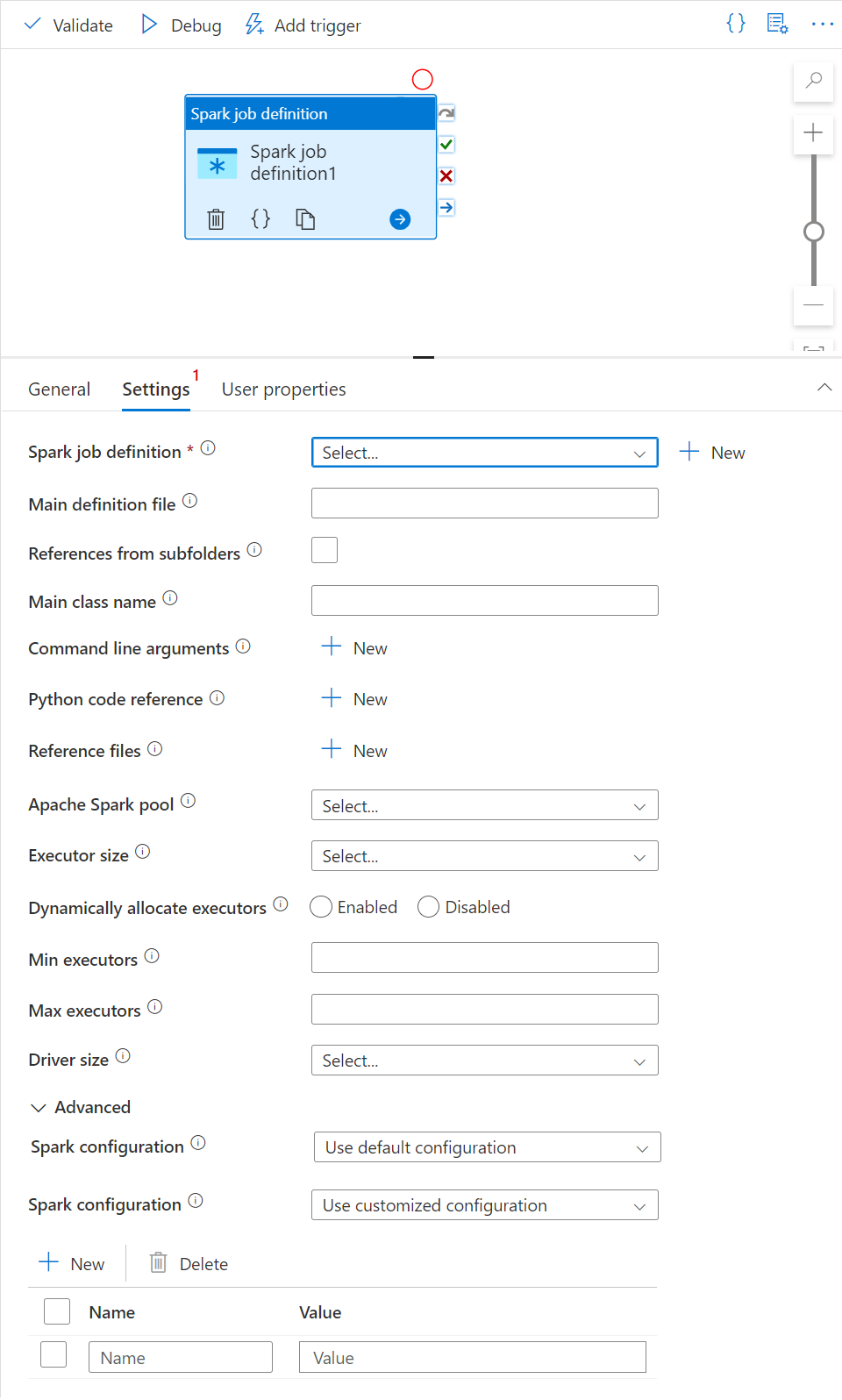

Neste painel, você pode fazer referência à definição de trabalho do Spark a ser executada.

Expanda a lista de definições de trabalho do Spark, você pode escolher uma definição de trabalho existente do Apache Spark. Você também pode criar uma nova definição de trabalho do Apache Spark selecionando o botão Novo para fazer referência à definição de trabalho do Spark a ser executada.

(Opcional) Você pode preencher as informações para a definição de trabalho do Apache Spark. Se as configurações a seguir estiverem vazias, as configurações da própria definição de trabalho de faísca serão usadas para executar; Se as configurações a seguir não estiverem vazias, elas substituem as configurações da própria definição de trabalho do Spark.

| Property | Description |

|---|---|

| Ficheiro de definição principal | O arquivo principal usado para o trabalho. Selecione um arquivo PY/JAR/ZIP do seu armazenamento. Você pode selecionar Carregar arquivo para carregar o arquivo em uma conta de armazenamento. Exemplo: abfss://…/path/to/wordcount.jar |

| Referências de subpastas | Verificando subpastas da pasta raiz do arquivo de definição principal, esses arquivos são adicionados como arquivos de referência. As pastas denominadas "jars", "pyFiles", "files" ou "archives" são verificadas, e o nome das pastas diferencia maiúsculas de minúsculas. |

| Nome da classe principal | O identificador totalmente qualificado ou a classe principal que está no arquivo de definição principal. Exemplo: WordCount |

| Argumentos de linha de comando | Você pode adicionar argumentos de linha de comando clicando no botão Novo . Deve-se observar que a adição de argumentos de linha de comando substitui os argumentos de linha de comando definidos pela definição de trabalho do Spark. Amostra: abfss://…/path/to/shakespeare.txtabfss://…/path/to/result |

| Piscina Apache Spark | Você pode selecionar Apache Spark pool na lista. |

| Referência de código Python | Outros arquivos de código Python usados para referência no arquivo de definição principal. Ele suporta a passagem de arquivos (.py, .py3, .zip) para a propriedade "pyFiles". Ele substitui a propriedade "pyFiles" definida na definição de trabalho do Spark. |

| Ficheiros de referência | Outros arquivos usados para referência no arquivo de definição principal. |

| Alocar executores dinamicamente | Essa configuração é mapeada para a propriedade de alocação dinâmica na configuração do Spark para alocação de executores do Spark Application. |

| Executores Min | Número mínimo de executores a serem alocados no pool Spark especificado para o trabalho. |

| Max executores | Número máximo de executores a serem alocados no pool de faíscas especificado para o trabalho. |

| Tamanho do driver | Número de núcleos e memória a serem usados para o driver fornecido no pool Apache Spark especificado para o trabalho. |

| Configuração do Spark | Especifique valores para as propriedades de configuração do Spark listadas no artigo: Configuração do Spark - Propriedades do aplicativo. Os usuários podem usar a configuração padrão e a configuração personalizada. |

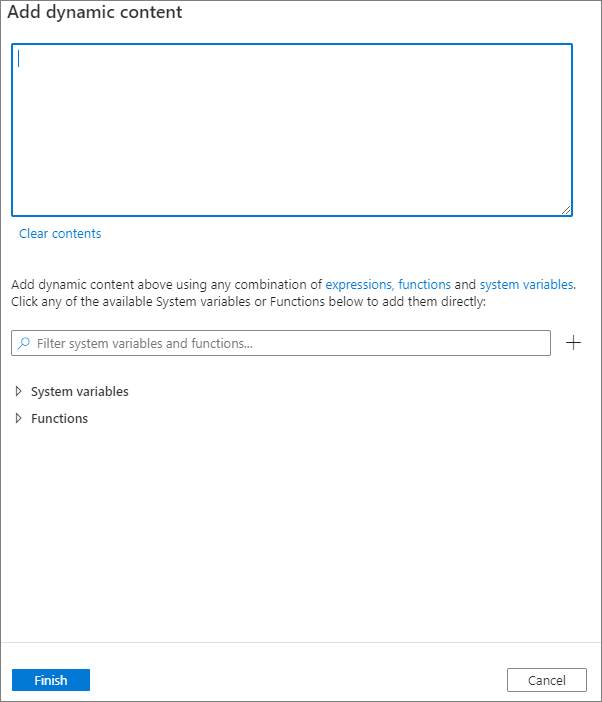

Você pode adicionar conteúdo dinâmico clicando no botão Adicionar conteúdo dinâmico ou pressionando a tecla de atalho Alt+Shift+D. Na página Adicionar Conteúdo Dinâmico, você pode usar qualquer combinação de expressões, funções e variáveis do sistema para adicionar ao conteúdo dinâmico.

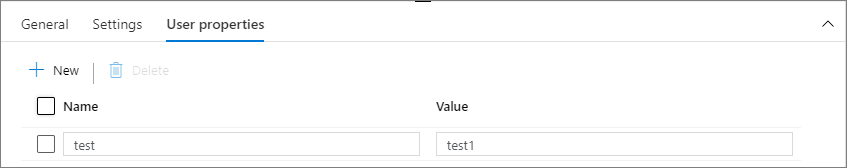

Você pode adicionar propriedades para a atividade de definição de trabalho do Apache Spark neste painel.

Avance para os seguintes artigos para saber mais sobre o suporte do Azure Synapse Analytics:

Formação

Módulo

Usar blocos de anotações do Spark num pipeline do Azure Synapse - Training

Este módulo descreve como os blocos de anotações do Apache Spark podem ser integrados a um pipeline do Azure Synapse Analytics.

Documentação

Visão geral do Apache Spark no Azure Synapse Analytics - Azure Synapse Analytics

Este artigo fornece uma introdução ao Apache Spark no Azure Synapse Analytics e os diferentes cenários nos quais você pode usar o Spark.

Utilize a atividade de cópia do pipeline no Azure Synapse Analytics para carregar dados para o conjunto de SQL dedicado.

Este tutorial fornece instruções passo a passo para usar o Azure Synapse Analytics para transformar dados com o fluxo de dados de mapeamento.