Poznámka

Na prístup k tejto stránke sa vyžaduje oprávnenie. Môžete sa skúsiť prihlásiť alebo zmeniť adresáre.

Na prístup k tejto stránke sa vyžaduje oprávnenie. Môžete skúsiť zmeniť adresáre.

Microsoft Fabric Runtime je platforma integrovaná do Azure založená na Apache Spark, ktorá umožňuje realizáciu a správu skúseností dátového inžinierstva a dátovej vedy. Kombinuje kľúčové komponenty z interných aj open-source zdrojov, čím zákazníkom poskytuje komplexné riešenie. Pre jednoduchosť odkazujeme na Microsoft Fabric Runtime, ktorý funguje v apache Spark, ako na Runtime služby Fabric.

Hlavné súčasti CLR služby Fabric:

Apache Spark – výkonná knižnica distribuovanej computingu typu open-source, ktorá umožňuje rozsiahle úlohy v oblasti spracovania údajov a analýzy. Apache Spark poskytuje všestrannú a vysokovýkonnú platformu na prácu s dátovým inžinierom a dátovými vedami.

Delta Lake – open-source ukladací priestor, ktorý prináša transakcie ACID a ďalšie funkcie spoľahlivosti údajov do Apache Spark. Delta Lake integrovaná do služby Fabric Runtime zlepšuje možnosti spracovania údajov a zabezpečuje konzistentnosť údajov v rámci viacerých súbežných operácií.

Natívny nástroj na spúšťanie – je transformačným vylepšením pre vyťaženia Apache Spark, ktorý ponúka významné zisky z výkonu priamym vykonaním dotazov Spark na infraštruktúru lakehouse. Integrovaná bez problémov, nevyžaduje žiadne zmeny kódu a vyhýba sa lock-inu dodávateľa, čo podporuje formáty Parquet aj Delta v rámci rozhraní Apache Spark API v runtime 1.3 (Spark 3.5). Tento nástroj zvýši rýchlosť dotazu až štyrikrát rýchlejšie než tradičná služba OSS Spark, ako ukazuje štandard TPC-DS 1TB, znižuje prevádzkové náklady a zlepšuje efektivitu v rámci rôznych úloh s údajmi vrátane príjmu údajov, ETL, analýz a interaktívnych dotazov. Natívny nástroj na spúšťanie je založený na dvoch kľúčových súčastiach OSS: Velox, knižnicu zrýchlenia databázy C++, ktorú zaviedli Meta a Apache Glut (incubating), strednú vrstvu zodpovednú za vyťaženie nástrojov SQL založených na JVM na natívne motory predstavené spoločnosťou Intel.

Balíky predvolenej úrovne pre balíky Java/Scala, Python a R – balíky, ktoré podporujú rozličné programovacie jazyky a prostredia. Tieto balíky sa automaticky nainštalujú a nakonfigurujú a vývojárom umožnia použiť pre úlohy spracovania údajov ich preferované programovacie jazyky.

Služba Microsoft Fabric Runtime je založená na robustnom operačnom systéme typu open-source, ktorý zabezpečuje kompatibilitu s rôznymi hardvérovými konfiguráciami a systémovými požiadavkami.

Nižšie nájdete komplexné porovnanie kľúčových súčastí vrátane verzií Apache Spark, podporovaných operačných systémov, Java, Scala, Python, Delta Lake a R pre moduly runtime založené na Apache Spark v rámci platformy Microsoft Fabric.

Prepitné

Vždy používajte najnovšiu, všeobecne dostupnú (GA) runtime verziu pre vašu produkčnú záťaž, ktorou je momentálne Runtime 1.3.

| Súčasť | Runtime 1.2 | Runtime 1.3 | Runtime 2.0 |

|---|---|---|---|

| fáza vydania |

EOSA | GA | Experimentálne (Ukážka) |

| Verzia Apache Spark | 3.4.1 | 3.5.5 | 4.0.0 |

| Operačný systém | Mariner 2.0 | Mariner 2.0 | Mariner 3.0 |

| Java verzia | 11 | 11 | 21 |

| Scala verzia | 2.12.17 | 2.12.17 | 2.13.16 |

| Python verzia | 3,10 | 3.11 | 3.12.11 |

| Verzia Delta Lake | 2.4.0 | 3,2 | 4.0.0 |

Navštívte Runtime 1.2, Runtime 1.3 alebo Runtime 2.0 a preskúmajte detaily, nové funkcie, vylepšenia a scenáre migrácie pre konkrétnu verziu runtime.

Optimalizácie tkaniny

V službe Microsoft Fabric zahŕňa nástroj Spark aj implementácie delta lake optimalizácie a funkcie špecifické pre platformu. Tieto funkcie sú navrhnuté tak, aby používali natívne integrácie v rámci platformy. Ak chcete dosiahnuť štandardné funkcie spark a Delta Lake, je dôležité poznamenať, že všetky tieto funkcie môžu byť zakázané. Služba Fabric Runtimes pre Apache Spark zahŕňa:

- Kompletná open-source verzia Apache Spark.

- Kolekcia takmer 100 vstavaných jedinečných vylepšení výkonu dotazov. Tieto vylepšenia zahŕňajú funkcie, ako je ukladanie do vyrovnávacej pamäte na oblasti (povolenie vyrovnávacej pamäte oblasti FileSystem na zníženie volaní metastore) a Krížové pripojenie k projekcii skalárneho poddotazu.

- Vstavaná inteligentná vyrovnávacia pamäť.

V rámci modulu Runtime služby Fabric pre Apache Spark a Delta Lake existujú natívne možnosti spisovateľa, ktoré slúžia na dva kľúčové účely:

- Ponúka odlišný výkon pri písaní vyťažení, čo optimalizuje proces písania.

- Predvolene sú optimalizované na V-Order súborov Delta Parquet. Optimalizácia delta Lake V-Order je rozhodujúca pre poskytovanie lepšieho výkonu na čítanie vo všetkých motoroch tkaniny. Ak chcete získať podrobnejšie informácie o tom, ako funguje a ako ju spravovať, pozrite si vyhradené článok o optimalizácii tabuľky Delta Lake a objednávke V-Order.

Podpora viacerých modulov runtime

Fabric podporuje viacero modulov runtime, ktoré používateľom ponúkajú flexibilitu, aby medzi nimi bezproblémovo prepínali, čím sa minimalizuje riziko nezlučiteľnosti alebo prerušenia.

Predvolene všetky nové pracovné priestory používajú najnovšiu verziu GA runtime, ktorá je momentálne Runtime 1.3.

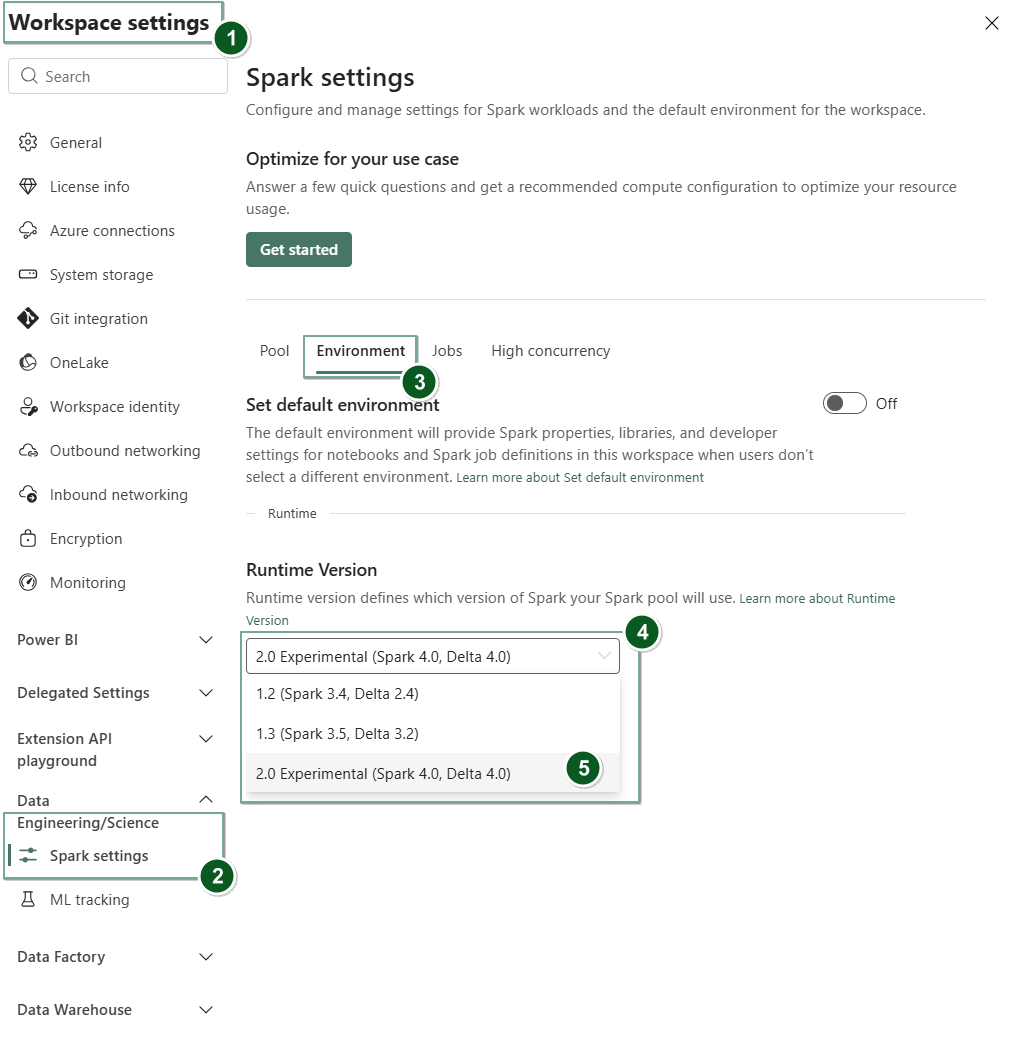

Ak chcete zmeniť verziu modulu runtime na úrovni pracovného priestoru, prejdite na nastavenia pracovného priestoru>nastavenia Dátové inžinierstvo/veda>Spark. Na karte Environment vyberte požadovanú verziu modulu runtime z dostupných možností. Výberom položky Uložiť potvrďte výber.

Po vykonaní tejto zmeny budú všetky položky vytvorené systémom v pracovnom priestore vrátane lakehouses, SJD a poznámkových blokov fungovať pomocou novo vybratej verzie režimu runtime na úrovni pracovného priestoru od nasledujúcej relácie Spark. Ak momentálne používate poznámkový blok s existujúcou reláciou pre úlohu alebo akúkoľvek aktivitu súvisiacu s lakehouse, táto relácia služby Spark pokračuje rovnako ako je. Od nasledujúcej relácie alebo úlohy sa však použije vybratá verzia modulu runtime.

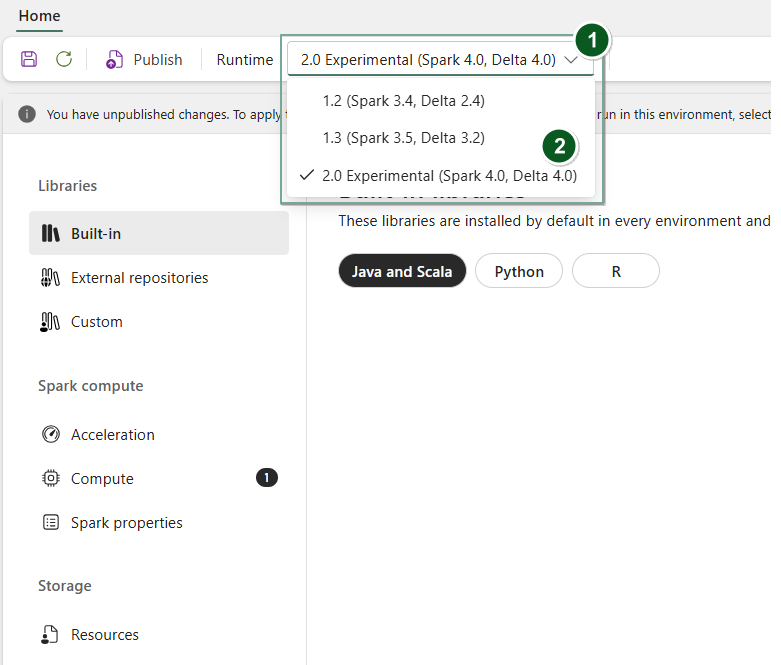

Okrem toho, ak chcete zmeniť runtime na úrovni predmetu Environment , vytvoriť nový item Environment alebo otvorený a existujúci, v rozbaľovacom menu Runtime vyberte požadovanú runtime verziu z dostupných možností, vyberte Save a potom Publish svoje zmeny. Ďalej môžete použiť tento Environment predmet s vaším Notebook alebo Spark Job Definition.

Dôsledky zmien modulu runtime v nastaveniach Spark

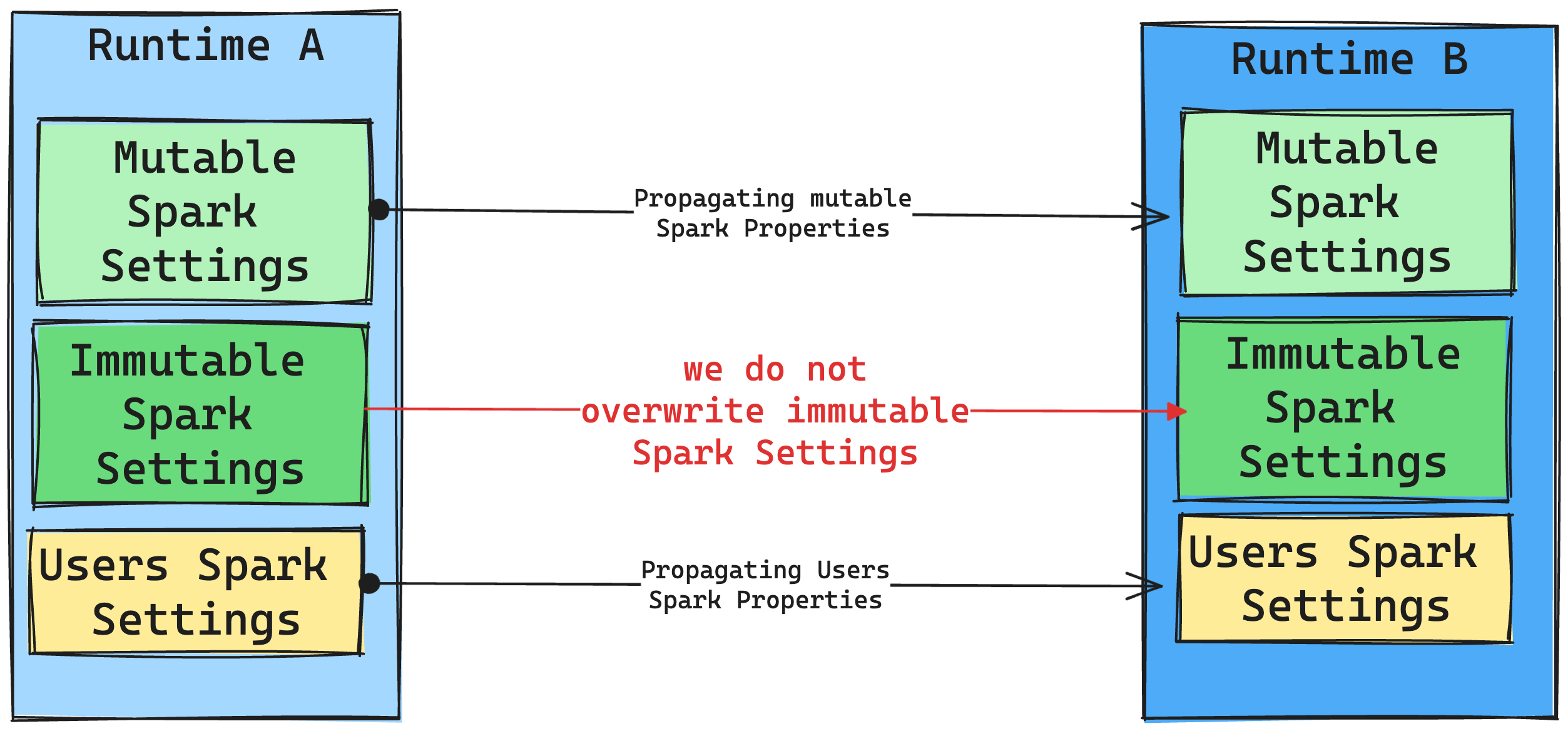

Vo všeobecnosti sa snažíme migrovať všetky nastavenia služby Spark. Ak však zistíme, že nastavenie Spark nie je kompatibilné s modulom Runtime B, vydáme upozorňujúce hlásenie a zdržíme sa implementácie nastavenia.

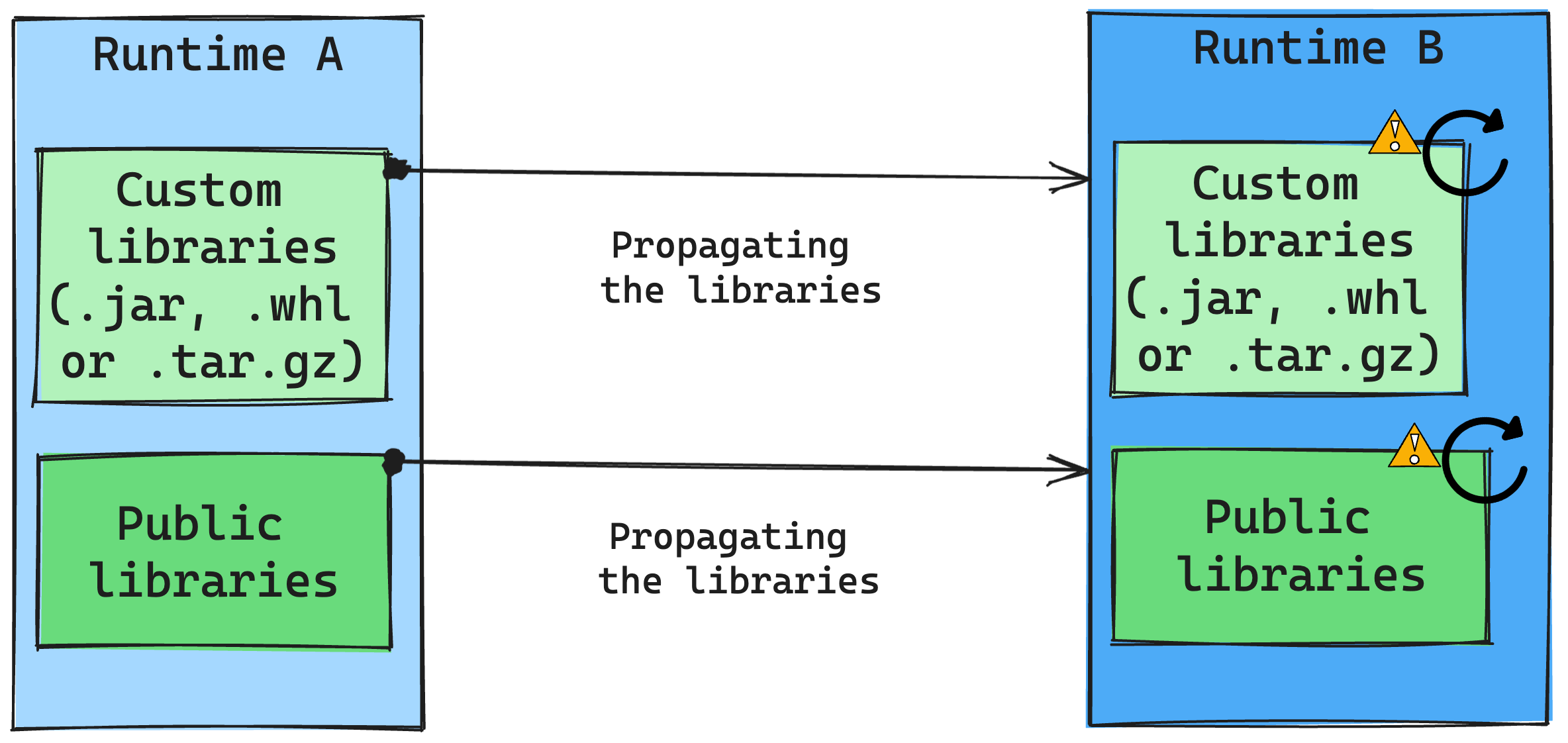

Dôsledky zmien modulu runtime v správe knižnice

Vo všeobecnosti platí, že naším prístupom je migrácia všetkých knižníc z modulu Runtime A do modulu Runtime B vrátane verejných aj vlastných modulov runtime. Ak verzie jazyka Python a R zostanú nezmenené, knižnice by mali fungovať správne. Avšak pri Jars je značná pravdepodobnosť, že nebudú fungovať kvôli zmenám závislostí a ďalším faktorom, ako sú zmeny v Scale, Jave, Sparku a operačnom systéme.

Používateľ je zodpovedný za aktualizáciu alebo výmenu knižníc, ktoré nefungujú s Runtime B. Ak nastane konflikt, čo znamená, že Runtime B obsahuje knižnicu pôvodne definovanú v Runtime A, náš systém správy knižníc sa snaží vytvoriť potrebnú závislosť pre Runtime B na základe nastavení používateľa. Avšak stavebný proces zlyháva, ak dôjde ku konfliktu. V denníku chýb môžu používatelia zistiť, ktoré knižnice spôsobujú konflikty, a vykonávať úpravy svojich verzií alebo špecifikácií.

Inovácia protokolu Delta Lake

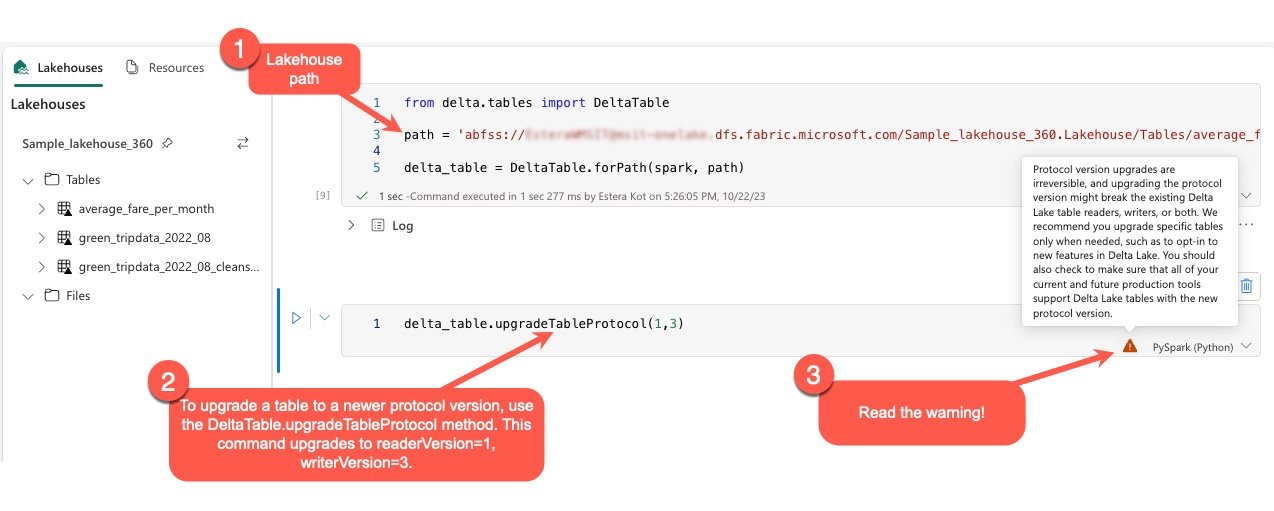

Funkcie Delta Lake sú vždy spätne kompatibilné, čo zabezpečuje, aby tabuľky vytvorené v nižšej verzii Delta Lake mohli bez problémov interagovať s vyššími verziami. Avšak, keď sú povolené určité funkcie (napríklad použitím delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) metódy), môže byť ohrozená kompatibilita s nižšími verziami Delta Lake. V takýchto prípadoch je nevyhnutné upraviť vyťaženia odkazujúce na inovované tabuľky, aby sa zosúladili s verziou Delta Lake, ktorá si zachováva kompatibilitu.

Každá tabuľka Delta je priradená k špecifikácii protokolu a definuje funkcie, ktoré podporuje. Aplikácie, ktoré interagujú s tabuľkou, či už na čítanie alebo zápis, sa spoliehajú na špecifikáciu tohto protokolu, aby zistili, či sú kompatibilné s funkciami tabuľky. Ak aplikácia nemá schopnosť spracovať funkciu uvedenú ako podporovanú v protokole tabuľky, nie je schopná z tejto tabuľky čítať ani do nej zapisovať.

Špecifikácia protokolu je rozdelená na dve odlišné komponenty: "read" protokol a "write" protokol. Pre viac informácií navštívte stránku "Ako Delta Lake spravuje kompatibilitu funkcií?".

Používatelia môžu vykonať príkaz delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) v prostredí PySpark a v službách Spark SQL a Scala. Tento príkaz im umožňuje iniciovať aktualizáciu tabuľky Delta.

Je dôležité poznamenať, že pri vykonávaní tejto inovácie sa používateľom zobrazí upozornenie oznamujúce, že inovácia verzie protokolu Delta je nevratný proces. To znamená, že akonáhle je aktualizácia vykonaná, už ju nemožno vrátiť späť.

Aktualizácie verzií protokolu môžu potenciálne ovplyvniť kompatibilitu existujúcich čítačiek tabuliek Delta Lake, zapisovačov alebo oboch. Preto sa odporúča postupovať opatrne a aktualizovať verziu protokolu len v prípade potreby, napríklad pri prijímaní nových funkcií v Delta Lake.

Dôležité

Ak sa chcete dozvedieť viac o tom, ktoré verzie a funkcie protokolov sú kompatibilné naprieč všetkými zážitkami Microsoft Fabric, prečítajte si interoperabilitu formátov tabuliek Delta Lake.

Okrem toho by používatelia mali overiť, či sú všetky súčasné aj budúce produkčné vyťaženia a procesy kompatibilné s tabuľkami Delta Lake pomocou novej verzie protokolu, aby sa zaistil bezproblémový prechod a zabránilo prípadnému prerušeniu.