Salin data ke atau dari Azure Databricks Delta Lake menggunakan Azure Data Factory atau Azure Synapse Analytics

BERLAKU UNTUK:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Artikel ini menguraikan cara menggunakan Salin Aktivitas di Azure Data Factory dan Azure Synapse untuk menyalin data ke dan dari Azure Databricks Delta Lake. Artikel tersebut dibuat berdasarkan Aktivitas Salin di Azure Data Factory, yang menyajikan gambaran umum aktivitas salin.

Kemampuan yang didukung

Konektor Delta Lake Azure Databricks ini didukung untuk kemampuan berikut:

| Kemampuan yang didukung | IR |

|---|---|

| Salin aktivitas (sumber/sink) | (1) (2) |

| Memetakan aliran data (sumber/sink) | (1) |

| Aktivitas pencarian | (1) (2) |

① Runtime integrasi Azure ② Runtime integrasi yang dihost sendiri

Secara umum, layanan mendukung Delta Lake dengan kemampuan berikut untuk memenuhi berbagai kebutuhan Anda.

- Aktivitas salin mendukung konektor Azure Databricks Delta Lake untuk menyalin data dari penyimpanan data sumber yang didukung ke tabel delta lake Azure Databricks, dan dari tabel delta lake ke penyimpanan data sink yang didukung. Ini memanfaatkan kluster Databricks Anda untuk melakukan pergerakan data, lihat detail di bagian Prasyarat.

- Mapping Data Flow mendukung format Delta generik di Azure Storage sebagai sumber dan sink untuk membaca dan menulis file Delta untuk ETL bebas kode, dan berjalan pada Azure Integration Runtime terkelola.

- Aktivitas Databricks mendukung orkestrasi ETL yang berpusat pada kode atau beban kerja pembelajaran mesin di atas delta lake.

Prasyarat

Untuk menggunakan konektor Azure Databricks Delta Lake ini, Anda perlu menyiapkan kluster di Azure Databricks.

- Untuk menyalin data ke delta lake, Aktivitas salin memanggil kluster Azure Databricks untuk membaca data dari Azure Storage, yang merupakan sumber asli Anda atau area bertahap tempat layanan terlebih dahulu menulis data sumber melalui salinan bertahap bawaan. Pelajari lebih lanjut dari Delta lake sebagai sink.

- Demikian pula, untuk menyalin data dari delta lake, aktivitas Salin memanggil kluster Azure Databricks untuk menulis data ke Azure Storage, yang merupakan sink asli Anda atau area bertahap tempat layanan terus menulis data ke sink akhir melalui salinan bertahap bawaan. Pelajari lebih lanjut dari Delta lake sebagai sumber.

Kluster Databricks harus memiliki akses ke akun Azure Blob atau Azure Data Lake Storage Gen2, baik sistem kontainer/file penyimpanan yang digunakan untuk sumber/sink/staging dan sistem kontainer/file tempat Anda ingin menulis tabel Delta Lake.

Untuk menggunakan Azure Data Lake Storage Gen2, Anda dapat mengonfigurasikan perwakilan layanan pada kluster Databricks sebagai bagian dari konfigurasi Apache Spark. Ikuti langkah-langkah di Access langsung dengan perwakilan layanan.

Untuk menggunakan penyimpanan Azure Blob,Anda dapat mengonfigurasikan kunci akses akun penyimpanan atau token SAS pada klaster Databricks sebagai bagian dari konfigurasi Apache Spark. Ikuti langkah-langkah pada penyimpanan Blob Access Azure menggunakan API RDD.

Selama eksekusi aktivitas salin, jika kluster yang Anda konfigurasi telah dihentikan, layanan akan secara otomatis memulainya. Jika Anda menulis alur menggunakan antarmuka pengguna penulisan, untuk operasi seperti pratinjau data, Anda harus memiliki kluster langsung, layanan tidak akan memulai kluster atas nama Anda.

Tentukan konfigurasi kluster

Di menu drop-down Mode Kluster, pilih Standar.

Di menu drop-down Versi Runtime Databricks, pilih versi runtime Databricks.

Aktifkan Optimalkan Otomatis dengan menambahkan properti berikut ke konfigurasi Spark Anda:

spark.databricks.delta.optimizeWrite.enabled true spark.databricks.delta.autoCompact.enabled trueKonfigurasikan kluster Anda sesuai dengan kebutuhan integrasi dan penskalaan Anda.

Untuk detail konfigurasi kluster, lihat Mengonfigurasikan kluster.

Memulai

Untuk melakukan aktivitas Salin dengan alur, Anda dapat menggunakan salah satu alat atau SDK berikut:

- Alat Penyalinan Data

- Portal Microsoft Azure

- SDK .NET

- SDK Python

- Azure PowerShell

- REST API

- Templat Azure Resource Manager

Membuat layanan tertaut ke Azure Databricks Delta Lake menggunakan UI

Gunakan langkah-langkah berikut untuk membuat layanan tertaut ke Azure Databricks Delta Lake di UI portal Azure.

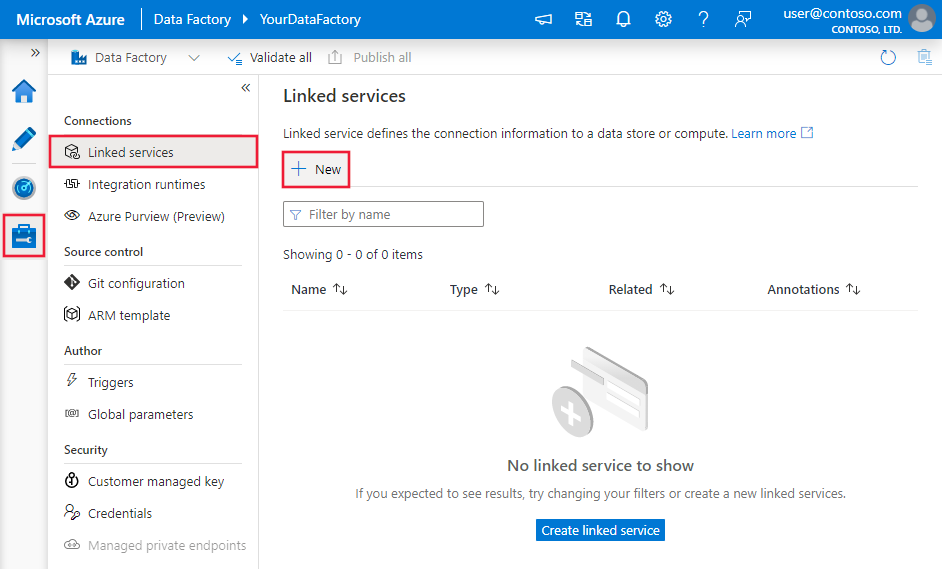

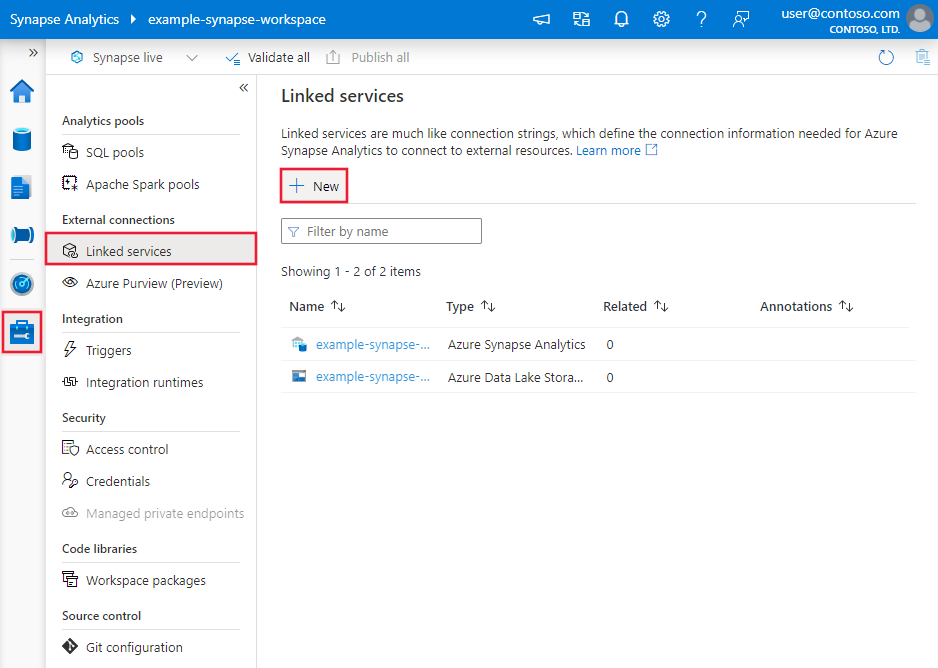

Telusuri ke tab Kelola di ruang kerja Azure Data Factory atau Synapse Anda dan pilih Layanan Tertaut, lalu klik Baru:

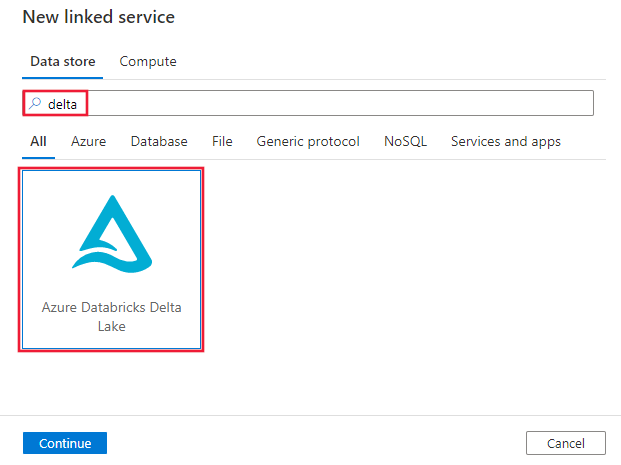

Cari delta dan pilih konektor Azure Databricks Delta Lake.

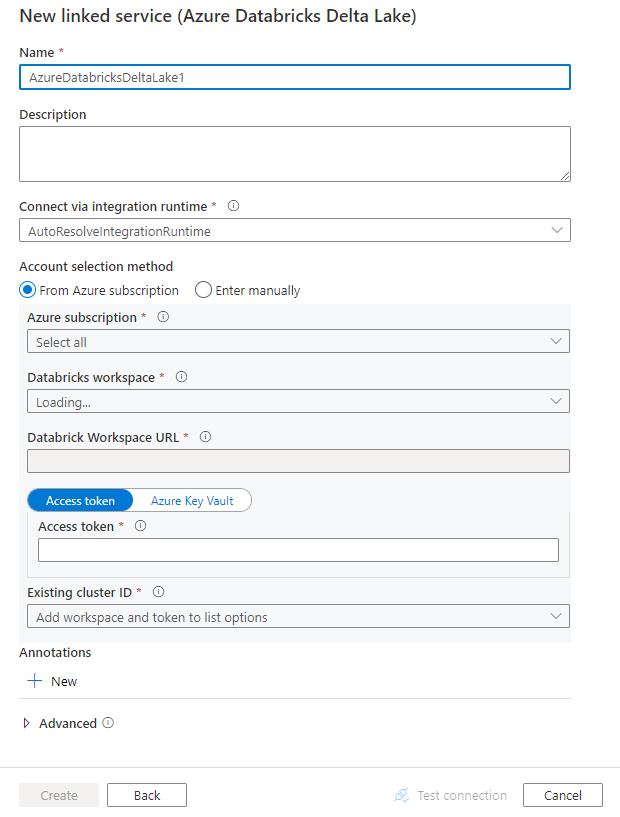

Konfigurasikan detail layanan, uji koneksi, dan buat layanan tertaut baru.

Detail konfigurasi konektor

Bagian berikut ini menyediakan detail tentang properti yang digunakan untuk menentukan entitas khusus untuk konektor Azure Databricks Delta Lake.

Properti layanan tertaut

Konektor Azure Databricks Delta Lake ini mendukung jenis autentikasi berikut ini. Lihat bagian terkait untuk detailnya.

- Token akses

- Autentikasi identitas terkelola yang ditetapkan sistem

- Autentikasi identitas terkelola yang ditetapkan pengguna

Token akses

Properti berikut ini didukung untuk layanan tertaut Azure Databricks Delta Lake:

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis harus diatur ke AzureDatabricksDeltaLake. | Ya |

| domain | Tentukan URL ruang kerja Azure Databricks, misalnya https://adb-xxxxxxxxx.xx.azuredatabricks.net. |

|

| clusterId | Tentukan ID kluster dari kluster yang ada. Itu harus menjadi Kluster Interaktif yang sudah dibuat. Anda dapat menemukan ID Kluster dari Kluster Interaktif di ruang kerja Databricks -> Kluster -> Nama Kluster Interaktif -> Konfigurasi -> Tag. Pelajari selengkapnya. |

|

| accessToken | Token akses diperlukan agar layanan dapat mengautentikasi ke Azure Databricks. Token akses perlu dihasilkan dari ruang kerja databricks. Langkah-langkah detail selengkapnya untuk menemukan token akses dapat ditemukan di sini. | |

| connectVia | Runtime integrasiyang akan digunakan untuk menyambungkan ke penyimpanan data. Anda dapat menggunakan runtime integrasi Azure atau runtime integrasi yang dihost sendiri jika penyimpanan data Anda berada di jaringan pribadi. Jika tidak ditentukan, menggunakan default Azure Integration Runtime. | No |

Contoh:

{

"name": "AzureDatabricksDeltaLakeLinkedService",

"properties": {

"type": "AzureDatabricksDeltaLake",

"typeProperties": {

"domain": "https://adb-xxxxxxxxx.xx.azuredatabricks.net",

"clusterId": "<cluster id>",

"accessToken": {

"type": "SecureString",

"value": "<access token>"

}

}

}

}

Autentikasi identitas terkelola yang ditetapkan sistem

Untuk mempelajari lebih lanjut identitas terkelola yang ditetapkan sistem versus identitas terkelola yang ditetapkan pengguna, lihat Identitas terkelola yang ditetapkan oleh sistem untuk sumber daya Azure.

Untuk menggunakan autentikasi identitas terkelola yang ditetapkan sistem, ikuti langkah-langkah berikut untuk memberikan izin:

Ambil informasi identitas terkelola dengan menyalin nilai ID objek identitas terkelola yang dihasilkan bersama dengan pabrik atau ruang kerja Synapse Anda.

Beri identitas terkelola izin yang benar di Azure Databricks. Secara umum, Anda harus memberikan setidaknya peran Kontributor ke identitas terkelola yang ditetapkan sistem Anda dalam kontrol Akses (IAM) Azure Databricks.

Properti berikut ini didukung untuk layanan tertaut Azure Databricks Delta Lake:

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis harus diatur ke AzureDatabricksDeltaLake. | Ya |

| domain | Tentukan URL ruang kerja Azure Databricks, misalnya https://adb-xxxxxxxxx.xx.azuredatabricks.net. |

Ya |

| clusterId | Tentukan ID kluster dari kluster yang ada. Itu harus menjadi Kluster Interaktif yang sudah dibuat. Anda dapat menemukan ID Kluster dari Kluster Interaktif di ruang kerja Databricks -> Kluster -> Nama Kluster Interaktif -> Konfigurasi -> Tag. Pelajari selengkapnya. |

Ya |

| workspaceResourceId | Tentukan ID sumber daya ruang kerja Azure Databricks Anda. | Ya |

| connectVia | Runtime integrasiyang akan digunakan untuk menyambungkan ke penyimpanan data. Anda dapat menggunakan runtime integrasi Azure atau runtime integrasi yang dihost sendiri jika penyimpanan data Anda berada di jaringan pribadi. Jika tidak ditentukan, menggunakan default Azure Integration Runtime. | No |

Contoh:

{

"name": "AzureDatabricksDeltaLakeLinkedService",

"properties": {

"type": "AzureDatabricksDeltaLake",

"typeProperties": {

"domain": "https://adb-xxxxxxxxx.xx.azuredatabricks.net",

"clusterId": "<cluster id>",

"workspaceResourceId": "<workspace resource id>"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Autentikasi identitas terkelola yang ditetapkan pengguna

Untuk mempelajari selengkapnya tentang identitas terkelola yang ditetapkan pengguna untuk sumber daya Azure, lihat Identitas terkelola yang ditetapkan oleh pengguna

Untuk menggunakan autentikasi identitas terkelola yang ditetapkan pengguna, ikuti langkah-langkah berikut:

Buat satu atau beberapa identitas terkelola yang ditetapkan pengguna dan berikan izin di Azure Databricks Anda. Secara umum, Anda harus memberikan setidaknya peran Kontributor ke identitas terkelola yang ditetapkan sistem Anda dalam kontrol Akses (IAM) Azure Databricks.

Tetapkan satu atau beberapa identitas terkelola yang ditetapkan pengguna ke pabrik data atau ruang kerja Synapse Anda, dan buat informasi masuk untuk setiap identitas terkelola yang ditetapkan pengguna.

Properti berikut ini didukung untuk layanan tertaut Azure Databricks Delta Lake:

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis harus diatur ke AzureDatabricksDeltaLake. | Ya |

| domain | Tentukan URL ruang kerja Azure Databricks, misalnya https://adb-xxxxxxxxx.xx.azuredatabricks.net. |

Ya |

| clusterId | Tentukan ID kluster dari kluster yang ada. Itu harus menjadi Kluster Interaktif yang sudah dibuat. Anda dapat menemukan ID Kluster dari Kluster Interaktif di ruang kerja Databricks -> Kluster -> Nama Kluster Interaktif -> Konfigurasi -> Tag. Pelajari selengkapnya. |

Ya |

| informasi masuk | Tentukan identitas terkelola yang ditetapkan pengguna sebagai objek kredensial. | Ya |

| workspaceResourceId | Tentukan ID sumber daya ruang kerja Azure Databricks Anda. | Ya |

| connectVia | Runtime integrasiyang akan digunakan untuk menyambungkan ke penyimpanan data. Anda dapat menggunakan runtime integrasi Azure atau runtime integrasi yang dihost sendiri jika penyimpanan data Anda berada di jaringan pribadi. Jika tidak ditentukan, menggunakan default Azure Integration Runtime. | No |

Contoh:

{

"name": "AzureDatabricksDeltaLakeLinkedService",

"properties": {

"type": "AzureDatabricksDeltaLake",

"typeProperties": {

"domain": "https://adb-xxxxxxxxx.xx.azuredatabricks.net",

"clusterId": "<cluster id>",

"credential": {

"referenceName": "credential1",

"type": "CredentialReference"

},

"workspaceResourceId": "<workspace resource id>"

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Properti himpunan data

Untuk daftar lengkap bagian dan properti yang tersedia untuk menentukan himpunan data, lihat artikel Himpunan Data.

Properti berikut ini didukung untuk himpunan data Azure Databricks Delta Lake.

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis himpunan data harus diatur ke AzureDatabricksDeltaLakeDataset. | Ya |

| database | Nama database. | Tidak untuk sumber, Ya untuk sink |

| tabel | Nama tabel delta. | Tidak untuk sumber, Ya untuk sink |

Contoh:

{

"name": "AzureDatabricksDeltaLakeDataset",

"properties": {

"type": "AzureDatabricksDeltaLakeDataset",

"typeProperties": {

"database": "<database name>",

"table": "<delta table name>"

},

"schema": [ < physical schema, optional, retrievable during authoring > ],

"linkedServiceName": {

"referenceName": "<name of linked service>",

"type": "LinkedServiceReference"

}

}

}

Properti aktivitas salin

Untuk daftar lengkap bagian dan properti yang tersedia untuk menentukan aktivitas, lihat artikel Alur. Bagian ini menyediakan daftar properti yang didukung oleh sumber dan sink Azure Databricks Delta Lake.

Delta lake sebagai sumber

Untuk menyalin data dari Azure Databricks Delta Lake, properti berikut ini didukung di bagiansumberaktivitas Salin.

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis sumber aktivitas Salin harus diatur ke AzureDatabricksDeltaLakeSource. | Ya |

| pertanyaan | Tentukan kueri SQL untuk membaca data. Untuk kontrol perjalanan waktu, ikuti pola di bawah ini: - SELECT * FROM events TIMESTAMP AS OF timestamp_expression- SELECT * FROM events VERSION AS OF version |

No |

| exportSettings | Pengaturan lanjutan digunakan untuk mengambil data dari tabel delta. | No |

Di bawah exportSettings: |

||

| jenis | Jenis perintah ekspor, diatur ke AzureDatabricksDeltaLakeExportCommand. | Ya |

| dateFormat | Format tipe tanggal untuk diuntai dengan format tanggal. Format tanggal kustom mengikuti format pada pola tanggalwaktu. Jika tidak ditentukan, ia menggunakan nilai default yyyy-MM-dd. |

No |

| timestampFormat | Format jenis tanda waktu untuk menguntai dengan format tanda waktu. Format tanggal kustom mengikuti format pada pola tanggalwaktu. Jika tidak ditentukan, ia menggunakan nilai default yyyy-MM-dd'T'HH:mm:ss[.SSS][XXX]. |

No |

Salinan langsung dari delta lake

Jika penyimpanan data dan format sink Anda memenuhi kriteria yang dijelaskan di bagian ini, Anda dapat menggunakan aktivitas Salin untuk langsung menyalin dari Azure Databricks ke sink. Layanan memeriksa pengaturan dan gagal menjalankan aktivitas Salin jika kriteria berikut tidak terpenuhi:

Layanan sink yang ditautkan adalah penyimpanan Azure Blob atau Azure Data Lake Storage Gen2. Info masuk akun harus dikonfigurasikan sebelumnya dalam konfigurasi kluster Azure Databricks, pelajari lebih lanjut dari Prasyarat.

Format data sink adalah Parquet, teks yang dibatasi, atau Avro dengan konfigurasi berikut, dan menunjuk ke folder alih-alih file.

- Untuk formatParquet, kodek pemadatan none, snappy,, atau gzip.

- Untuk format teks yang dibatasi:

rowDelimiteradalah setiap karakter tunggal.compressionbisa jadi none, bzip2, gzip.encodingNameUTF-7 tidak didukung.

- Untuk format Avro, kodek pemadatan adalah none, deflate, atau snappy.

Di sumber aktivitas Salin,

additionalColumnstidak ditentukan.Jika menyalin data ke teks yang dibatasi, di sink aktivitas salin,

fileExtensionperlu menjadi ".csv".Di pemetaan aktivitas Salin, konversi jenis tidak diaktifkan.

Contoh:

"activities":[

{

"name": "CopyFromDeltaLake",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delta lake input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "AzureDatabricksDeltaLakeSource",

"sqlReaderQuery": "SELECT * FROM events TIMESTAMP AS OF timestamp_expression"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Salinan bertahap dari delta lake

Saat penyimpanan atau format data sink Anda tidak cocok dengan kriteria salinan langsung, seperti yang disebutkan di bagian terakhir, aktifkan salinan bertahap bawaan menggunakan instans penyimpanan Azure sementara. Fitur penyalinan bertahap juga memberi Anda troughput yang lebih baik. Layanan mengekspor data dari Azure Databricks ke penyimpanan bertahap, kemudian menyalin data ke sink, dan akhirnya membersihkan data sementara Anda dari penyimpanan bertahap. LihatSalinan bertahapuntuk detail tentang menyalin data dengan menggunakan cara bertahap.

Untuk menggunakan fitur ini, buat layanan tertaut penyimpanan Azure Blob atau layanan tertaut Azure Data Lake Storage Gen2 yang merujuk ke akun penyimpanan sebagai penahapan sementara. Lalu tentukan propertienableStagingstagingSettingsdalam aktivitas Salin.

Catatan

Penyimpanan staging info masuk akun harus dikonfigurasikan sebelumnya dalam konfigurasi kluster Azure Databricks, pelajari lebih lanjut dari Prasyarat.

Contoh:

"activities":[

{

"name": "CopyFromDeltaLake",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delta lake input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "AzureDatabricksDeltaLakeSource",

"sqlReaderQuery": "SELECT * FROM events TIMESTAMP AS OF timestamp_expression"

},

"sink": {

"type": "<sink type>"

},

"enableStaging": true,

"stagingSettings": {

"linkedServiceName": {

"referenceName": "MyStagingStorage",

"type": "LinkedServiceReference"

},

"path": "mystagingpath"

}

}

}

]

Delta lake sebagai sink

Untuk menyalin data dari Azure Databricks Delta Lake, properti berikut ini didukung di bagian sinkaktivitas Salin.

| Properti | Deskripsi | Wajib |

|---|---|---|

| jenis | Properti jenis sink aktivitas Salin, diatur ke AzureDatabricksDeltaLakeSink. | Ya |

| preCopyScript | Tentukan kueri SQL untuk aktivitas Salin yang akan dijalankan sebelum menulis data ke dalam delta Databricks di setiap eksekusi. Misalnya : VACUUM eventsTable DRY RUN Anda dapat menggunakan properti ini untuk membersihkan data yang dimuat sebelumnya, atau menambahkan tabel terpotong atau pernyataan Vakum. |

No |

| importSettings | Pengaturan tingkat lanjut digunakan untuk menulis data ke tabel. | No |

Di bawah importSettings: |

||

| jenis | Jenis perintah impor, diatur ke AzureDatabricksDeltaLakeImportCommand. | Ya |

| dateFormat | Format untai (karakter) ke jenis tanggal dengan format tanggal. Format tanggal kustom mengikuti format pada pola tanggalwaktu. Jika tidak ditentukan, ia menggunakan nilai default yyyy-MM-dd. |

No |

| timestampFormat | Format untai (karakter) untuk jenis tanda waktu dengan format tanda waktu. Format tanggal kustom mengikuti format pada pola tanggalwaktu. Jika tidak ditentukan, ia menggunakan nilai default yyyy-MM-dd'T'HH:mm:ss[.SSS][XXX]. |

No |

Salin langsung ke delta lake

Jika penyimpanan data dan format sumber Anda memenuhi kriteria yang dijelaskan di bagian ini, Anda dapat menggunakan aktivitas Salin untuk langsung menyalin dari sumber ke Azure Databricks Delta Lake. Layanan memeriksa pengaturan dan gagal menjalankan aktivitas Salin jika kriteria berikut tidak terpenuhi:

Layanan yang ditautkan sumber adalah penyimpanan Azure Blob atau Azure Data Lake Storage Gen2. Info masuk akun harus dikonfigurasikan sebelumnya dalam konfigurasi kluster Azure Databricks, pelajari lebih lanjut dari Prasyarat.

Format data sumber adalah Parquet, teks yang dibatasi, atau Avro dengan konfigurasi berikut, dan menunjuk ke folder alih-alih file.

- Untuk formatParquet, kodek pemadatan none, snappy,, atau gzip.

- Untuk format teks yang dibatasi:

rowDelimiteradalah default, atau karakter tunggal apa pun.compressionbisa jadi none, bzip2, gzip.encodingNameUTF-7 tidak didukung.

- Untuk format Avro, kodek pemadatan adalah none, deflate, atau snappy.

Di sumber aktivitas Salin:

wildcardFileNamehanya berisi kartubebas*tetapi tidak?, danwildcardFolderNametidak ditentukan.prefix,modifiedDateTimeStart,modifiedDateTimeEnd, danenablePartitionDiscoverytidak ditentukan.additionalColumnstidak ditetapkan.

Di pemetaan aktivitas Salin, konversi jenis tidak diaktifkan.

Contoh:

"activities":[

{

"name": "CopyToDeltaLake",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Delta lake output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "AzureDatabricksDeltaLakeSink",

"sqlReadrQuery": "VACUUM eventsTable DRY RUN"

}

}

}

]

Salin bertahap ke delta lake

Saat penyimpanan atau format data sumber Anda tidak cocok dengan kriteria salinan langsung, seperti yang disebutkan di bagian terakhir, aktifkan salinan bertahap bawaan menggunakan instans penyimpanan Azure sementara. Fitur penyalinan bertahap juga memberi Anda troughput yang lebih baik. Layanan secara otomatis mengonversi data untuk memenuhi persyaratan format data menjadi penyimpanan bertahap, lalu memuat data ke delta lake dari sana. Akhirnya, itu membersihkan data sementara Anda dari penyimpanan. LihatSalinan bertahapuntuk detail tentang menyalin data dengan menggunakan cara bertahap.

Untuk menggunakan fitur ini, buat layanan tertaut penyimpanan Azure Blob atau layanan tertaut Azure Data Lake Storage Gen2 yang merujuk ke akun penyimpanan sebagai penahapan sementara. Lalu tentukan propertienableStagingstagingSettingsdalam aktivitas Salin.

Catatan

Penyimpanan staging info masuk akun harus dikonfigurasikan sebelumnya dalam konfigurasi kluster Azure Databricks, pelajari lebih lanjut dari Prasyarat.

Contoh:

"activities":[

{

"name": "CopyToDeltaLake",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Delta lake output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "AzureDatabricksDeltaLakeSink"

},

"enableStaging": true,

"stagingSettings": {

"linkedServiceName": {

"referenceName": "MyStagingBlob",

"type": "LinkedServiceReference"

},

"path": "mystagingpath"

}

}

}

]

Pemantauan

Pengalaman pemantauan aktivitas salinan yang sama dengan konektor lainnya. Selain itu, karena memuat data dari/ke delta lake berjalan pada kluster Azure Databricks Anda, Anda dapat lebih lanjutmelihat log kluster terperinci dan memantau performa.

Properti aktivitas pencarian

Selengkapnya tentang properti, lihat Aktivitas pencarian.

Aktivitas Pencarian dapat mengembalikan hingga 1000 baris; jika kumpulan hasil berisi lebih banyak rekaman, 1000 baris pertama akan dikembalikan.

Konten terkait

Untuk daftar penyimpanan data yang didukung sebagai sumber dan sink oleh aktivitas Salin, lihat format dan penyimpanan data yang didukung.

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk