Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

DOTYCZY: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Napiwek

Wypróbuj usługę Data Factory w usłudze Microsoft Fabric — rozwiązanie analityczne typu all-in-one dla przedsiębiorstw. Usługa Microsoft Fabric obejmuje wszystko, od przenoszenia danych do nauki o danych, analizy w czasie rzeczywistym, analizy biznesowej i raportowania. Dowiedz się, jak bezpłatnie rozpocząć nową wersję próbną !

W tym samouczku w witrynie Azure Portal utworzysz potok usługi Azure Data Factory, który wykona notes usługi Databricks w klastrze zadań usługi Databricks. Podczas wykonywania parametry usługi Azure Data Factory będą również przekazywane do notesu usługi Databricks.

Ten samouczek obejmuje następujące procedury:

Tworzenie fabryki danych.

Tworzenie potoku, który używa działania notesu usługi Databricks.

Wyzwalanie uruchomienia potoku.

Monitorowanie uruchomienia potoku.

Jeśli nie masz subskrypcji platformy Azure, przed rozpoczęciem utwórz bezpłatne konto.

Uwaga

Aby uzyskać szczegółowe informacje na temat używania działania notesu usługi Databricks, w tym używania bibliotek i przekazywania parametrów wejściowych i wyjściowych, zapoznaj się z dokumentacją działania notesu usługi Databricks.

Wymagania wstępne

- Obszar roboczy usługi Azure Databricks. Utwórz obszar roboczy usługi Databricks lub użyj istniejącego. Najpierw utworzysz notes Python w obszarze roboczym usługi Azure Databricks. Następnie wykonasz notes i przekażesz do niego parametry przy użyciu usługi Azure Data Factory.

Tworzenie fabryki danych

Uruchom przeglądarkę internetową Microsoft Edge lub Google Chrome. Obecnie interfejs użytkownika usługi Data Factory jest obsługiwany tylko przez przeglądarki internetowe Microsoft Edge i Google Chrome.

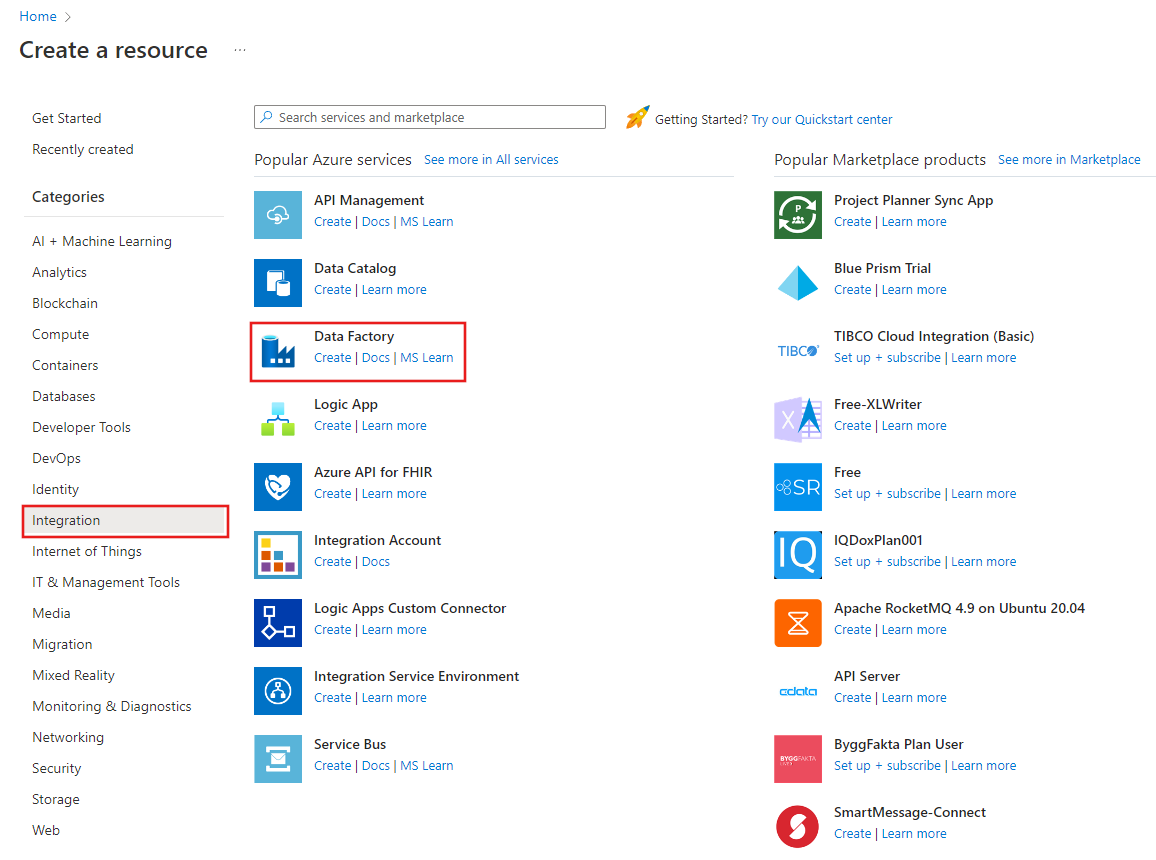

Wybierz pozycję Utwórz zasób w menu Azure Portal, a następnie wybierz pozycjęFabryka danych>:

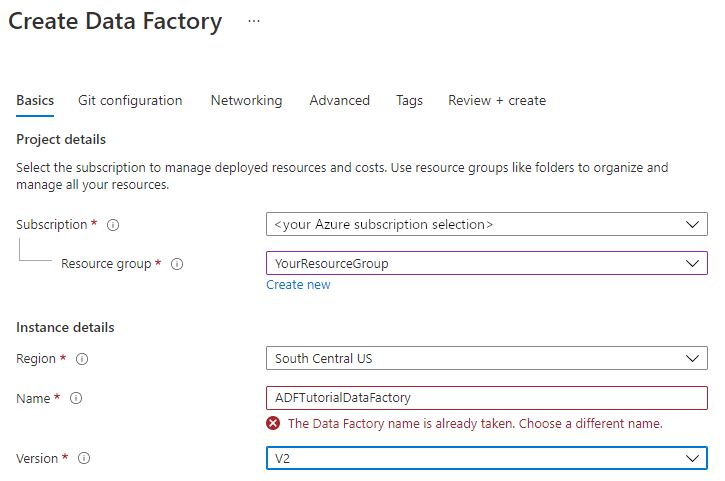

Na stronie Tworzenie fabryki danych na karcie Podstawy wybierz subskrypcję platformy Azure, w której chcesz utworzyć fabrykę danych.

W obszarze Grupa zasobów wykonaj jedną z następujących czynności:

Wybierz istniejącą grupę zasobów z listy rozwijanej.

Wybierz pozycję Utwórz nową i wprowadź nazwę nowej grupy zasobów.

Informacje na temat grup zasobów znajdują się w artykule Using resource groups to manage your Azure resources (Używanie grup zasobów do zarządzania zasobami platformy Azure).

W obszarze Region wybierz lokalizację fabryki danych.

Ta lista zawiera tylko lokalizacje, które są obsługiwane przez usługę Data Factory i w których będą przechowywane metadane usługi Azure Data Factory. Skojarzone magazyny danych (takie jak Azure Storage i Azure SQL Database) i obliczenia (takie jak Usługa Azure HDInsight), których usługa Data Factory używa, może działać w innych regionach.

W polu Nazwa wprowadź wartość ADFTutorialDataFactory.

Nazwa fabryki danych platformy Azure musi być globalnie unikatowa. Jeśli zostanie wyświetlony następujący błąd, zmień nazwę fabryki danych (na przykład użyj <nazwy>ADFTutorialDataFactory). Artykuł Usługa Data Factory — reguły nazewnictwa zawiera reguły nazewnictwa artefaktów usługi Data Factory.

W obszarze Wersja wybierz pozycję V2.

Wybierz pozycję Dalej: Konfiguracja usługi Git, a następnie zaznacz pole wyboru Skonfiguruj usługę Git później .

Wybierz pozycję Przejrzyj i utwórz, a następnie wybierz pozycję Utwórz po zakończeniu walidacji.

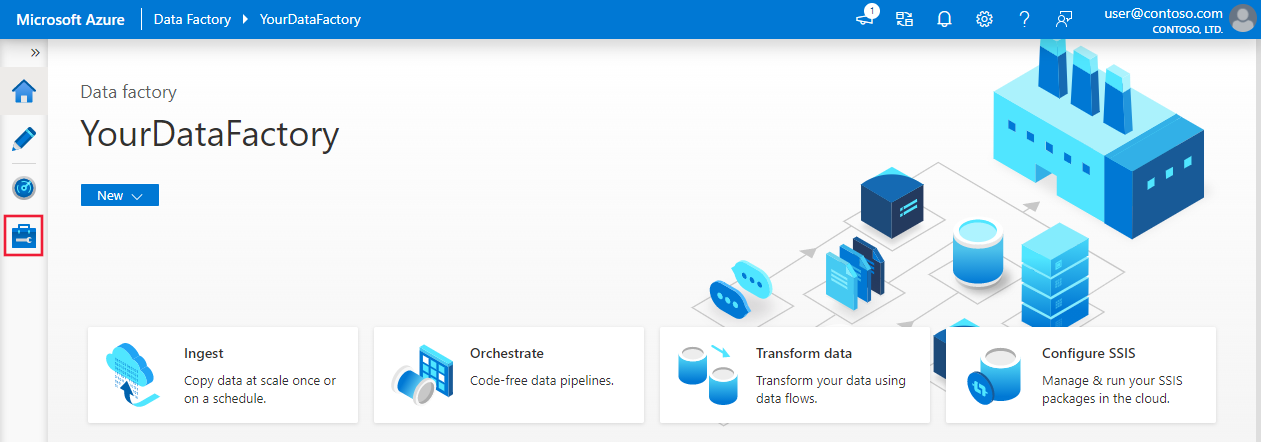

Po zakończeniu tworzenia wybierz pozycję Przejdź do zasobu , aby przejść do strony Fabryka danych . Wybierz kafelek Otwórz program Azure Data Factory Studio, aby uruchomić aplikację interfejsu użytkownika usługi Azure Data Factory na osobnej karcie przeglądarki.

Tworzenie połączonych usług

W tej sekcji utworzysz połączoną usługę Databricks. Ta połączona usługa zawiera informacje o połączeniu z klastrem usługi Databricks:

Tworzenie połączonej usługi Azure Databricks

Na stronie głównej przejdź do karty Zarządzanie w panelu po lewej stronie.

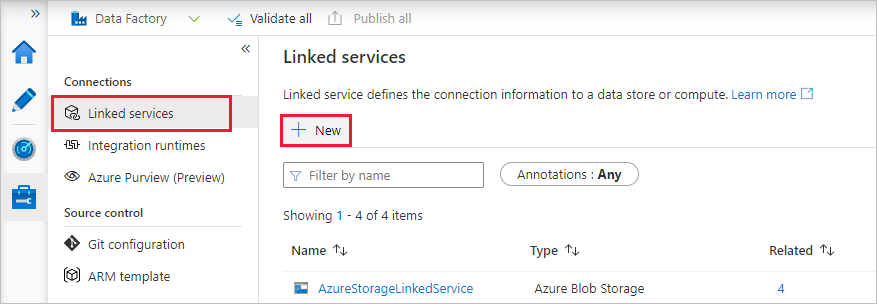

Wybierz pozycję Połączone usługi w obszarze Połączenia, a następnie wybierz pozycję + Nowy.

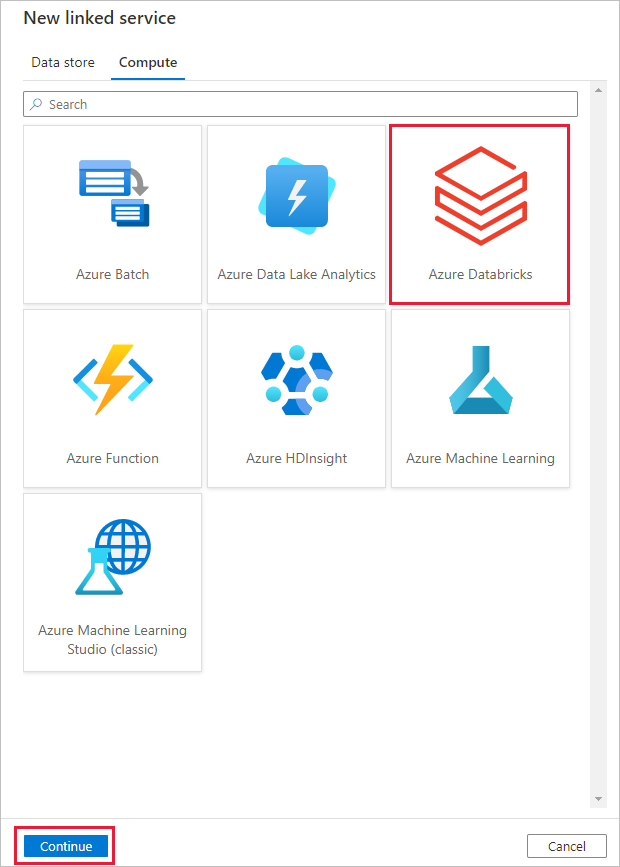

W oknie Nowa połączona usługa wybierz pozycję Compute>Azure Databricks, a następnie wybierz pozycję Kontynuuj.

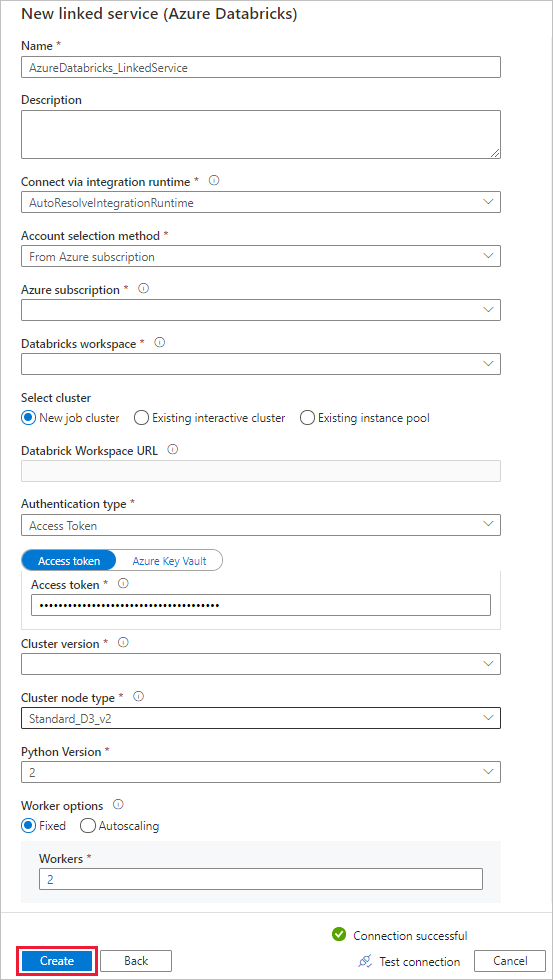

W oknie Nowa połączona usługa wykonaj następujące kroki:

W polu Nazwa wprowadź AzureDatabricks_LinkedService.

Wybierz odpowiedni obszar roboczy usługi Databricks, w którym uruchomisz notes.

W obszarze Wybierz klaster wybierz pozycję Nowy klaster zadań.

W przypadku adresu URL obszaru roboczego usługi Databricks informacje powinny być wypełniane automatycznie.

W polu Typ uwierzytelniania, jeśli wybierzesz pozycję Token dostępu, wygeneruj go z poziomu miejsca pracy usługi Azure Databricks. Procedurę można znaleźć tutaj. W przypadku tożsamości usługi zarządzanej i tożsamości zarządzanej przypisanej przez użytkownika przyznaj rolę Współautor obu tożsamościom w menu Kontrola dostępu zasobu usługi Azure Databricks.

W polu Wersja klastra wybierz wersję, której chcesz użyć.

W polu Typ węzła klastra wybierz pozycję Standard_D3_v2 w kategorii Ogólnego przeznaczenia (HDD) dla tego samouczka.

W polu Procesy robocze podaj wartość 2.

Wybierz pozycję Utwórz.

Tworzenie potoku

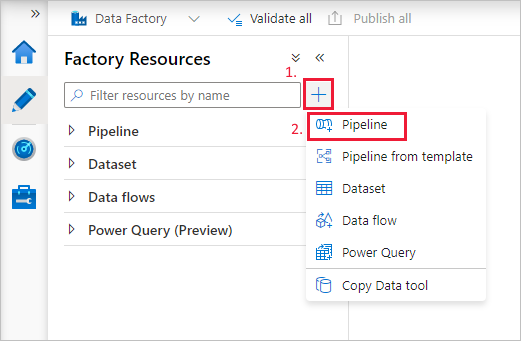

Wybierz przycisk + (znak plus), a następnie wybierz pozycję Potok w menu.

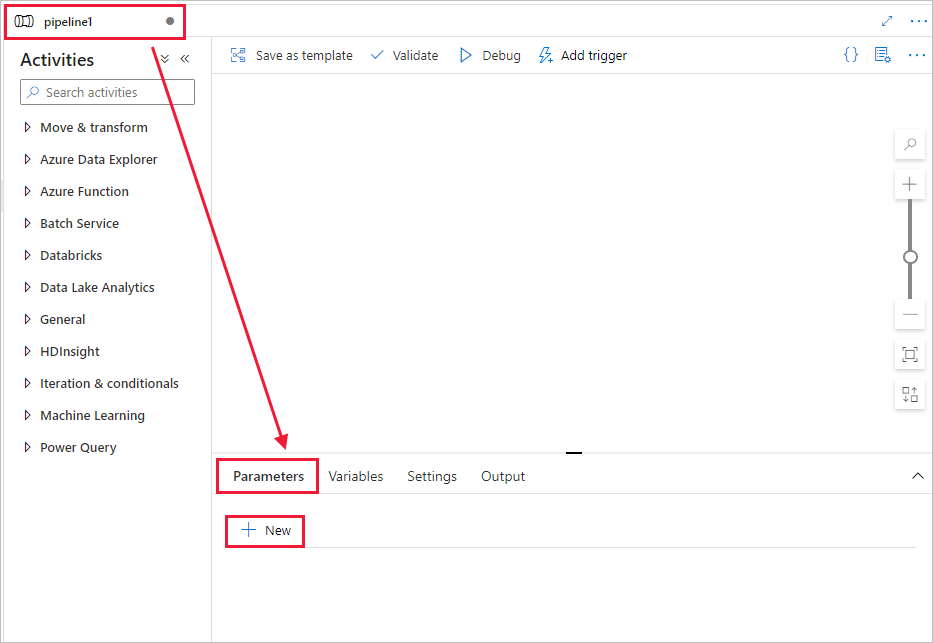

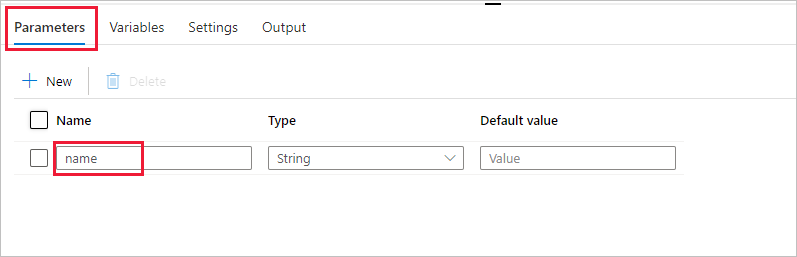

Utwórz parametr do użycia w potoku. Później przekażesz ten parametr do działania notesu usługi Databricks. W pustym potoku wybierz kartę Parametry, a następnie wybierz pozycję + Nowy i nadaj mu nazwę "name".

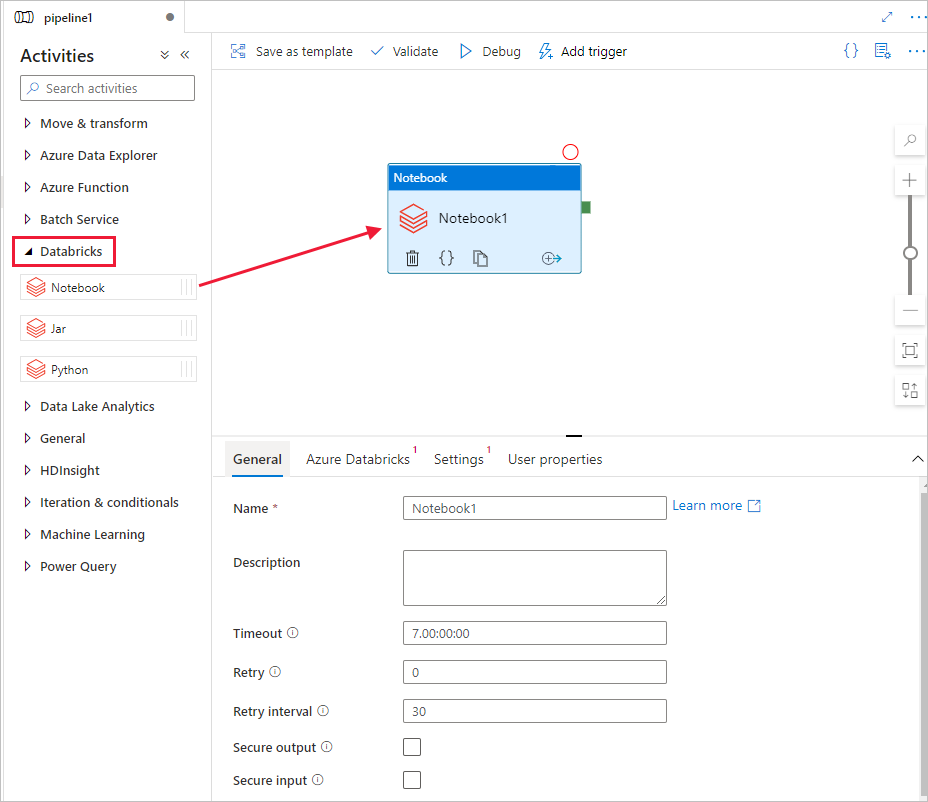

W przyborniku Działania rozwiń pozycję Databricks. Przeciągnij działanie Notes z przybornika Działania na powierzchnię projektanta potoku.

We właściwościach okna działania notesu usługi Databricksw dolnej części wykonaj następujące kroki:

Przejdź do karty Azure Databricks.

Wybierz AzureDatabricks_LinkedService (utworzoną w poprzedniej procedurze).

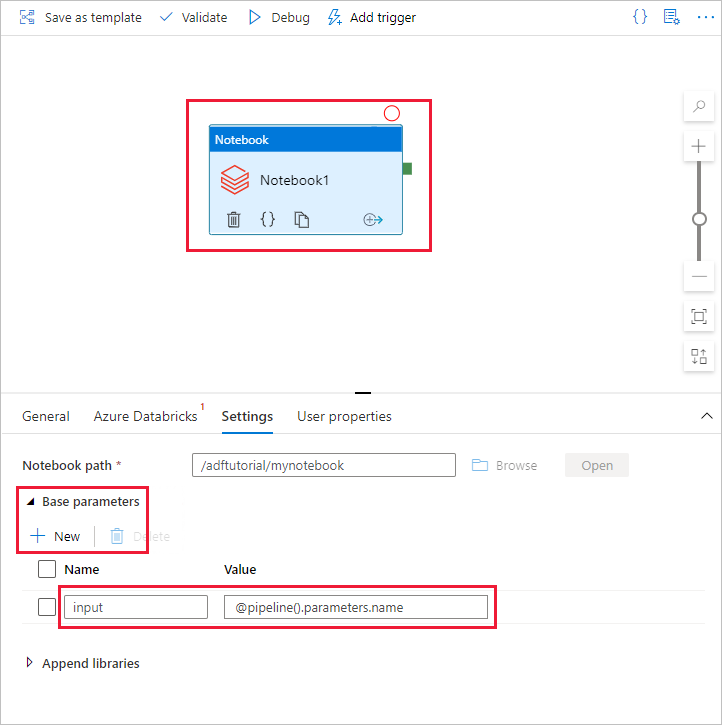

Przejdź do karty Ustawienia.

Użyj polecenia Przeglądaj, aby wybrać wartość dla pozycji Ścieżka notesu usługi Databricks. W tym miejscu utworzymy notes i określimy ścieżkę. Ścieżkę notesu można uzyskać, wykonując kilka następnych kroków.

Uruchom obszar roboczy usługi Azure Databricks.

Utwórz nowy folder w miejscu pracy i nadaj mu nazwę adftutorial.

Utwórz nowy notes. Nadajmy mu nazwę mynotebook. Kliknij prawym przyciskiem myszy folder adftutorial , a następnie wybierz polecenie Utwórz.

W nowo utworzonym notesie „mynotebook” dodaj następujący kod:

# Creating widgets for leveraging parameters, and printing the parameters dbutils.widgets.text("input", "","") y = dbutils.widgets.get("input") print ("Param -\'input':") print (y)Ścieżka notesu w tym przypadku to /adftutorial/mynotebook.

Przełącz się z powrotem do narzędzia tworzenia interfejsu użytkownika usługi Data Factory. Przejdź do karty Ustawienia w działaniu Notebook1 .

a. Dodaj parametr do działania Notes. Użyj tego samego parametru, który został dodany wcześniej do potoku.

b. Nadaj parametrowi nazwę input i podaj wartość jako wyrażenie @pipeline().parameters.name.

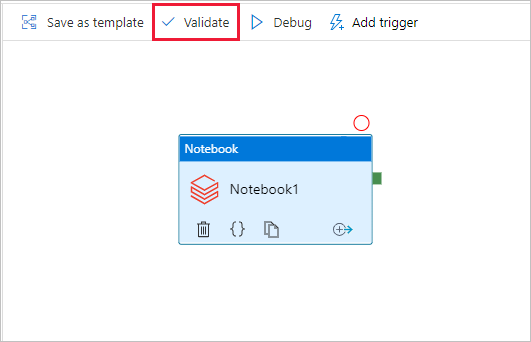

Aby zweryfikować potok, wybierz przycisk Weryfikuj na pasku narzędzi. Aby zamknąć okno weryfikacji, wybierz przycisk Zamknij .

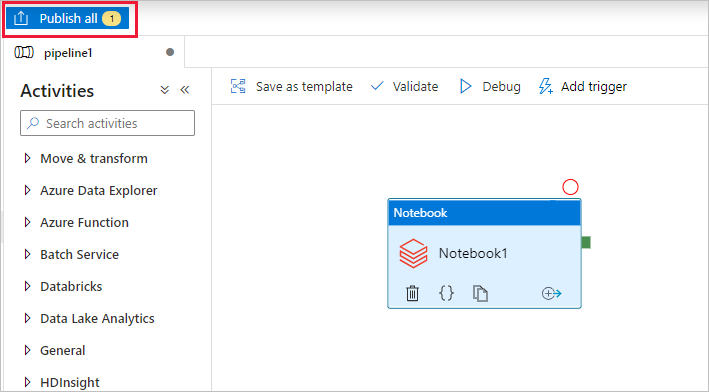

Wybierz opcję Publikuj wszystko. Interfejs użytkownika usługi Data Factory publikuje jednostki (połączone usług i potok) do usługi Azure Data Factory.

Wyzwalanie uruchomienia potoku

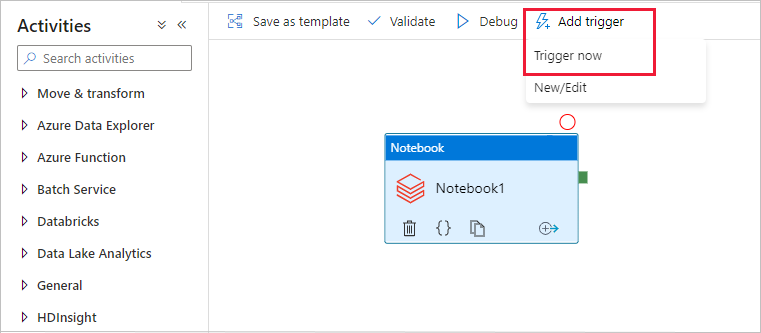

Wybierz pozycję Dodaj wyzwalacz na pasku narzędzi, a następnie wybierz pozycję Wyzwól teraz.

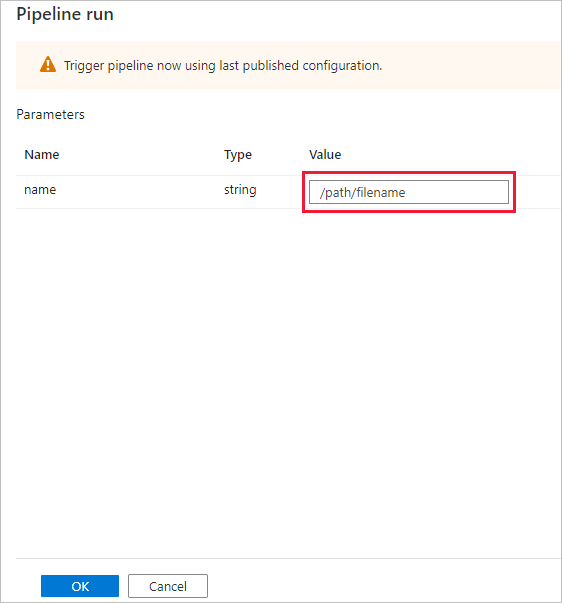

W oknie dialogowym Uruchamianie potoku zostanie wyświetlony monit o podanie parametru name . Jako parametru użyj w tym miejscu wartości /path/filename. Wybierz przycisk OK.

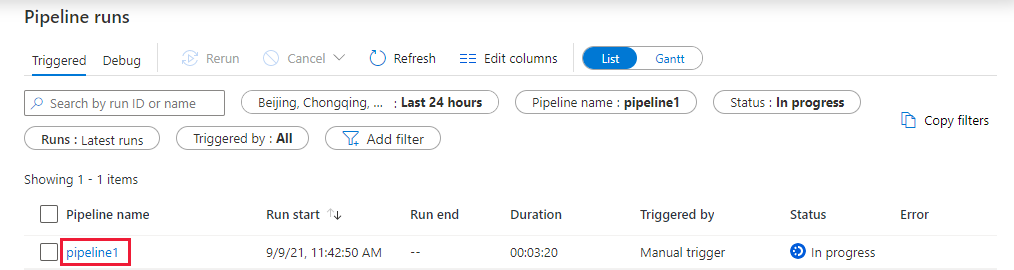

Monitorowanie działania potoku

Przejdź do karty Monitorowanie . Upewnij się, że zostanie wyświetlony przebieg potoku. Utworzenie klastra zadań usługi Databricks, w którym jest wykonywany notes, trwa około 5–8 minut.

Okresowo wybieraj pozycję Odśwież, aby sprawdzić stan uruchomienia potoku.

Aby wyświetlić uruchomienia działań skojarzone z uruchomieniem potoku, wybierz link pipeline1 w kolumnie Nazwa potoku.

Na stronie Uruchomienia działania wybierz pozycję Dane wyjściowe w kolumnie Nazwa działania, aby wyświetlić dane wyjściowe każdego działania, a link do dzienników usługi Databricks można znaleźć w okienku Dane, aby uzyskać bardziej szczegółowe dzienniki platformy Spark.

Możesz wrócić do widoku przebiegów potoku, wybierając link Wszystkie uruchomienia potoku w menu linku do stron nadrzędnych u góry strony.

Sprawdzanie danych wyjściowych

Możesz zalogować się do obszaru roboczego usługi Azure Databricks, przejść do pozycji Uruchomienia zadań i zobaczyć stan zadania jako oczekujące na wykonanie, uruchomienie lub zakończenie.

Możesz wybrać nazwę zadania i przejść, aby wyświetlić dalsze szczegóły. Po pomyślnym uruchomieniu można sprawdzić poprawność przekazanych parametrów i dane wyjściowe notesu Python.

Podsumowanie

Potok w tym przykładzie wyzwala działanie notesu usługi Databricks i przekazuje do niego parametr. W tym samouczku omówiono:

Tworzenie fabryki danych.

Tworzenie potoku, który używa działania notesu usługi Databricks.

Wyzwalanie uruchomienia potoku.

Monitorowanie uruchomienia potoku.