Kopiera och transformera data i Amazon Simple Storage Service med Hjälp av Azure Data Factory eller Azure Synapse Analytics

GÄLLER FÖR:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

Den här artikeln beskriver hur du använder kopieringsaktivitet för att kopiera data från Amazon Simple Storage Service (Amazon S3) och använder Data Flow för att transformera data i Amazon S3. Mer information finns i introduktionsartiklarna för Azure Data Factory och Synapse Analytics.

Dricks

Mer information om scenariot för datamigrering från Amazon S3 till Azure Storage finns i Migrera data från Amazon S3 till Azure Storage.

Funktioner som stöds

Den här Amazon S3-anslutningsappen stöds för följande funktioner:

| Funktioner som stöds | IR |

|---|---|

| Kopieringsaktivitet (källa/-) | (1) (2) |

| Mappa dataflöde (källa/mottagare) | (1) |

| Sökningsaktivitet | (1) (2) |

| GetMetadata-aktivitet | (1) (2) |

| Ta bort aktivitet | (1) (2) |

(1) Azure Integration Runtime (2) Lokalt installerad integrationskörning

Mer specifikt stöder den här Amazon S3-anslutningsappen kopiering av filer som är eller parsning av filer med de filformat och komprimeringskodex som stöds. Du kan också välja att bevara filmetadata under kopiering. Anslutningsappen använder AWS Signature Version 4 för att autentisera begäranden till S3.

Dricks

Om du vill kopiera data från en S3-kompatibel lagringsprovider läser du Amazon S3 Compatible Storage.

Behörigheter som krävs

Om du vill kopiera data från Amazon S3 kontrollerar du att du har beviljats följande behörigheter för Amazon S3-objektåtgärder: s3:GetObject och s3:GetObjectVersion.

Om du använder Data Factory-användargränssnittet för att skapa krävs ytterligare s3:ListAllMyBuckets behörigheter och s3:ListBucket/s3:GetBucketLocation behörigheter för åtgärder som att testa anslutningen till den länkade tjänsten och bläddra från roten. Om du inte vill bevilja dessa behörigheter kan du välja "Testa anslutning till filsökväg" eller "Bläddra från angiven sökväg" från användargränssnittet.

Den fullständiga listan över Amazon S3-behörigheter finns i Ange behörigheter i en princip på AWS-webbplatsen.

Komma igång

Om du vill utföra kopieringsaktiviteten med en pipeline kan du använda något av följande verktyg eller SDK:er:

- Verktyget Kopiera data

- Azure-portalen

- The .NET SDK

- The Python SDK

- Azure PowerShell

- REST-API:et

- Azure Resource Manager-mallen

Skapa en länkad Amazon Simple Storage Service -tjänst (S3) med hjälp av användargränssnittet

Använd följande steg för att skapa en länkad Amazon S3-tjänst i Azure-portalens användargränssnitt.

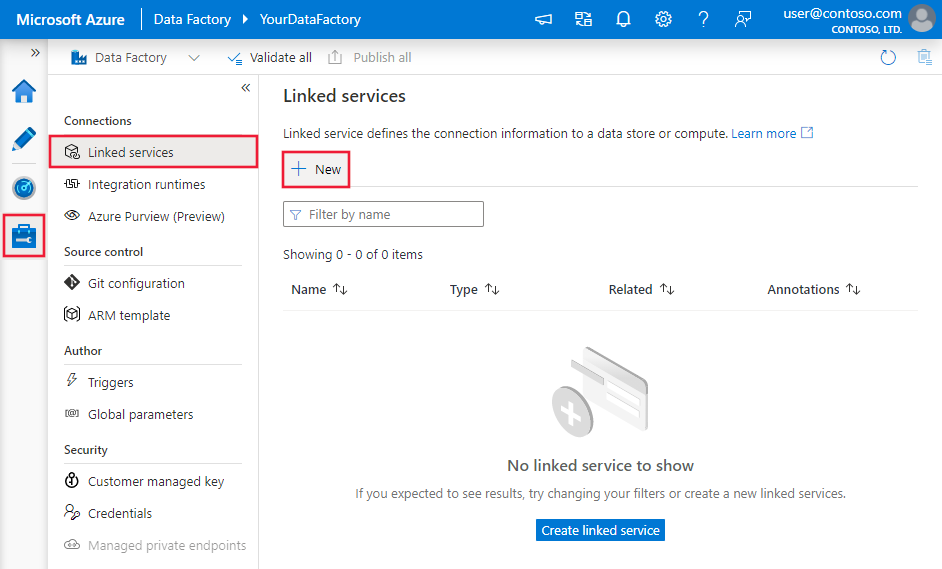

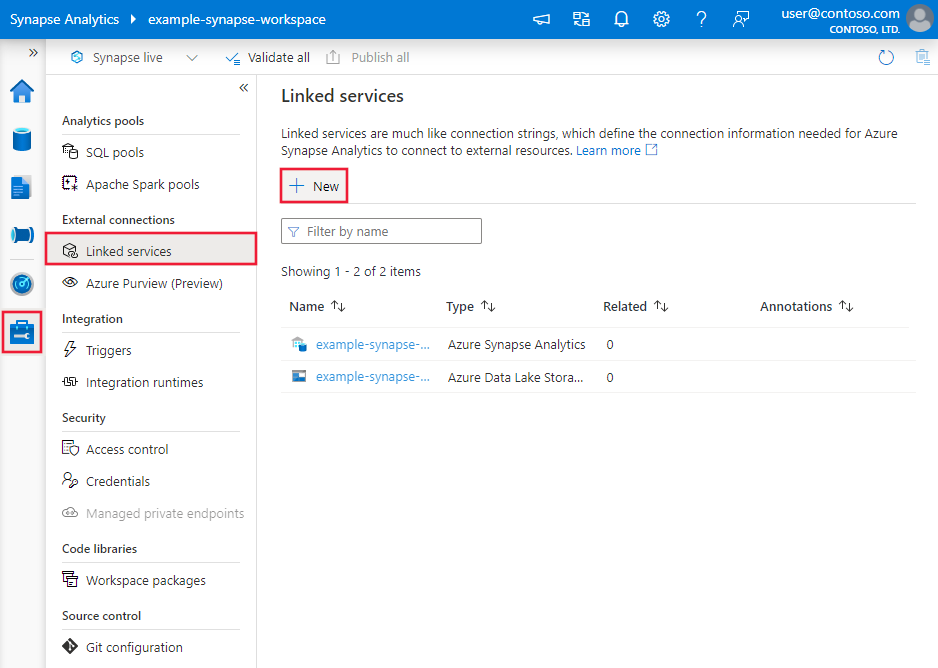

Bläddra till fliken Hantera i Din Azure Data Factory- eller Synapse-arbetsyta och välj Länkade tjänster och klicka sedan på Ny:

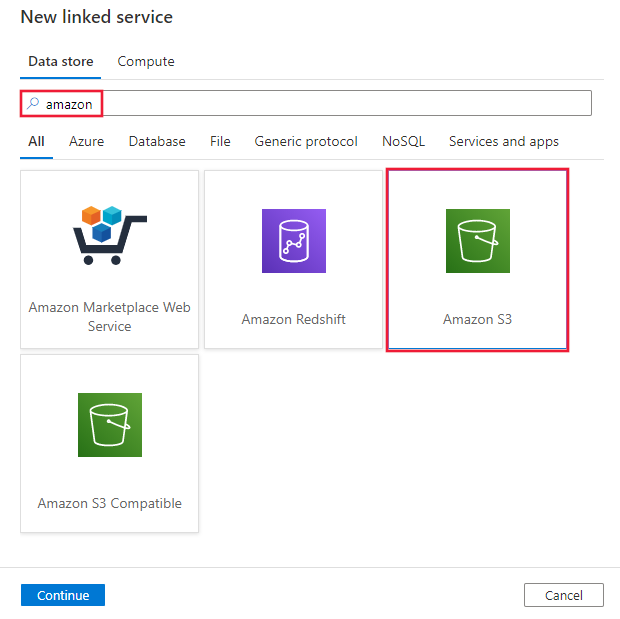

Sök efter Amazon och välj Amazon S3-anslutningsappen.

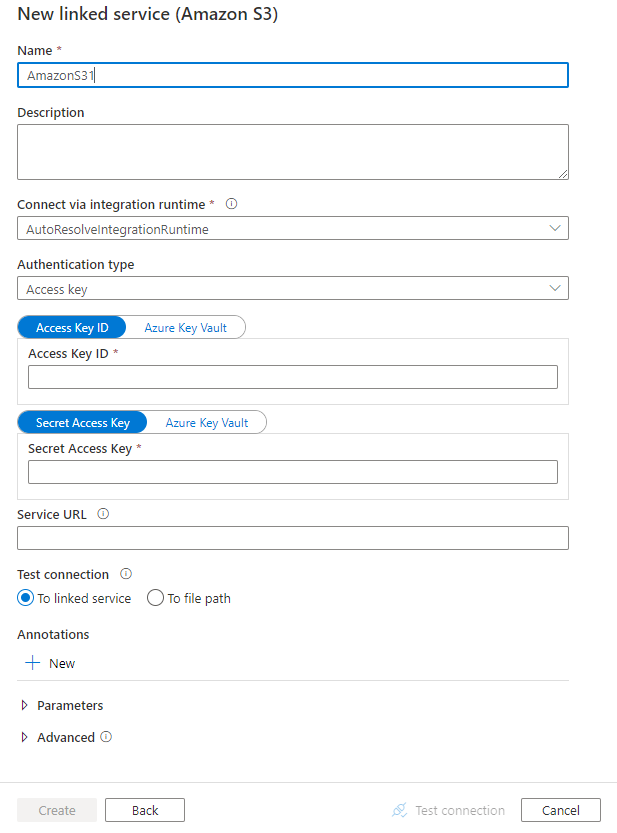

Konfigurera tjänstinformationen, testa anslutningen och skapa den nya länkade tjänsten.

Konfigurationsinformation för anslutningsprogram

Följande avsnitt innehåller information om egenskaper som används för att definiera Data Factory-entiteter som är specifika för Amazon S3.

Länkade tjänstegenskaper

Följande egenskaper stöds för en länkad Amazon S3-tjänst:

| Property | Beskrivning | Obligatoriskt |

|---|---|---|

| type | Typegenskapen måste vara inställd på AmazonS3. | Ja |

| authenticationType | Ange den autentiseringstyp som används för att ansluta till Amazon S3. Du kan välja att använda åtkomstnycklar för ett IAM-konto (AWS Identity and Access Management) eller tillfälliga säkerhetsautentiseringsuppgifter. Tillåtna värden är: AccessKey (standard) och TemporarySecurityCredentials. |

Nej |

| accessKeyId | ID för den hemliga åtkomstnyckeln. | Ja |

| secretAccessKey | Själva den hemliga åtkomstnyckeln. Markera det här fältet som en SecureString för att lagra det på ett säkert sätt eller referera till en hemlighet som lagras i Azure Key Vault. | Ja |

| sessionToken | Gäller vid användning av tillfällig autentiseringsuppgifter för säkerhet. Lär dig hur du begär tillfälliga säkerhetsautentiseringsuppgifter från AWS. Observera att tillfälliga AWS-autentiseringsuppgifter upphör att gälla mellan 15 minuter och 36 timmar baserat på inställningarna. Kontrollera att dina autentiseringsuppgifter är giltiga när aktiviteten körs, särskilt för operationaliserad arbetsbelastning, till exempel kan du uppdatera den regelbundet och lagra den i Azure Key Vault. Markera det här fältet som en SecureString för att lagra det på ett säkert sätt eller referera till en hemlighet som lagras i Azure Key Vault. |

Nej |

| serviceUrl | Ange den anpassade S3-slutpunkten https://<service url>.Ändra den bara om du vill prova en annan tjänstslutpunkt eller vill växla mellan https och http. |

Nej |

| connectVia | Den integrationskörning som ska användas för att ansluta till datalagret. Du kan använda Azure Integration Runtime eller integrationskörningen med egen värd (om ditt datalager finns i ett privat nätverk). Om den här egenskapen inte har angetts använder tjänsten standardkörningen för Azure-integrering. | Nej |

Exempel: använda åtkomstnyckelautentisering

{

"name": "AmazonS3LinkedService",

"properties": {

"type": "AmazonS3",

"typeProperties": {

"accessKeyId": "<access key id>",

"secretAccessKey": {

"type": "SecureString",

"value": "<secret access key>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Exempel: använda tillfällig autentisering av säkerhetsautentiseringsuppgifter

{

"name": "AmazonS3LinkedService",

"properties": {

"type": "AmazonS3",

"typeProperties": {

"authenticationType": "TemporarySecurityCredentials",

"accessKeyId": "<access key id>",

"secretAccessKey": {

"type": "SecureString",

"value": "<secret access key>"

},

"sessionToken": {

"type": "SecureString",

"value": "<session token>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Egenskaper för datauppsättning

En fullständig lista över avsnitt och egenskaper som är tillgängliga för att definiera datauppsättningar finns i artikeln Datauppsättningar .

Azure Data Factory stöder följande filformat. Se varje artikel för formatbaserade inställningar.

- Avro-format

- Binärt format

- Avgränsat textformat

- Excel-format

- JSON-format

- ORC-format

- Parquet-format

- XML-format

Följande egenskaper stöds för Amazon S3 under location inställningar i en formatbaserad datauppsättning:

| Property | Beskrivning | Obligatoriskt |

|---|---|---|

| type | Typegenskapen under location i en datauppsättning måste anges till AmazonS3Location. |

Ja |

| bucketName | S3-bucketnamnet. | Ja |

| folderPath | Sökvägen till mappen under den angivna bucketen. Om du vill använda ett jokertecken för att filtrera mappen hoppar du över den här inställningen och anger det i inställningarna för aktivitetskällan. | Nej |

| fileName | Filnamnet under den angivna bucketen och mappsökvägen. Om du vill använda ett jokertecken för att filtrera filer hoppar du över den här inställningen och anger det i inställningarna för aktivitetskällan. | Nej |

| version | Versionen av S3-objektet, om S3-versionshantering är aktiverat. Om den inte har angetts hämtas den senaste versionen. | Nej |

Exempel:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<Amazon S3 linked service name>",

"type": "LinkedServiceReference"

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ],

"typeProperties": {

"location": {

"type": "AmazonS3Location",

"bucketName": "bucketname",

"folderPath": "folder/subfolder"

},

"columnDelimiter": ",",

"quoteChar": "\"",

"firstRowAsHeader": true,

"compressionCodec": "gzip"

}

}

}

Kopiera egenskaper för aktivitet

En fullständig lista över avsnitt och egenskaper som är tillgängliga för att definiera aktiviteter finns i artikeln Pipelines . Det här avsnittet innehåller en lista över egenskaper som Amazon S3-källan stöder.

Amazon S3 som källtyp

Azure Data Factory stöder följande filformat. Se varje artikel för formatbaserade inställningar.

- Avro-format

- Binärt format

- Avgränsat textformat

- Excel-format

- JSON-format

- ORC-format

- Parquet-format

- XML-format

Följande egenskaper stöds för Amazon S3 under storeSettings inställningar i en formatbaserad kopieringskälla:

| Property | Beskrivning | Obligatoriskt |

|---|---|---|

| type | Typegenskapen under storeSettings måste anges till AmazonS3ReadSettings. |

Ja |

| Leta upp filerna som ska kopieras: | ||

| ALTERNATIV 1: statisk sökväg |

Kopiera från den angivna bucketen eller mapp-/filsökvägen som anges i datauppsättningen. Om du vill kopiera alla filer från en bucket eller mapp anger du wildcardFileName dessutom som *. |

|

| ALTERNATIV 2: S3-prefix -prefix |

Prefix för S3-nyckelnamnet under den angivna bucketen som konfigurerats i en datauppsättning för att filtrera S3-källfiler. S3-nycklar vars namn börjar med bucket_in_dataset/this_prefix är markerade. Den använder S3-filtret på tjänstsidan, vilket ger bättre prestanda än ett jokerteckenfilter.När du använder prefix och väljer att kopiera till filbaserad mottagare med bevarad hierarki, bör du notera att undersökvägen efter den sista "/" i prefixet bevaras. Du har till exempel källan bucket/folder/subfolder/file.txtoch konfigurerar prefixet som folder/sub, och sedan är subfolder/file.txtden bevarade filsökvägen . |

Nej |

| ALTERNATIV 3: jokertecken - jokerteckenFolderPath |

Mappsökvägen med jokertecken under den angivna bucketen som konfigurerats i en datauppsättning för att filtrera källmappar. Tillåtna jokertecken är: * (matchar noll eller fler tecken) och ? (matchar noll eller enskilt tecken). Använd ^ för att fly om mappnamnet har ett jokertecken eller det här escape-tecknet inuti. Se fler exempel i exempel på mapp- och filfilter. |

Nej |

| ALTERNATIV 3: jokertecken - jokerteckenFileName |

Filnamnet med jokertecken under den angivna bucket- och mappsökvägen (eller sökvägen till jokerteckenmappen) för att filtrera källfiler. Tillåtna jokertecken är: * (matchar noll eller fler tecken) och ? (matchar noll eller enskilt tecken). Använd ^ för att fly om filnamnet har ett jokertecken eller det här escape-tecknet inuti. Se fler exempel i exempel på mapp- och filfilter. |

Ja |

| ALTERNATIV 4: en lista över filer – fileListPath |

Anger att en angiven filuppsättning ska kopieras. Peka på en textfil som innehåller en lista över filer som du vill kopiera, en fil per rad, vilket är den relativa sökvägen till sökvägen som konfigurerats i datauppsättningen. När du använder det här alternativet ska du inte ange något filnamn i datauppsättningen. Se fler exempel i fillisteexempel. |

Nej |

| Ytterligare inställningar: | ||

| rekursiv | Anger om data läse rekursivt från undermapparna eller endast från den angivna mappen. Observera att när rekursivt är inställt på sant och mottagaren är ett filbaserat arkiv kopieras eller skapas inte en tom mapp eller undermapp i mottagaren. Tillåtna värden är sanna (standard) och falska. Den här egenskapen gäller inte när du konfigurerar fileListPath. |

Nej |

| deleteFilesAfterCompletion | Anger om de binära filerna kommer att tas bort från källarkivet när de har flyttats till målarkivet. Filborttagningen är per fil, så när kopieringsaktiviteten misslyckas ser du att vissa filer redan har kopierats till målet och tagits bort från källan, medan andra fortfarande finns kvar i källarkivet. Den här egenskapen är endast giltig i scenariot med kopiering av binära filer. Standardvärdet: false. |

Nej |

| modifiedDatetimeStart | Filer filtreras baserat på attributet: senast ändrad. Filerna väljs om deras senaste ändringstid är större än eller lika med modifiedDatetimeStart och mindre än modifiedDatetimeEnd. Tiden tillämpas på en UTC-tidszon i formatet "2018-12-01T05:00:00Z". Egenskaperna kan vara NULL, vilket innebär att inget filattributfilter tillämpas på datamängden. När modifiedDatetimeStart har ett datetime-värde men modifiedDatetimeEnd är NULL väljs de filer vars senast ändrade attribut är större än eller lika med datetime-värdet. När modifiedDatetimeEnd har ett datetime-värde men modifiedDatetimeStart är NULL väljs de filer vars senast ändrade attribut är mindre än datetime-värdet.Den här egenskapen gäller inte när du konfigurerar fileListPath. |

Nej |

| modifiedDatetimeEnd | Samma som ovan. | Nej |

| enablePartitionDiscovery | För filer som är partitionerade anger du om partitionerna ska parsas från filsökvägen och lägga till dem som ytterligare källkolumner. Tillåtna värden är false (standard) och true. |

Nej |

| partitionRootPath | När partitionsidentifiering är aktiverat anger du den absoluta rotsökvägen för att läsa partitionerade mappar som datakolumner. Om det inte anges, som standard, – När du använder filsökvägen i datauppsättningen eller listan över filer på källan är partitionsrotsökvägen den sökväg som konfigurerats i datauppsättningen. – När du använder mappfilter för jokertecken är partitionsrotsökvägen undersökvägen före det första jokertecknet. – När du använder prefixet är partitionsrotsökvägen undersökvägen före den sista "/". Anta till exempel att du konfigurerar sökvägen i datauppsättningen som "root/folder/year=2020/month=08/day=27": – Om du anger partitionsrotsökväg som "root/folder/year=2020" genererar kopieringsaktiviteten ytterligare två kolumner month och day med värdet "08" respektive "27", utöver kolumnerna i filerna.– Om partitionsrotsökvägen inte har angetts genereras ingen extra kolumn. |

Nej |

| maxConcurrentConnections | Den övre gränsen för samtidiga anslutningar som upprättats till datalagret under aktivitetskörningen. Ange endast ett värde när du vill begränsa samtidiga anslutningar. | Nej |

Exempel:

"activities":[

{

"name": "CopyFromAmazonS3",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"formatSettings":{

"type": "DelimitedTextReadSettings",

"skipLineCount": 10

},

"storeSettings":{

"type": "AmazonS3ReadSettings",

"recursive": true,

"wildcardFolderPath": "myfolder*A",

"wildcardFileName": "*.csv"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Exempel på mapp- och filfilter

I det här avsnittet beskrivs det resulterande beteendet för mappsökvägen och filnamnet med jokerteckenfilter.

| hink | key | rekursiv | Källmappens struktur och filterresultat (filer i fetstil hämtas) |

|---|---|---|---|

| hink | Folder*/* |

falskt | hink MappA File1.csv File2.json Undermapp1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

| hink | Folder*/* |

true | hink MappA File1.csv File2.json Undermapp1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

| hink | Folder*/*.csv |

falskt | hink MappA File1.csv File2.json Undermapp1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

| hink | Folder*/*.csv |

true | hink MappA File1.csv File2.json Undermapp1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Exempel på fillista

I det här avsnittet beskrivs det resulterande beteendet med att använda en fillistesökväg i en kopieringsaktivitetskälla.

Anta att du har följande källmappstruktur och vill kopiera filerna i fetstil:

| Exempel på källstruktur | Innehåll i FileListToCopy.txt | Konfiguration |

|---|---|---|

| hink MappA File1.csv File2.json Undermapp1 File3.csv File4.json File5.csv Metadata FileListToCopy.txt |

File1.csv Undermapp1/File3.csv Undermapp1/File5.csv |

I datauppsättning: -Hink: bucket– Mappsökväg: FolderAI Kopieringsaktivitetskälla: – Sökväg till fillista: bucket/Metadata/FileListToCopy.txt Sökvägen till fillistan pekar på en textfil i samma datalager som innehåller en lista över filer som du vill kopiera, en fil per rad, med den relativa sökvägen till sökvägen som konfigurerats i datauppsättningen. |

Bevara metadata under kopiering

När du kopierar filer från Amazon S3 till Azure Data Lake Storage Gen2 eller Azure Blob Storage kan du välja att bevara filmetadata tillsammans med data. Läs mer från Bevara metadata.

Mappa dataflödesegenskaper

När du transformerar data i mappning av dataflöden kan du läsa filer från Amazon S3 i följande format:

Formatspecifika inställningar finns i dokumentationen för det formatet. Mer information finns i Källtransformering i mappning av dataflöde.

Källtransformering

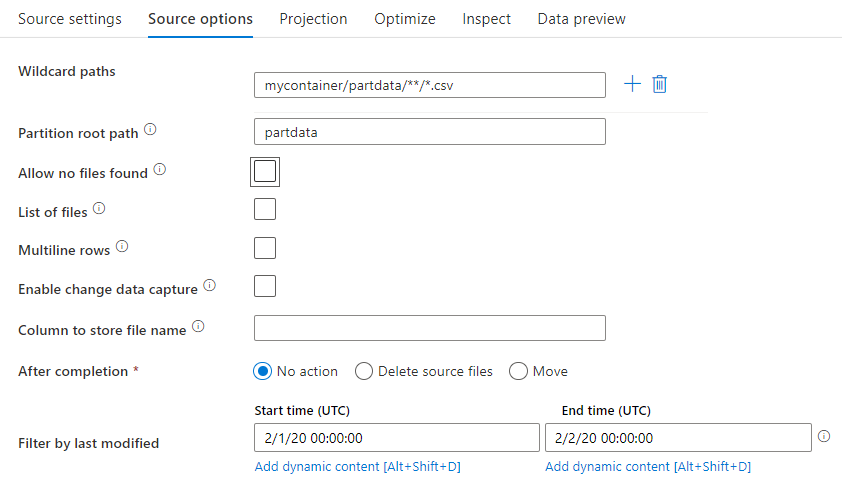

I källtransformeringen kan du läsa från en container, mapp eller enskild fil i Amazon S3. Använd fliken Källalternativ för att hantera hur filerna läss.

Sökvägar med jokertecken: Om du använder ett jokerteckensmönster instrueras tjänsten att loopa igenom varje matchande mapp och fil i en enda källtransformering. Det här är ett effektivt sätt att bearbeta flera filer i ett enda flöde. Lägg till flera matchande mönster med jokertecken med plustecknet som visas när du hovrar över ditt befintliga jokerteckenmönster.

Från källcontainern väljer du en serie filer som matchar ett mönster. Endast en container kan anges i datauppsättningen. Sökvägen till jokertecknet måste därför även innehålla mappsökvägen från rotmappen.

Jokerteckenexempel:

*Representerar alla teckenuppsättningar.**Representerar rekursiv katalogkapsling.?Ersätter ett tecken.[]Matchar ett eller flera tecken inom hakparenteserna./data/sales/**/*.csvHämtar alla .csv filer under /data/försäljning./data/sales/20??/**/Hämtar alla filer på 1900-talet./data/sales/*/*/*.csvHämtar .csv filer två nivåer under /data/försäljning./data/sales/2004/*/12/[XY]1?.csvHämtar alla .csv filer i december 2004 med X- eller Y-prefixet med ett tvåsiffrigt tal.

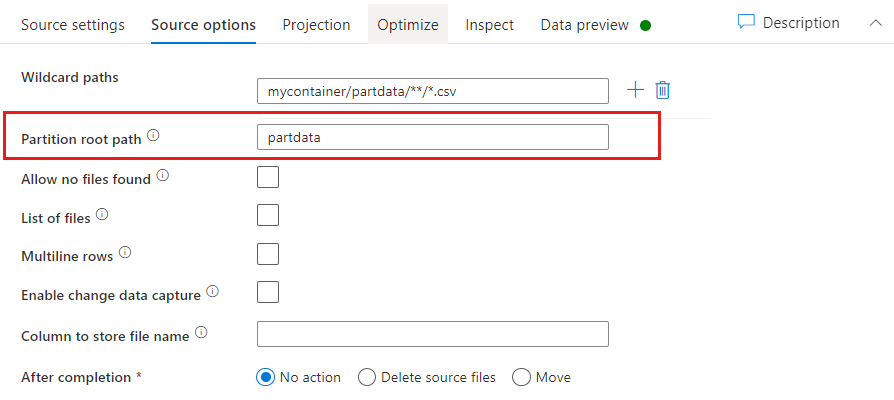

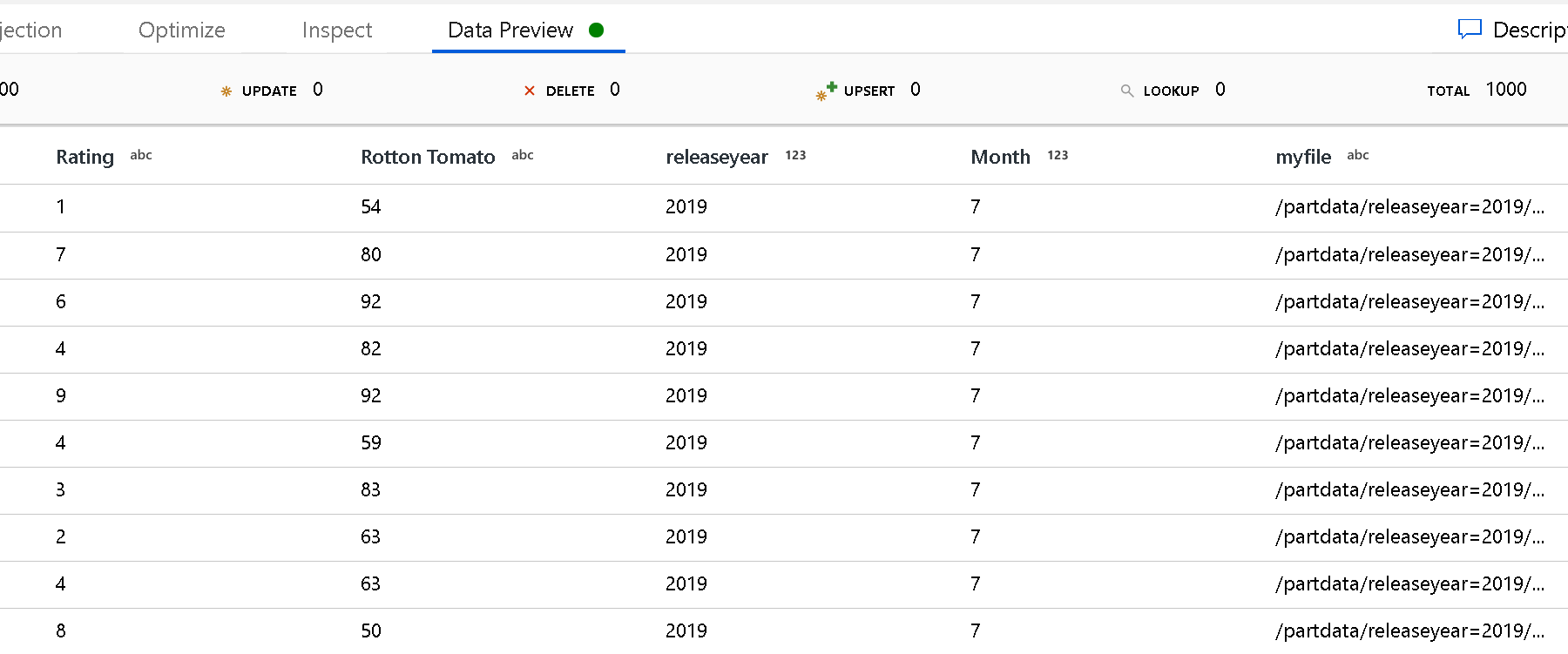

Partitionsrotsökväg: Om du har partitionerade mappar i filkällan med ett key=value format (till exempel year=2019), kan du tilldela den översta nivån i partitionsmappsträdet till ett kolumnnamn i dataflödets dataström.

Ange först ett jokertecken för att inkludera alla sökvägar som är de partitionerade mapparna plus lövfilerna som du vill läsa.

Använd inställningen Partitionsrotsökväg för att definiera vad mappstrukturens översta nivå är. När du visar innehållet i dina data via en förhandsversion av data ser du att tjänsten lägger till de matchade partitionerna som finns på var och en av dina mappnivåer.

Lista över filer: Det här är en filuppsättning. Skapa en textfil som innehåller en lista över relativa sökvägsfiler som ska bearbetas. Peka på den här textfilen.

Kolumn för lagring av filnamn: Lagra namnet på källfilen i en kolumn i dina data. Ange ett nytt kolumnnamn här för att lagra filnamnssträngen.

Efter slutförande: Välj att inte göra något med källfilen när dataflödet har körts, ta bort källfilen eller flytta källfilen. Sökvägarna för flytten är relativa.

Om du vill flytta källfiler till en annan plats efter bearbetningen väljer du först "Flytta" för filåtgärd. Ange sedan katalogen "från". Om du inte använder några jokertecken för sökvägen är inställningen "från" samma mapp som källmappen.

Om du har en källsökväg med jokertecken ser syntaxen ut så här:

/data/sales/20??/**/*.csv

Du kan ange "från" som:

/data/sales

Och du kan ange "till" som:

/backup/priorSales

I det här fallet flyttas alla filer som hämtades under /data/sales till /backup/priorSales.

Kommentar

Filåtgärder körs endast när du startar dataflödet från en pipelinekörning (en pipeline-felsökning eller körningskörning) som använder aktiviteten Kör dataflöde i en pipeline. Filåtgärder körs inte i felsökningsläge för dataflöde.

Filtrera efter senast ändrad: Du kan filtrera vilka filer du bearbetar genom att ange ett datumintervall för när de senast ändrades. Alla datetimes finns i UTC.

Egenskaper för uppslagsaktivitet

Mer information om egenskaperna finns i Sökningsaktivitet.

Egenskaper för GetMetadata-aktivitet

Mer information om egenskaperna finns i GetMetadata-aktiviteten.

Ta bort aktivitetsegenskaper

Information om egenskaperna finns i Ta bort aktivitet.

Äldre modeller

Kommentar

Följande modeller stöds fortfarande, precis som för bakåtkompatibilitet. Vi rekommenderar att du använder den nya modellen som nämnts tidigare. Redigeringsgränssnittet har växlat till att generera den nya modellen.

Äldre datauppsättningsmodell

| Property | Beskrivning | Obligatoriskt |

|---|---|---|

| type | Datamängdens typegenskap måste anges till AmazonS3Object. | Ja |

| bucketName | S3-bucketnamnet. Jokerteckenfiltret stöds inte. | Ja för aktiviteten Kopiera eller Uppslag, nej för Aktiviteten GetMetadata |

| key | Namn- eller jokerteckenfiltret för S3-objektnyckeln under den angivna bucketen. Gäller endast när prefixegenskapen inte har angetts. Jokerteckenfiltret stöds för både mappdelen och filnamnsdelen. Tillåtna jokertecken är: * (matchar noll eller fler tecken) och ? (matchar noll eller enskilt tecken).- Exempel 1: "key": "rootfolder/subfolder/*.csv"- Exempel 2: "key": "rootfolder/subfolder/???20180427.txt"Se fler exempel i exempel på mapp- och filfilter. Använd ^ för att fly om din faktiska mapp eller filnamn har ett jokertecken eller det här escape-tecknet inuti. |

Nej |

| prefix | Prefix för S3-objektnyckeln. Objekt vars nycklar börjar med det här prefixet är markerade. Gäller endast när nyckelegenskapen inte har angetts. | Nej |

| version | Versionen av S3-objektet, om S3-versionshantering är aktiverat. Om en version inte har angetts hämtas den senaste versionen. | Nej |

| modifiedDatetimeStart | Filer filtreras baserat på attributet: senast ändrad. Filerna väljs om deras senaste ändringstid är större än eller lika med modifiedDatetimeStart och mindre än modifiedDatetimeEnd. Tiden tillämpas på UTC-tidszonen i formatet "2018-12-01T05:00:00Z". Tänk på att om du aktiverar den här inställningen påverkas dataflyttens övergripande prestanda när du vill filtrera stora mängder filer. Egenskaperna kan vara NULL, vilket innebär att inget filattributfilter tillämpas på datamängden. När modifiedDatetimeStart har ett datetime-värde men modifiedDatetimeEnd är NULL väljs de filer vars senast ändrade attribut är större än eller lika med datetime-värdet. När modifiedDatetimeEnd har ett datetime-värde men modifiedDatetimeStart är NULL väljs de filer vars senast ändrade attribut är mindre än datetime-värdet. |

Nej |

| modifiedDatetimeEnd | Filer filtreras baserat på attributet: senast ändrad. Filerna väljs om deras senaste ändringstid är större än eller lika med modifiedDatetimeStart och mindre än modifiedDatetimeEnd. Tiden tillämpas på UTC-tidszonen i formatet "2018-12-01T05:00:00Z". Tänk på att om du aktiverar den här inställningen påverkas dataflyttens övergripande prestanda när du vill filtrera stora mängder filer. Egenskaperna kan vara NULL, vilket innebär att inget filattributfilter tillämpas på datamängden. När modifiedDatetimeStart har ett datetime-värde men modifiedDatetimeEnd är NULL väljs de filer vars senast ändrade attribut är större än eller lika med datetime-värdet. När modifiedDatetimeEnd har ett datetime-värde men modifiedDatetimeStart är NULL väljs de filer vars senast ändrade attribut är mindre än datetime-värdet. |

Nej |

| format | Om du vill kopiera filer som de är mellan filbaserade lager (binär kopia) hoppar du över formatavsnittet i både indata- och utdatauppsättningsdefinitioner. Om du vill parsa eller generera filer med ett visst format stöds följande filformattyper: TextFormat, JsonFormat, AvroFormat, OrcFormat, ParquetFormat. Ange typegenskapen under format till ett av dessa värden. Mer information finns i avsnitten Textformat, JSON-format, Avro-format, Orc-format och Parquet-format . |

Nej (endast för scenario med binär kopiering) |

| komprimering | Ange typ och komprimeringsnivå för data. Mer information finns i Filformat som stöds och komprimeringskodex. Typer som stöds är GZip, Deflate, BZip2 och ZipDeflate. Nivåerna som stöds är optimala och snabbaste. |

Nej |

Dricks

Om du vill kopiera alla filer under en mapp anger du bucketName för bucketen och prefixet för mappdelen.

Om du vill kopiera en enskild fil med ett angivet namn anger du bucketName för bucketen och nyckeln för mappdelen plus filnamnet.

Om du vill kopiera en delmängd av filer under en mapp anger du bucketName för bucketen och nyckeln för mappdelen plus jokerteckenfiltret.

Exempel: använda prefix

{

"name": "AmazonS3Dataset",

"properties": {

"type": "AmazonS3Object",

"linkedServiceName": {

"referenceName": "<Amazon S3 linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"bucketName": "testbucket",

"prefix": "testFolder/test",

"modifiedDatetimeStart": "2018-12-01T05:00:00Z",

"modifiedDatetimeEnd": "2018-12-01T06:00:00Z",

"format": {

"type": "TextFormat",

"columnDelimiter": ",",

"rowDelimiter": "\n"

},

"compression": {

"type": "GZip",

"level": "Optimal"

}

}

}

}

Exempel: använda nyckel och version (valfritt)

{

"name": "AmazonS3Dataset",

"properties": {

"type": "AmazonS3",

"linkedServiceName": {

"referenceName": "<Amazon S3 linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"bucketName": "testbucket",

"key": "testFolder/testfile.csv.gz",

"version": "XXXXXXXXXczm0CJajYkHf0_k6LhBmkcL",

"format": {

"type": "TextFormat",

"columnDelimiter": ",",

"rowDelimiter": "\n"

},

"compression": {

"type": "GZip",

"level": "Optimal"

}

}

}

}

Äldre källmodell för kopieringsaktiviteten

| Property | Beskrivning | Obligatoriskt |

|---|---|---|

| type | Typegenskapen för kopieringsaktivitetskällan måste anges till FileSystemSource. | Ja |

| rekursiv | Anger om data läse rekursivt från undermapparna eller endast från den angivna mappen. Observera att när rekursivt är inställt på sant och mottagaren är ett filbaserat arkiv kopieras eller skapas inte en tom mapp eller undermapp i mottagaren. Tillåtna värden är sanna (standard) och falska. |

Nej |

| maxConcurrentConnections | Den övre gränsen för samtidiga anslutningar som upprättats till datalagret under aktivitetskörningen. Ange endast ett värde när du vill begränsa samtidiga anslutningar. | Nej |

Exempel:

"activities":[

{

"name": "CopyFromAmazonS3",

"type": "Copy",

"inputs": [

{

"referenceName": "<Amazon S3 input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "FileSystemSource",

"recursive": true

},

"sink": {

"type": "<sink type>"

}

}

}

]

Relaterat innehåll

En lista över datalager som kopieringsaktiviteten stöder som källor och mottagare finns i Datalager som stöds.

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för