Usare R per Apache Spark

Microsoft Fabric offre il supporto R predefinito per Apache Spark. Ciò include il supporto per SparkR e sparklyr, che consente agli utenti di interagire con Spark usando interfacce Spark o R familiari. È possibile analizzare i dati usando R tramite definizioni di processi batch Spark o con notebook interattivi di Microsoft Fabric.

Questo documento offre una panoramica dello sviluppo di applicazioni Spark in Synapse tramite il linguaggio R.

Ottenere una sottoscrizione di Microsoft Fabric. In alternativa, iscriversi per ottenere una versione di valutazione di Microsoft Fabric gratuita.

Accedere a Microsoft Fabric.

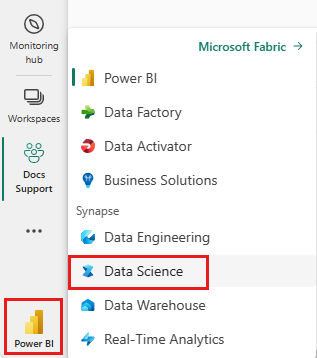

Usare l’opzione esperienza sul lato sinistro della home page per passare all'esperienza Science di Synapse.

Un notebook di Microsoft Fabric è un'interfaccia Web che consente di creare file che contengono codice in tempo reale, visualizzazioni e testo descrittivo. I notebook possono essere usati per convalidare idee ed eseguire esperimenti rapidi per ottenere informazioni cognitive dettagliate dai dati. I notebook sono anche ampiamente usati per la preparazione e la visualizzazione dei dati, l'apprendimento automatico e altri scenari di Big Data.

Per iniziare a usare R nei notebook di Microsoft Fabric, modificare il linguaggio primario impostando l'opzione del linguaggio su SparkR (R) nella parte superiore del notebook.

Inoltre, è possibile usare più linguaggi in un notebook specificando il comando magic per il linguaggio all'inizio di una cella.

%%sparkr

# Enter your R code here

Per altre informazioni sui notebook in Microsoft Fabric Analytics, vedere Come usare i notebook.

Le librerie forniscono codice riutilizzabile che può essere utile includere nei programmi o nei progetti. Per rendere il codice di terze parti o compilato localmente disponibile per le applicazioni, è possibile installare una libreria in un'area di lavoro o in una sessione di notebook.

Per altre informazioni su come gestire le librerie R, vedere Gestione delle librerie R.

Microsoft Spark Utilities (MSSparkUtils) è un pacchetto predefinito che consente di eseguire facilmente attività comuni. È possibile usare MSSparkUtils per lavorare con i file system, per ottenere variabili di ambiente, per concatenare i notebook e per lavorare con i segreti. MSSparkUtils è supportato per i notebook R.

Per iniziare, è possibile eseguire i comandi seguenti:

library(notebookutils)

mssparkutils.fs.help()

Per altre informazioni sui comandi MSSparkUtils supportati, vedere Usare utilità di Microsoft Spark.

SparkR è un pacchetto R che fornisce un front-end leggero per l'uso di Apache Spark da R. SparkR fornisce un'implementazione di frame di dati distribuita che supporta operazioni come selezione, filtro, aggregazione e così via. SparkR supporta anche l'apprendimento automatico distribuito con MLlib.

Per altre informazioni su come usare SparkR, vedere Come usare SparkR.

sparklyr è un'interfaccia R per Apache Spark. Fornisce un meccanismo per interagire con Spark usando interfacce R familiari. È possibile usare sparklyr tramite definizioni di processi batch Spark o con notebook interattivi di Microsoft Fabric.

Per altre informazioni su come usare sparklyr, vedere Come usare sparklyr.

Tidyverse è una raccolta di pacchetti R che gli scienziati dei dati usano comunemente nelle analisi quotidiane dei dati. Include pacchetti per l'importazione dei dati (readr), l'effetto di visualizzazione dei dati (ggplot2), la manipolazione dei dati (dplyr, tidyr), la programmazione funzionale (purrr), la creazione di modelli (tidymodels) e così via. I pacchetti in tidyverse sono progettati per essere usati insieme senza problemi e seguono un insieme coerente di principi di progettazione. Microsoft Fabric distribuisce la versione stabile più recente di tidyverse con ogni pubblicazione di runtime.

Per altre informazioni su come usare Tidyverse, vedere Come usare Tidyverse.

L'ecosistema R offre più librerie di grafici che sono dotate di molte funzionalità diverse. Per impostazione predefinita, ogni istanza di Spark in Microsoft Fabric contiene un set di librerie open source curate e diffuse. È anche possibile aggiungere o gestire librerie o versioni aggiuntive usando le funzionalità di gestione delle librerie di Microsoft Fabric.

Per altre informazioni su come creare visualizzazioni R, vedere Visualizzazione R.