Eventos

31 mar, 23 - 2 abr, 23

Evento de aprendizaje de Fabric, Power BI y SQL más grande. 31 de marzo – 2 de abril. Use el código FABINSIDER para ahorrar $400.

Regístrate hoyEste explorador ya no se admite.

Actualice a Microsoft Edge para aprovechar las características y actualizaciones de seguridad más recientes, y disponer de soporte técnico.

SE APLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

Importante

Este conector está en fase de finalización del soporte. Se recomienda migrar al conector ODBC mediante la instalación de un controlador.

En este artículo se explica cómo usar la actividad de copia en una canalización de Azure Data Factory o Synapse Analytics para copiar datos de HBase. El documento se basa en el artículo de introducción a la actividad de copia que describe información general de la actividad de copia.

Este conector HBase es compatible con las funcionalidades siguientes:

| Funcionalidades admitidas | IR |

|---|---|

| Actividad de copia (origen/-) | ① |

| Actividad de búsqueda | ① |

① Azure Integration Runtime ② Entorno de ejecución de integración autohospedado

Consulte la tabla de almacenes de datos compatibles para ver una lista de almacenes de datos que la actividad de copia admite como orígenes o receptores.

El servicio proporciona un controlador integrado para habilitar la conectividad. Por lo tanto, no es necesario instalar manualmente ningún controlador mediante este conector.

Si el almacén de datos es un servicio de datos en la nube administrado, puede usar Azure Integration Runtime. Si el acceso está restringido a las direcciones IP que están aprobadas en las reglas de firewall, puede agregar direcciones IP de Azure Integration Runtime a la lista de permitidos.

También puede usar la característica del entorno de ejecución de integración de red virtual administrada de Azure Data Factory para acceder a la red local sin instalar ni configurar un entorno de ejecución de integración autohospedado.

Consulte Estrategias de acceso a datos para más información sobre los mecanismos de seguridad de red y las opciones que admite Data Factory.

Para realizar la actividad de copia con una canalización, puede usar una de los siguientes herramientas o SDK:

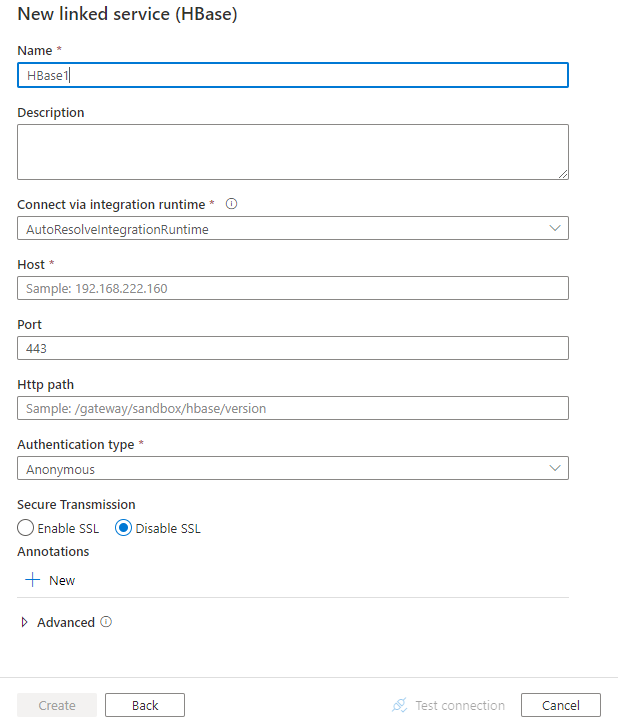

Siga estos pasos para crear un servicio vinculado a Hbase en la interfaz de usuario de Azure Portal.

Vaya a la pestaña Administrar del área de trabajo de Azure Data Factory o Synapse y seleccione Servicios vinculados; luego haga clic en Nuevo:

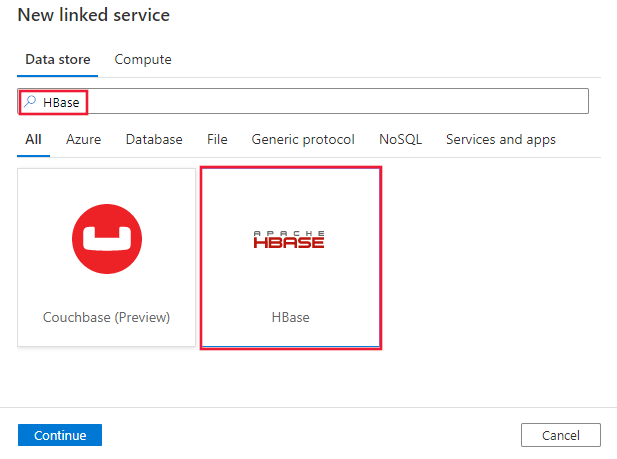

Busque Hbase y seleccione el conector de Hbase.

Configure los detalles del servicio, pruebe la conexión y cree el nuevo servicio vinculado.

En las secciones siguientes se proporcionan detalles sobre las propiedades que se usan para definir entidades de Data Factory específicas del conector de HBase.

Las siguientes propiedades son compatibles con el servicio vinculado de HBase:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type debe establecerse en: HBase | Sí |

| host | Dirección IP o nombre de host del servidor de HBase. (por ejemplo, [clustername].azurehdinsight.net, 192.168.222.160) |

Sí |

| port | Puerto TCP que el servidor de HBase utiliza para escuchar las conexiones del cliente. El valor predeterminado es 9090. Si se conecta a Azure HDInsights, especifique el puerto 443. | No |

| httpPath | La dirección URL parcial correspondiente al servidor de HBase, por ejemplo, /hbaserest0 cuando se usa el clúster de HDInsights. |

No |

| authenticationType | Mecanismo de autenticación utilizado para conectarse al servidor de HBase. Los valores permitidos son: Anonymous, Basic |

Sí |

| username | Nombre de usuario que se usa para conectarse al servidor de HBase. | No |

| password | Contraseña que corresponde al nombre de usuario. Marque este campo como SecureString para almacenarlo de forma segura, o bien haga referencia a un secreto almacenado en Azure Key Vault. | No |

| enableSsl | Especifica si las conexiones al servidor se cifran mediante TLS. El valor predeterminado es false. | No |

| trustedCertPath | Ruta de acceso completa del archivo .pem que contiene certificados de CA de confianza para comprobar el servidor al conectarse a través de TLS. Esta propiedad solo puede establecerse al utilizar TLS en IR autohospedados. El valor predeterminado es el archivo cacerts.pem instalado con el IR. | No |

| allowHostNameCNMismatch | Especifica si se requiere que el nombre del certificado TLS/SSL emitido por una CA coincida con el nombre de host del servidor al conectarse a través de TLS. El valor predeterminado es false. | No |

| allowSelfSignedServerCert | Especifica si se permiten los certificados autofirmados del servidor. El valor predeterminado es false. | No |

| connectVia | El entorno Integration Runtime que se usará para conectarse al almacén de datos. Obtenga más información en la sección Requisitos previos. Puede usar solo Azure Integration Runtime. | No |

Nota

Si el clúster no es compatible con las sesiones rápidas, como HDInsight, agregue explícitamente el índice del nodo al final de la configuración de la ruta de acceso http; por ejemplo, especifique /hbaserest0 en lugar de /hbaserest.

Ejemplo de HDInsights HBase:

{

"name": "HBaseLinkedService",

"properties": {

"type": "HBase",

"typeProperties": {

"host" : "<cluster name>.azurehdinsight.net",

"port" : "443",

"httpPath" : "/hbaserest0",

"authenticationType" : "Basic",

"username" : "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

},

"enableSsl" : true

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Ejemplo de HBase genérico:

{

"name": "HBaseLinkedService",

"properties": {

"type": "HBase",

"typeProperties": {

"host" : "<host e.g. 192.168.222.160>",

"port" : "<port>",

"httpPath" : "<e.g. /gateway/sandbox/hbase/version>",

"authenticationType" : "Basic",

"username" : "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

},

"enableSsl" : true,

"trustedCertPath" : "<trustedCertPath>",

"allowHostNameCNMismatch" : true,

"allowSelfSignedServerCert" : true

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Si desea ver una lista completa de las secciones y propiedades disponibles para definir conjuntos de datos, consulte el artículo sobre conjuntos de datos. En esta sección se proporciona una lista de las propiedades compatibles con el conjunto de datos de HBase.

Para copiar datos de HBase, establezca la propiedad type del conjunto de datos en HBaseObject. Se admiten las siguientes propiedades:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del conjunto de datos debe establecerse en: HBaseObject | Sí |

| tableName | Nombre de la tabla. | No (si se especifica "query" en el origen de la actividad) |

Ejemplo

{

"name": "HBaseDataset",

"properties": {

"type": "HBaseObject",

"typeProperties": {},

"schema": [],

"linkedServiceName": {

"referenceName": "<HBase linked service name>",

"type": "LinkedServiceReference"

}

}

}

Si desea ver una lista completa de las secciones y propiedades disponibles para definir actividades, consulte el artículo sobre canalizaciones. En esta sección se proporciona una lista de las propiedades compatibles con el origen de HBase.

Para copiar datos de HBase, establezca el tipo de origen de la actividad de copia en HBaseSource. Se admiten las siguientes propiedades en la sección source de la actividad de copia:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del origen de la actividad de copia debe establecerse en: HBaseSource | Sí |

| Query | Use la consulta SQL personalizada para leer los datos. Por ejemplo: "SELECT * FROM MyTable". |

No (si se especifica "tableName" en el conjunto de datos) |

Ejemplo:

"activities":[

{

"name": "CopyFromHBase",

"type": "Copy",

"inputs": [

{

"referenceName": "<HBase input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "HBaseSource",

"query": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Para obtener información detallada sobre las propiedades, consulte Actividad de búsqueda.

Para obtener una lista de almacenes de datos que la actividad de copia admite como orígenes y receptores, vea Almacenes de datos que se admiten.

Eventos

31 mar, 23 - 2 abr, 23

Evento de aprendizaje de Fabric, Power BI y SQL más grande. 31 de marzo – 2 de abril. Use el código FABINSIDER para ahorrar $400.

Regístrate hoyCursos

Módulo

Ejecución de bases de datos de OSS de nivel de petabytes con HBase de HDInsight - Training

Ejecución de bases de datos de OSS de nivel de petabytes con HBase de HDInsight

Certificación

Microsoft Certified: Azure Data Engineer Associate - Certifications

Demostrar la comprensión de las tareas comunes de ingeniería de datos para implementar y administrar cargas de trabajo de ingeniería de datos en Microsoft Azure mediante una serie de servicios de Azure.

Documentación

Copia de datos de Hive - Azure Data Factory & Azure Synapse

Aprenda a copiar datos de Hive en almacenes de datos receptores compatibles mediante una actividad de copia en una canalización de Azure Data Factory o Synapse Analytics.

Copia de datos de HDFS - Azure Data Factory & Azure Synapse

Obtenga información sobre cómo copiar datos desde un origen HDFS (en la nube o en un entorno local) a almacenes de datos receptores compatibles usando una actividad de copia en una canalización de Azure Data Factory o Synapse Analytics.

Copia de datos con almacenes de datos ODBC - Azure Data Factory & Azure Synapse

Obtenga información sobre cómo copiar datos con almacenes de datos de ODBC como origen y destino mediante una actividad de copia de una canalización de Azure Data Factory o Synapse Analytics.